NeuralArchitectureSearch

[Paper Note] RF-DETR: Neural Architecture Search for Real-Time Detection Transformers, Isaac Robinson+, arXiv'25, 2025.11

Paper/Blog Link My Issue

#ComputerVision #Transformer #Encoder-Decoder #ObjectDetection #Realtime Issue Date: 2025-11-14 GPT Summary- RF-DETRは、オープンボキャブラリ検出器の一般化問題を解決するために導入された軽量の専門検出トランスフォーマーであり、重み共有ニューラルアーキテクチャサーチ(NAS)を用いて精度とレイテンシのトレードオフを評価します。RF-DETRは、COCOおよびRoboflow100-VLで従来の手法を大幅に上回り、特にRF-DETR(2x-large)はCOCOで60 APを超えた初のリアルタイム検出器です。 Comment

元ポスト:

[Paper Note] STAR: Synthesis of Tailored Architectures, Armin W. Thomas+, ICLR'25, 2024.11

Paper/Blog Link My Issue

#NeuralNetwork #MachineLearning #NLP #ICLR Issue Date: 2025-09-27 GPT Summary- 新しいアプローチ(STAR)を提案し、特化したアーキテクチャの合成を行う。線形入力変動システムに基づく探索空間を用い、アーキテクチャのゲノムを階層的にエンコード。進化的アルゴリズムでモデルの品質と効率を最適化し、自己回帰型言語モデリングにおいて従来のモデルを上回る性能を達成。 Comment

openreview: https://openreview.net/forum?id=HsHxSN23rM

[Paper Note] Jet-Nemotron: Efficient Language Model with Post Neural Architecture Search, Yuxian Gu+, arXiv'25

Paper/Blog Link My Issue

#EfficiencyImprovement #NLP #LanguageModel #SmallModel #Reference Collection Issue Date: 2025-08-26 GPT Summary- Jet-Nemotronは新しいハイブリッドアーキテクチャの言語モデルで、フルアテンションモデルと同等以上の精度を持ちながら生成スループットを大幅に改善します。Post Neural Architecture Search(PostNAS)を用いて開発され、事前トレーニングされたモデルから効率的にアテンションブロックを探索します。Jet-Nemotron-2Bモデルは、他の先進モデルに対して高い精度を達成し、生成スループットを最大53.6倍向上させました。 Comment

元ポスト:

著者ポスト:

解説:

所見:

解説:

続報:

コードとチェックポイントがリリース

code: https://github.com/NVlabs/Jet-Nemotron

HF: https://huggingface.co/collections/jet-ai/jet-nemotron-68ac76e8356b5399ef83ac9c

[Paper Note] Can GPT-4 Perform Neural Architecture Search?, Mingkai Zheng+, arXiv'23, 2023.04

Paper/Blog Link My Issue

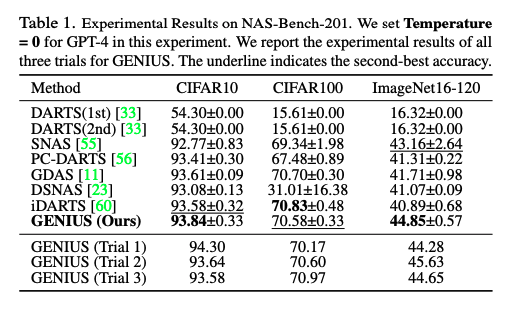

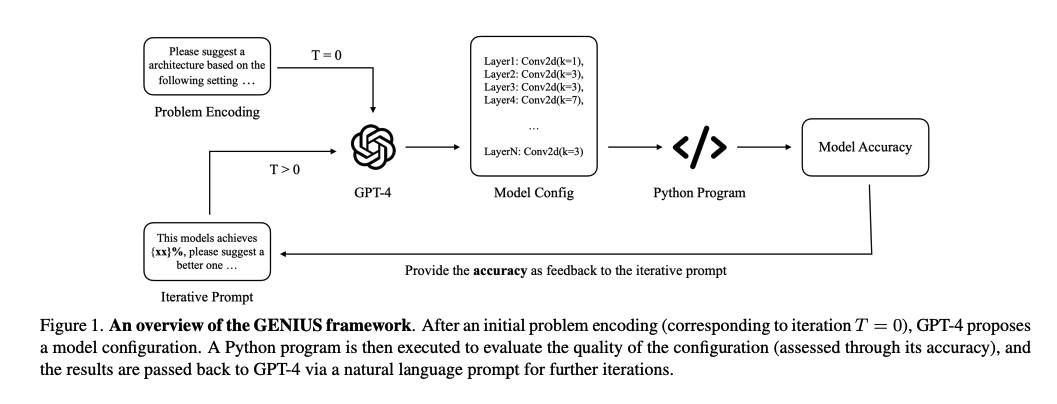

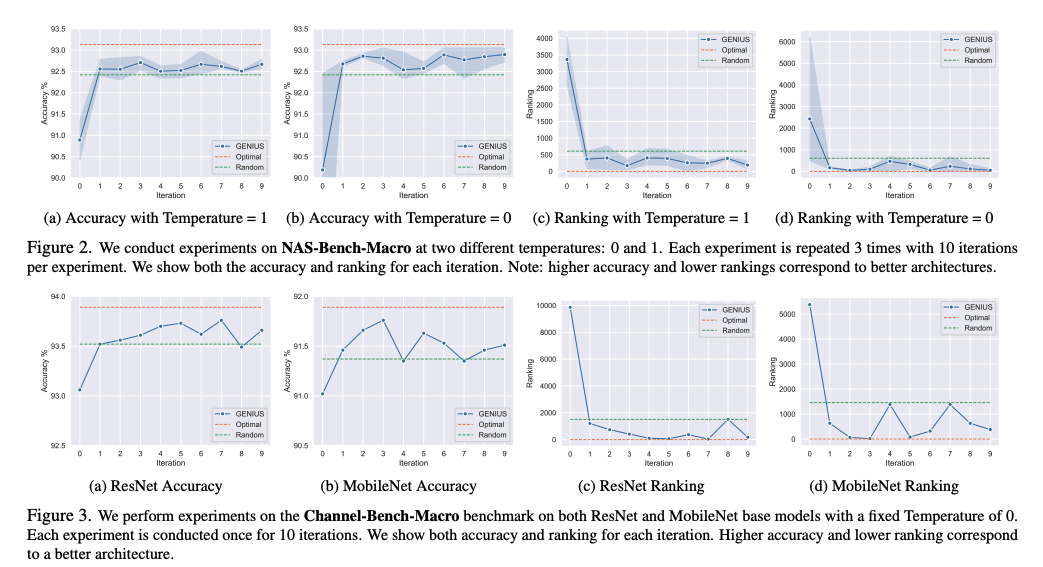

#MachineLearning #NLP #LanguageModel #KeyPoint Notes Issue Date: 2023-04-27 GPT Summary- GPT-4を用いたニューラルアーキテクチャ探索(NAS)に関する研究を行い、提案手法GENIUSはGPT-4の生成能力を活用してアーキテクチャ探索空間を迅速にナビゲート、候補を特定し性能を向上させる。いくつかのベンチマークで評価し、既存のNAS技術と比較してその効果を示す。特に、限られたドメイン知識を要するプロンプト手法を通じてGPT-4が技術問題の研究に貢献する可能性を強調。さらに、研究の制約やAIの安全性への影響についても言及。 Comment

ドメイン知識の必要のないプロンプトで、ニューラルモデルのアーキテクチャの提案をGPTにしてもらう研究。accをフィードバックとして与え、良い構造を提案するといったループを繰り返す模様

Neural Architecture Search (NAS)においては、ランダムベースラインがよく採用されるらしく、比較した結果ランダムよりよかった

NAS201と呼ばれるベンチマーク(NNアーキテクチャのcell blockをデザインすることにフォーカス; 探索空間は4つのノードと6つのエッジで構成される密接続のDAGとして表される; ノードはfeature mapを表し、エッジはoperationに対応;利用可能なoperationが5つあるため、可能な検索空間の総数は5の6乗で15,625通りとなる)でも評価した結果、提案手法の性能がよかったとのこと。