ChatGPT

On The Planning Abilities of OpenAI's o1 Models: Feasibility, Optimality, and Generalizability, Kevin Wang+, N_A, arXiv'24, 2024.11

Paper/Blog Link My Issue

#NLP Issue Date: 2024-11-02 GPT Summary- 本研究では、OpenAIのo1モデルの計画能力を評価し、実現可能性、最適性、一般化の3つの側面に焦点を当てています。特に、制約の多いタスクや空間的に複雑な環境における強みとボトルネックを特定しました。o1-previewは、構造化された環境での制約遵守においてGPT-4を上回る一方で、冗長なアクションを伴う最適でない解を生成し、一般化に苦労しています。この研究は、LLMsの計画における限界を明らかにし、今後の改善の方向性を示しています。 Comment

o1のplanningの性能について知りたくなったら読む

[Paper Note] Can Large Language Models Be an Alternative to Human Evaluations?, Cheng-Han Chiang+, ACL'23, 2023.05

Paper/Blog Link My Issue

#Analysis #LanguageModel #Evaluation #LLM-as-a-Judge #Attack #ACL #Selected Papers/Blogs #KeyPoint Notes Issue Date: 2023-07-22 GPT Summary- 人間評価の再現性が低いため、NLPモデル間の公正な比較が難しい。そこで、大規模言語モデル(LLM)を人間評価の代替手段として利用することを探求。本研究では、LLMに同一指示とサンプルを与え、評価を実施するLLM評価を提案。オープンエンドのストーリー生成や敵対的攻撃のタスクに対する評価結果は、人間専門家の評価と高い一致を示し、評価の安定性も確認。LLMを用いたテキスト評価の可能性やその限界、倫理的課題についても考察。 Comment

LLMがテキストの品質評価において、人間による評価者の代替となりうるか?という疑問を初めて実験的に示した研究で、インパクトが大きく重要論文と判断。ただし、実験のスコープは物語生成と敵対的生成(テキスト分類器を騙すような摂動を加える)の2タスクである点、には注意。

ChatGPT(おそらくGPT-3.5)が人間の評価者(3人のEnglish teacher)とopen-endで生成された物語にたいして、以下の4つの観点に関してratingの平均で見た時に同様の傾向のスコアを付与することを実験的に明らかにした:

- Grammaticality [^1]: テキストの文法の正しさ

- Cohesiveness: テキストの一貫性

- Likeability: テキストが読んでいて楽しいか

- Relevance: promptに対してどれだけ適切なテキストが生成されているか

ただし、T0やtext-curie-001 においてはこのような傾向は見受けられなかった。[^2]

また、ChatGPTによる説明とratingを人間の評価者に対してblindで提示したところ、人間が見ても妥当な判断だと認知された。

全体の傾向としてではなく、個別のratingがどの程度同じような傾向を示すか(i.e., 人間があるstoryを高くratingしたら、LLMも高くratingするか?)をケンドールの順位相関係数で分析(200サンプルに対して3人の英語教員のスコアの平均, text-davinciによる3回の独立したratingを実施した平均スコアを用いて計算)したところ、4つの観点のうち全てにおいて正の相関が見受けられた(Table2, p-valueは<0.05で統計的に有意)。が、Relevanceのみが強い相関を示し、他の指標については弱い相関にとどまっている。しかし、Table6に示されている通り、2人の英語の先生同士で個別のjudgeに感して同様にケンドールの順位相関係数を測定しても、人間-LLM間と同様の傾向が見受けられる。すなわち、Relevanceのみが強い相関で他は弱い相関。このことから、人間同士でも個別のサンプルに対する判断は一致しない(=主観的なタスク)ということは留意する必要がある。

敵対的生成に関する実験については、Synonym Substitution Attack (SSAs; 良性のサンプルを同義語で置換する手法で、全体的な意味は保たれるため一般的な人間は正しく認知してしまうが、実際には文法がおかしくなったり不自然になったり、意味が変わってしまうことが先行研究によって知られているようなものらしい)によって実験。Fluency / Meaning Preservingの2つの指標で英語教員とLLMによる評価を比較した結果、人間は正しくadversarialなサンプルと良性なサンプルを区別できており、ChatGPT(おそらくGPT-3.5)も区別ができている(Table4)。ただし、人間のスコアと比較するとChatGPTは高めのスコアを出す傾向がある点には注意ではあるものの、良性サンプル > 敵対的サンプル という序列の判断に関しては人間と同様の傾向を示していることが示唆された。

[^1]: ただし、LLMはpunctuationのミスを文法エラーと判断するが、一人の英語の先生は文法エラーとしてみなさないなどの現象も観察され、人間は独自の評価criteriaを保持していることも窺える

[^2]: (感想)ある程度能力の高いLLMかRLHFなどを用いて人間の好みに対してalignmentがとられていないとうまくいかないのかもしれない

本研究は非常に初期の研究であり、現在のfrontierモデル群(特にreasoningモデル)を用いた場合にはどの程度改善しているか?という点は気になる。

How is ChatGPT's behavior changing over time?, Lingjiao Chen+, N_A, arXiv'23

Paper/Blog Link My Issue

#NLP #Evaluation Issue Date: 2023-07-22 GPT Summary- GPT-3.5とGPT-4は、大規模言語モデル(LLM)のサービスであり、その性能と振る舞いは時間とともに変動することがわかった。例えば、GPT-4は素数の特定に優れていたが、後のバージョンでは低い正答率となった。また、GPT-3.5はGPT-4よりも優れた性能を示した。さらに、GPT-4とGPT-3.5の両方が時間とともに敏感な質問への回答やコード生成でのミスが増えた。この結果から、LLMの品質を継続的に監視する必要性が示唆される。 Comment

GPT3.5, GPT4共にfreezeされてないのなら、研究で利用すると結果が再現されないので、研究で使うべきではない。

↑(2025.10追記)

当時の私はこのように感じたようだが、以下を確認した方が良いと思う:

- 実験設定として、エンドポイントのモデル名にはタイムスタンプが付与されているが、同じモデルシリーズの異なるタイムスタンプモデル間の比較なのか、それとも全く同じタイムスタンプのモデルでの比較なのか

- サンプリングパラメータの設定や推論の試行回数なとがreliableな比較ができうる設定になっているか。

あとは上記を確認したとしても、研究で使うべきではない、は言い過ぎで、実験の比較対象の一部として使う分には良いと思う(ただし、実験結果の主要な知見は再現可能な設定から得られるべきと考える。

(当時は随分脊髄反射的にコメントを書いていますね…)

A Review of ChatGPT Applications in Education, Marketing, Software Engineering, and Healthcare: Benefits, Drawbacks, and Research Directions, Mohammad Fraiwan+, N_A, arXiv'23

Paper/Blog Link My Issue

#Survey #Education Issue Date: 2023-05-04 GPT Summary- - ChatGPTは、深層学習アルゴリズムを使用して人間らしい応答を生成する人工知能言語モデルである。- 最新のChatGPTバージョンが導入され、他の言語モデルも登場している。- これらのモデルは、教育、ソフトウェアエンジニアリング、医療、マーケティングなどの分野で応用可能性がある。- 本論文では、これらのモデルの可能な応用、制限、欠点、および研究方向について議論する。

[Paper Note] AI, write an essay for me: A large-scale comparison of human-written versus ChatGPT-generated essays, Steffen Herbold+, arXiv'23

Paper/Blog Link My Issue

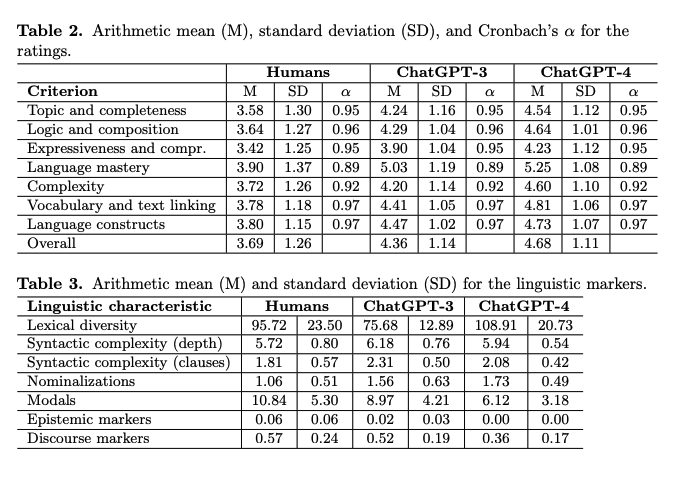

#NLP #LanguageModel #Education #AES(AutomatedEssayScoring) #One-Line Notes Issue Date: 2023-04-28 GPT Summary- ChatGPTが生成したエッセイは、人間が書いたものよりも質が高いと評価されることが大規模な研究で示された。生成されたエッセイは独自の言語的特徴を持ち、教育者はこの技術を活用する新たな教育コンセプトを開発する必要がある。 Comment

ChatGPTは人間が書いたエッセイよりも高品質なエッセイが書けることを示した。

また、AIモデルの文体は、人間が書いたエッセイとは異なる言語的特徴を示している。たとえば、談話や認識マーカーが少ないが、名詞化が多く、語彙の多様性が高いという特徴がある、とのこと。

[Paper Note] Evaluating ChatGPT's Information Extraction Capabilities: An Assessment of Performance, Explainability, Calibration, and Faithfulness, Bo Li+, arXiv'23, 2023.04

Paper/Blog Link My Issue

#NLP #Explanation #InformationExtraction #Evaluation #KeyPoint Notes #Reading Reflections Issue Date: 2023-04-25 GPT Summary- 本研究では、ChatGPTの能力を7つの情報抽出(IE)タスクを通じて評価し、パフォーマンス、説明可能性、キャリブレーション、信頼性を分析しました。標準IE設定ではパフォーマンスが低い一方、オープンIE設定では人間評価で優れた結果を示しました。ChatGPTは高品質な説明を提供するものの、予測に対して過信する傾向があり、キャリブレーションが低いことが明らかになりました。また、元のテキストに対して高い信頼性を示しました。研究のために手動で注釈付けした7つのIEタスクのテストセットと14のデータセットを公開しています。 Comment

情報抽出タスクにおいてChatGPTを評価した研究。スタンダードなIEの設定ではBERTベースのモデルに負けるが、OpenIEの場合は高い性能を示した。

また、ChatGPTは予測に対してクオリティが高く信頼に足る説明をしたが、一方で自信過剰な傾向がある。また、ChatGPTの予測はinput textに対して高いfaithfulnessを示しており、予測がinputから根ざしているものであることがわかる。(らしい)

あまりしっかり読めていないが、Entity Typing, NER, Relation Classification, Relation Extraction, Event Detection, Event Argument Extraction, Event Extractionで評価。standardIEでは、ChatGPTにタスクの説明と選択肢を与え、与えられた選択肢の中から正解を探す設定とした。一方OpenIEでは、選択肢を与えず、純粋にタスクの説明のみで予測を実施させた。OpenIEの結果を、3名のドメインエキスパートが出力が妥当か否か判定した結果、非常に高い性能を示すことがわかった。表を見ると、同じタスクでもstandardIEよりも高い性能を示している(そんなことある???)

つまり、選択肢を与えてどれが正解ですか?ときくより、選択肢与えないでCoTさせた方が性能高いってこと?比較可能な設定で実験できているのだろうか。promptは付録に載っているが、output exampleが載ってないのでなんともいえない。StandardIEの設定をしたときに、CoTさせてるかどうかが気になる。もししてないなら、そりゃ性能低いだろうね、という気がする。

Training language models to follow instructions with human feedback, Long Ouyang+, N_A, NeurIPS'22

Paper/Blog Link My Issue

#NLP #LanguageModel #Alignment #RLHF #PPO (ProximalPolicyOptimization) #PostTraining #read-later #Selected Papers/Blogs #KeyPoint Notes Issue Date: 2024-04-28 GPT Summary- 大規模な言語モデルは、ユーザーの意図に合わない出力を生成することがあります。本研究では、人間のフィードバックを使用してGPT-3を微調整し、InstructGPTと呼ばれるモデルを提案します。この手法により、13億パラメータのInstructGPTモデルの出力が175BのGPT-3の出力よりも好まれ、真実性の向上と有害な出力の削減が示されました。さらに、一般的なNLPデータセットにおける性能の低下は最小限でした。InstructGPTはまだ改善の余地がありますが、人間のフィードバックを使用した微調整が有望な方向であることを示しています。 Comment

ChatGPTの元となる、SFT→Reward Modelの訓練→RLHFの流れが提案された研究。DemonstrationデータだけでSFTするだけでは、人間の意図したとおりに動作しない問題があったため、人間の意図にAlignするように、Reward Modelを用いたRLHFでSFTの後に追加で学習を実施する。Reward Modelは、175Bモデルは学習が安定しなかった上に、PPOの計算コストが非常に大きいため、6BのGPT-3を様々なNLPタスクでSFTしたモデルをスタートにし、モデルのアウトプットに対して人間がランキング付けしたデータをペアワイズのloss functionで訓練した。最終的に、RMのスコアが最大化されるようにSFTしたGPT-3をRLHFで訓練するが、その際に、SFTから出力が離れすぎないようにする項と、NLPベンチマークでの性能が劣化しないようにpretrain時のタスクの性能もloss functionに加えている。

Introducing GPT‑5.4, OpenAI, 2026.03

Paper/Blog Link My Issue

#Article #NLP #LanguageModel #Proprietary #Reference Collection Issue Date: 2026-03-06 Comment

元ポスト:

Artiflcial Analysisによる評価:

GPT‑5.3 Instant:よりスムーズで、日常会話にもっと役立つ, OpenAI, 2026.03

Paper/Blog Link My Issue

#Article #NLP #LanguageModel #Blog #Proprietary Issue Date: 2026-03-04 Comment

元ポスト:

なんだかなあ

Introducing Prism, OpenAI, 2026.01

Paper/Blog Link My Issue

#Article #NLP #LanguageModel #AIAgents #GenerativeAI #MultiModal #AcademicWriting #DeepResearch #One-Line Notes Issue Date: 2026-01-29 Comment

デモを見るとdraftをベースに関連研究をdeepresearchしてワンクリックでbibtexにexport, ホワイトボードに描いた図をドラッグ&ドロップして論文に反映などしている。Overleafの競合。

元ポスト:

所見:

ChatGPT ヘルスケアが登場, OpenAI, 2026.01

Paper/Blog Link My Issue

#Article #GenerativeAI #Blog #Health Issue Date: 2026-01-09 Comment

元ポスト:

Reverse Engineering a Phase Change in GPT's Training Data... with the Seahorse Emoji 🌊🐴, PRATYUSH MAINI, 2025.12

Paper/Blog Link My Issue

#Article #Analysis #NLP #LanguageModel #Reasoning #SelfCorrection #mid-training #One-Line Notes Issue Date: 2025-12-28 Comment

元ポスト:

Is there seahorse emoji?という質問に対するLLMのreasoning trajectoryと、self correctionの挙動が、OpenAIのどの時点のモデルで出現するか、しないかを線引くことで、mid-trainingにself correction形式のデータが追加されたのがいつ頃なのかを考察している。

ChatGPTの記憶システムはRAGを使っていなかった - 4層アーキテクチャの衝撃, UrayahaDays, 2025.12

Paper/Blog Link My Issue

#Article #Blog Issue Date: 2025-12-15 Comment

元ポスト:

GPT-5.2 が登場 専門的な業務や長時間稼働するエージェント向けの、最先端のフロンティアモデル。, OpenAI, 2025.12

Paper/Blog Link My Issue

#Article #NLP #LanguageModel #GenerativeAI #Reasoning #Proprietary #Selected Papers/Blogs Issue Date: 2025-12-12 Comment

元ポスト:

OpenAIがGPT-5.2をリリースし、再び様々なベンチマークにおいてGemini 3 Proをoutperform。

フロントエンド開発(デザイン)(アリーナ形式)ではOpus, Gemini 3 Proの勝利らしい:

https://www.designarena.ai

ポイント解説:

GDPval:

- [Paper Note] GDPval: Evaluating AI Model Performance on Real-World Economically Valuable Tasks, Tejal Patwardhan+, arXiv'25, 2025.10

- GDPVAL: EVALUATING AI MODEL PERFORMANCE ON REAL-WORLD ECONOMICALLY VALUABLE TASKS, Patwardhan+, 2025.09

GDPvalのclearwinがGPT-5.2- Thinkingで49.8%なので、14年程度の専門家がこなす米国主要産業の一部のタスクは数値上は置き換え可能という風に見える。Proに至っては60.0%である。

が、GDPvalはたとえば以下のようなlimitationがあり、数値の解釈には注意が必要である:

- 完全なcontextが与えられる前提

- 暗黙知が多いタスクは対象外

- 自己完結型で他社とのコミュニケーションが必要とされないタスクを対象

- 1職種あたり30タスク程度の限定的な網羅性

- コンピュータを利用したタスクのみ

- ...

実際の現場で活用しようと思うと、完全なcontextを揃えられるか、揃わない場合に不完全なcontextでタスクを遂行できるか、そのための社内での運用フローの整備等、モデルを活用するための周辺のシステムや運用フローの設計が重要(かつ膨大)である点には(ベンチマークのスコアを見ると驚くべき進歩だが)留意する必要がある。

Vals AI IndexというGDPvalに類似したベンチマークでもSoTAとのこと:

関連:

非常に簡単な論理的な推論でも誤る例:

GPT-5.1: A smarter, more conversational ChatGPT, OpenAI, 2025.11

Paper/Blog Link My Issue

#Article #NLP #LanguageModel #Blog #Reasoning #Proprietary #Selected Papers/Blogs #Routing #One-Line Notes #Reference Collection Issue Date: 2025-11-13 Comment

元ポスト:

instantモデルはよりあたたかい応答でより指示追従能力を高め、thinkingモデルは入力に応じてより適応的に思考トークン数を調整する。autoモデルは入力に応じてinstant, thinkingに適切にルーティングをする。

所見:

Artificial Analysisによるベンチマーキング:

GPT-5.1-Codex-maxの50% time horizon:

Introducing ChatGPT Atlas, OpenAI, 2025.10

Paper/Blog Link My Issue

#Article #GenerativeAI #Blog Issue Date: 2025-10-23 Comment

元ポスト:

ブラウザのサイドバーでchatgptにサイトに関して質問できたり、agenticな使い方もできる模様?

nanochat, karpathy, 2025.10

Paper/Blog Link My Issue

#Article #EfficiencyImprovement #Pretraining #NLP #LanguageModel #Supervised-FineTuning (SFT) #ReinforcementLearning #Repository #mid-training #GRPO #read-later #Selected Papers/Blogs #Inference #MinimalCode #KV Cache Issue Date: 2025-10-22 Comment

元ポスト:

新たなスピードランが...!!

FP8で記録更新とのこと:

nano chatの過去の改善のポイントまとめ:

nanochatにおいてKarpathy氏がAIによる自動改善をするエージェントをセットアップしたところ、12時間で110の変更が加わり、ValLossを0.864215から0.85039まで改善しているとのこと。

現在の最高性能は2時間で0.71854なのでまだまだ及んでいないが、このまま回しておいたらどこまで改善するだろうか?

ポストに本人が返信をしているが、Karpathy氏の関心は、どのハーネスがnanochatに最も大きな改善をもたらすか、という点らしい。

OpenAI DevDay 2025 発表まとめ, ぬこぬこ, 2025.10

Paper/Blog Link My Issue

#Article #Tutorial #Blog Issue Date: 2025-10-08 Comment

元ポスト:

Why GPT-5 used less training compute than GPT-4.5 (but GPT-6 probably won’t), EPOCH AI, 2025.09

Paper/Blog Link My Issue

#Article #Analysis #Pretraining #NLP #LanguageModel #Blog #PostTraining Issue Date: 2025-09-29 Comment

元ポスト:

OpenAI o1 System Card, OpenAI, 2024.12

Paper/Blog Link My Issue

#Article #NLP #LanguageModel #Reasoning #Proprietary Issue Date: 2024-12-10

OpenAI、ChatGPTが画像を分析する『GPT-4V(ビジョン)』を発表。安全性、嗜好性、福祉機能を強化, AIDB, 2023.09

Paper/Blog Link My Issue

#Article #ComputerVision #NLP #LanguageModel #MultiModal Issue Date: 2023-09-30 Comment

おう…やべえな…

HuggingChat, 2023

Paper/Blog Link My Issue

#Article #NLP #LanguageModel #Blog #One-Line Notes Issue Date: 2023-04-27 Comment

closedな世界で開発されるOpenAIのChatGPTに対して、Openなものが必要ということで、huggingfaceが出したchatシステム

公開はすでに終了している模様