ConceptToTextGeneration

NUBIA, EvalNLGEval'20

Paper/Blog Link My Issue

#DocumentSummarization #NaturalLanguageGeneration #Metrics #NLP #DataToTextGeneration #DialogueGeneration #Encoder #KeyPoint Notes Issue Date: 2021-06-02 Comment

TextGenerationに関するSoTAの性能指標。BLEU, ROUGE等と比較して、人間との相関が高い。

pretrainedされたlanguage model(GPT-2=sentence legibility, RoBERTa_MNLI=logical inference, RoBERTa_STS=semantic similarity)を使い、Fully Connected Layerを利用してquality スコアを算出する。算出したスコアは最終的にcalibrationで0~1の値域に収まるように補正される。

意味的に同等の内容を述べた文間でのexample

BLEU, ROUGE, BERTのスコアは低いが、NUBIAでは非常に高いスコアを出せている。

[Paper Note] Toward Controlled Generation of Text, Zhiting Hu+, ICML'17, 2017.03

Paper/Blog Link My Issue

#NeuralNetwork #NaturalLanguageGeneration #Controllable #NLP #DataToTextGeneration #GenerativeAdversarialNetwork #ICML #Selected Papers/Blogs #KeyPoint Notes Issue Date: 2017-12-31 GPT Summary- 属性に基づいて制御された自然言語文を生成するために、変分オートエンコーダと属性識別器を組み合わせた新しい生成モデルを提案。微分可能な近似を用いて解釈可能な表現を学習し、望ましい属性を持つ文を生成。定量的評価で生成の正確性を確認。 Comment

Text Generationを行う際は、現在は基本的に学習された言語モデルの尤度に従ってテキストを生成するのみで、outputされるテキストをcontrolすることができないので、できるようにしましたという論文。 VAEによるテキスト生成にGANを組み合わせたようなモデル。 decodingする元となるfeatureのある次元が、たとえばpolarityなどに対応しており、その次元の数値をいじるだけで生成されるテキストをcontrolできる。

テキストを生成する際に、生成されるテキストをコントロールするための研究。 テキストを生成する際には、基本的にはVariational Auto Encoder(VAE)を用いる。

VAEは、入力をエンコードするEncoderと、エンコードされた潜在変数zからテキストを生成するGeneratorの2つの機構によって構成されている。

この研究では、生成されるテキストをコントロールするために、VAEの潜在変数zに、生成するテキストのattributeを表す変数cを新たに導入。

たとえば、一例として、変数cをsentimentに対応させた場合、変数cの値を変更すると、生成されるテキストのsentimentが変化するような生成が実現可能。

次に、このような生成を実現できるようなパラメータを学習したいが、学習を行う際のポイントは、以下の二つ。

cで指定されたattributeが反映されたテキストを生成するように学習

潜在変数zとattributeに関する変数cの独立性を保つように学習 (cには制御したいattributeに関する情報のみが格納され、その他の情報は潜在変数zに格納されるように学習する)

1を実現するために、新たにdiscriminatorと呼ばれる識別器を用意し、VAEが生成したテキストのattributeをdiscriminatorで分類し、その結果をVAEのGeneratorにフィードバックすることで、attributeが反映されたテキストを生成できるようにパラメータの学習を行う。 (これにはラベル付きデータが必要だが、少量でも学習できることに加えて、sentence levelのデータだけではなくword levelのデータでも学習できる。)

また、2を実現するために、VAEが生成したテキストから、生成する元となった潜在変数zが再現できるようにEncoderのパラメータを学習。

実験では、sentimentとtenseをコントロールする実験が行われており、attributeを表す変数cを変更することで、以下のようなテキストが生成されており興味深い。

[sentimentを制御した例]

this movie was awful and boring. (negative)

this movie was funny and touching. (positive)

[tenseを制御した例]

this was one of the outstanding thrillers of the last decade

this is one of the outstanding thrillers of the all time

this will be one of the great thrillers of the all time

VAEは通常のAutoEncoderと比較して、奥が深くて勉強してみておもしろかった。 Reparametrization Trickなどは知らなかった。

管理人による解説資料:

[Controllable Text Generation.pdf](https://github.com/AkihikoWatanabe/paper_notes/files/1595121/Controllable.Text.Generation.pdf)

slideshare: https://www.slideshare.net/akihikowatanabe3110/towards-controlled-generation-of-text

[Paper Note] Neural Text Generation: A Practical Guide, Ziang Xie, arXiv'17, 2017.11

Paper/Blog Link My Issue

#NeuralNetwork #Survey #NaturalLanguageGeneration #NLP #DataToTextGeneration Issue Date: 2017-12-31 GPT Summary- 深層学習手法はテキスト生成タスクで成功を収めているが、デコーダーが望ましくない出力を生成する問題がある。本論文は、テキスト生成モデルの不具合を解決するための実践的なガイドを提供し、実世界のアプリケーションの実現を目指す。

[Paper Note] Survey of the State of the Art in Natural Language Generation: Core tasks, applications and evaluation, Albert Gatt+, arXiv'17, 2017.03

Paper/Blog Link My Issue

#Survey #NaturalLanguageGeneration #NLP #DataToTextGeneration Issue Date: 2017-12-31 GPT Summary- 本論文は、非言語的入力からテキストや音声を生成する自然言語生成(NLG)の最新技術動向を調査し、(a) NLGのコアタスクに関する研究の統合とアーキテクチャの提示、(b) NLGと他のAI分野との相乗効果による新しい研究トピックの強調、(c) NLG評価の課題と他の自然言語処理分野との関連を明らかにすることを目的としている。 Comment

割と新し目のNLGのSurvey

[Paper Note] Neural Text Generation from Structured Data with Application to the Biography Domain, Remi Lebret+, EMNLP'16, 2016.03

Paper/Blog Link My Issue

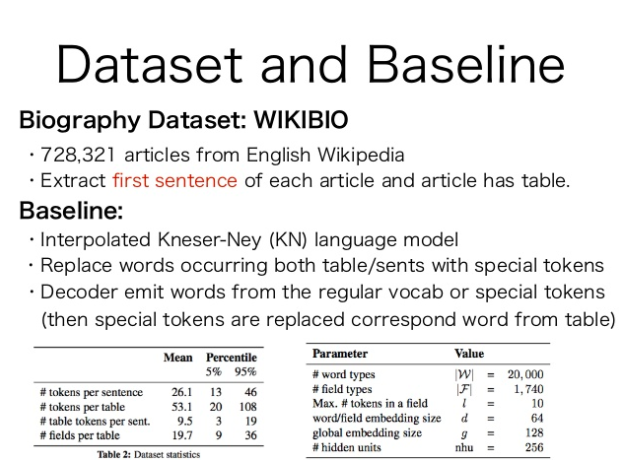

#NeuralNetwork #NaturalLanguageGeneration #NLP #Dataset #EMNLP #Encoder-Decoder #KeyPoint Notes Issue Date: 2017-12-31 GPT Summary- 大規模なWikipediaの伝記データセットを用いて、テキスト生成のためのニューラルモデルを提案。モデルは条件付きニューラル言語モデルに基づき、固定語彙とサンプル固有の単語を組み合わせるコピーアクションを採用。提案モデルは古典的なKneser-Neyモデルを約15 BLEUポイント上回る性能を示した。 Comment

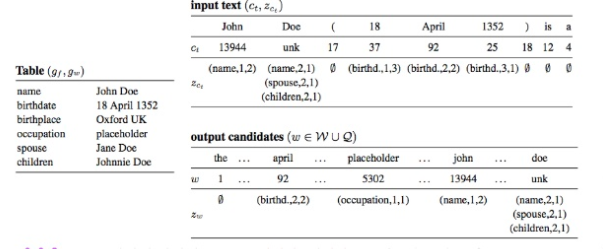

Wikipediaの人物に関するinfo boxから、その人物のbiographyの冒頭を生成するタスク。

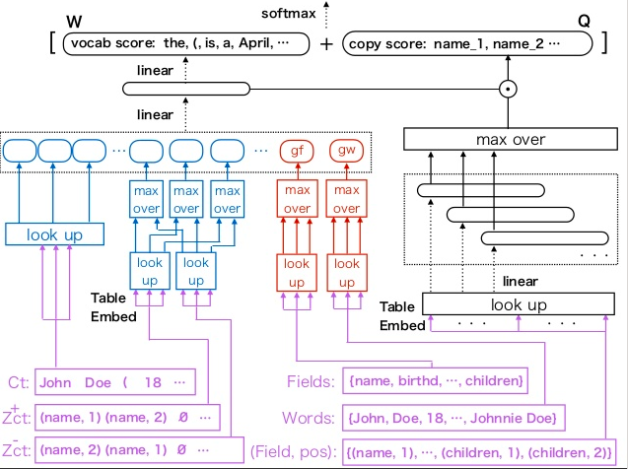

Neural Language Modelに、新たにTableのEmbeddingを入れられるようにtable embeddingを提案し、table conditioned language modelを提案している。

inputはテーブル(図中のinput textっていうのは、少し用語がconfusingだが、言語モデルへのinputとして、過去に生成した単語の系列を入れるというのを示しているだけ)

モデル全体

Wikipediaから生成した、Biographyに関するデータセットも公開している。

template basedなKNSmoothingを使ったベースラインよりも高いBLEUスコアを獲得。さらに、テーブルのGlobalな情報を入れる手法が、性能向上に寄与(たとえばチーム名・リーグ・ポジションなどをそれぞれ独立に見ても、バスケットボールプレイヤーなのか、ホッケープレイヤーなのかはわからないけど、テーブル全体を見ればわかるよねという気持ち)。

[Paper Note] Content Selection in Data-to-Text Systems: A Survey, Dimitra Gkatzia, arXiv'16, 2016.10

Paper/Blog Link My Issue

#Survey #NaturalLanguageGeneration #NLP #DataToTextGeneration #Initial Impression Notes Issue Date: 2017-12-31 GPT Summary- データからテキストへのシステムは、データを自然言語で自動的にレポート生成し、ユーザーの好みに応じた出力を提供する。コンテンツ選択は重要な要素であり、どの情報を伝えるかを決定する。研究では、データからテキスト生成の分野を紹介し、システムのアーキテクチャと最先端のコンテンツ選択手法をレビューし、今後の研究機会について議論する。 Comment

Gkatzia氏の"content selection"に関するSurvey

[Paper Note] Inducing document plans for concept-to-text generation, Konstas+, EMNLP'13

Paper/Blog Link My Issue

#NaturalLanguageGeneration #SingleFramework #NLP #EMNLP Issue Date: 2017-12-31

[Paper Note] Unsupervised concept-to-text generation with hypergraphs, Konstas+, NAACL-HLT'12

Paper/Blog Link My Issue

#NaturalLanguageGeneration #SingleFramework #NLP #NAACL Issue Date: 2017-12-31

[Paper Note] Generative alignment and semantic parsing for learning from ambiguous supervision, Kim+, COLING'10

Paper/Blog Link My Issue

#NaturalLanguageGeneration #SingleFramework #NLP #COLING Issue Date: 2017-12-31

[Paper Note] Learning semantic correspondences with less supervision, Liang+, ACL-IJCNLP'09

Paper/Blog Link My Issue

#NaturalLanguageGeneration #Others #NLP #ACL #IJCNLP Issue Date: 2017-12-31

[Paper Note] Automatic generation of textual summaries from neonatal intensive care data, Porter+, Artificial Intelligence'09, 2009.05

Paper/Blog Link My Issue

#NaturalLanguageGeneration #SingleFramework #NLP #Initial Impression Notes Issue Date: 2017-12-31 Comment

BabyTalk論文

[Paper Note] A generative model for parsing natural language to meaning representations, Lu+, EMNLP'08

Paper/Blog Link My Issue

#NaturalLanguageGeneration #Others #NLP #EMNLP Issue Date: 2017-12-31

[Paper Note] An Architecture for Data to Text Systems, Ehud Reiter, ENLG'07

Paper/Blog Link My Issue

#Survey #NaturalLanguageGeneration #NLP #DataToTextGeneration #Selected Papers/Blogs #One-Line Notes Issue Date: 2017-12-31 Comment

NLG分野で有名なReiterらのSurvey。

NLGシステムのアーキテクチャなどが、体系的に説明されている。

[Paper Note] Aggregation via set partitioning for natural language generation, Barzilay+, HLT-NAACL'06

Paper/Blog Link My Issue

#NaturalLanguageGeneration #DataDriven #NLP #NAACL Issue Date: 2017-12-31

[Paper Note] Collective content selection for concept-to-text generation, Barzilay+, HLT_EMNLP'05

Paper/Blog Link My Issue

#NaturalLanguageGeneration #DataDriven #NLP #EMNLP Issue Date: 2017-12-31

[Paper Note] Coral: Using natural language generation for navigational assistance, Dale+, Australasian computer science conference'03, 2003.02

Paper/Blog Link My Issue

#NaturalLanguageGeneration #RuleBased #NLP Issue Date: 2017-12-31

[Paper Note] A Global Model for Concept-to-Text Generation, Konstas+, Journal of Artificial Intelligence Research, Vol. 48, pp.305--346, 2013.10

Paper/Blog Link My Issue

#Article #NaturalLanguageGeneration #SingleFramework #NLP Issue Date: 2017-12-31