RetrievalAugmentedGeneration

#Analysis#InformationRetrieval#Pocket#NLP#LanguageModel

Issue Date: 2024-11-19 Likelihood as a Performance Gauge for Retrieval-Augmented Generation, Tianyu Liu+, arXiv24 Commentトークンレベルの平均値をとった生成テキストの対数尤度と、RAGの回答性能に関する分析をした模様。とりあえず、もし「L参考: ... #InformationRetrieval#Pocket#NLP#LanguageModel

Issue Date: 2024-11-10 HyQE: Ranking Contexts with Hypothetical Query Embeddings, Weichao Zhou+, arXiv24 Comment#1498 も参照のこと。 下記に試しにHyQEとHyDEの比較の記事を作成したのでご参考までに(記事の内容に私は手を加えていないのでHallucinationに注意)。ざっくりいうとHyDEはpseudo documentsを使うが、HyQEはpseudo queryを扱う。 [参とりあえず、もし「L参考: ... #InformationRetrieval#Pocket#NLP#LanguageModel

Issue Date: 2024-11-10 HyQE: Ranking Contexts with Hypothetical Query Embeddings, Weichao Zhou+, arXiv24 Comment#1498 も参照のこと。 下記に試しにHyQEとHyDEの比較の記事を作成したのでご参考までに(記事の内容に私は手を加えていないのでHallucinationに注意)。ざっくりいうとHyDEはpseudo documentsを使うが、HyQEはpseudo queryを扱う。 [参 ... #InformationRetrieval#NLP#Dataset#Evaluation

Issue Date: 2024-10-20 Fact, Fetch, and Reason: A Unified Evaluation of Retrieval-Augmented Generation, Satyapriya Krishna+, N_A, arXiv24 CommentRAGのfactuality, retrieval acculacy, reasoningを評価するためのmulti hop puestionとそれに回答するための最大15のwikipedia記事のベンチマーク元ポスト:https://x.com/_philschmid/status/184062 ... #InformationRetrieval#Pocket#NLP#Chain-of-Thought

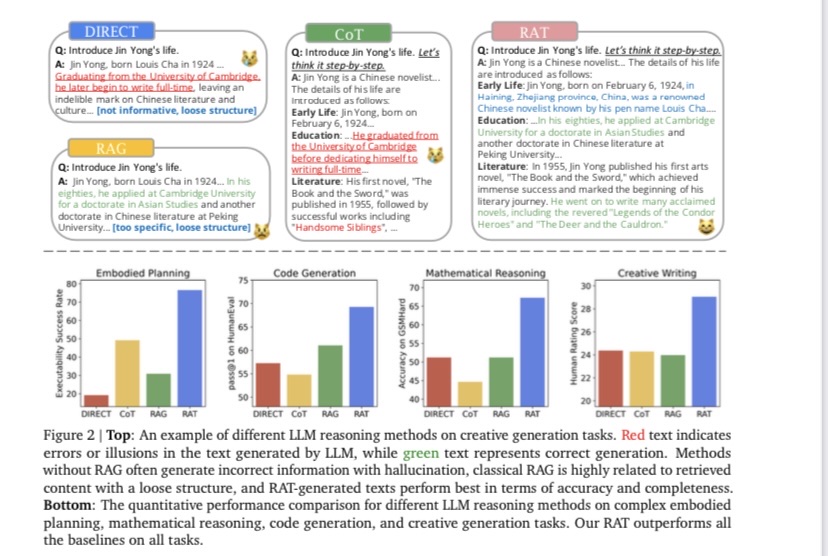

Issue Date: 2024-04-14 RAT: Retrieval Augmented Thoughts Elicit Context-Aware Reasoning in Long-Horizon Generation, Zihao Wang+, N_A, arXiv24 Summary大規模言語モデルの推論および生成能力を向上させ、幻覚を軽減する方法として、情報検索を利用して思考の連鎖を修正する「retrieval-augmented thoughts(RAT)」が提案された。この方法は、ゼロショットのCoTが生成された後、取得した情報を使用して各思考ステップを修正する。GPT-3.5、GPT-4、およびCodeLLaMA-7bにRATを適用することで、コード生成、数学的推論、創造的な執筆、具体的なタスク計画などのタスクでパフォーマンスが大幅に向上した。デモページはhttps://craftjarvis.github.io/RATで利用可能。 CommentRAGにおいてCoTさせる際に、各reasoningのstepを見直させることでより質の高いreasoningを生成するRATを提案。Hallucinationが低減し、生成のパフォーマンスも向上するとのこと。コンセプト自体はそりゃそうだよねという話なので、RAGならではの課題があり、それを解決した ... #InformationRetrieval#Pocket#NLP#LanguageModel#Finetuning (SFT)

#InformationRetrieval#Pocket#NLP#LanguageModel#Finetuning (SFT)

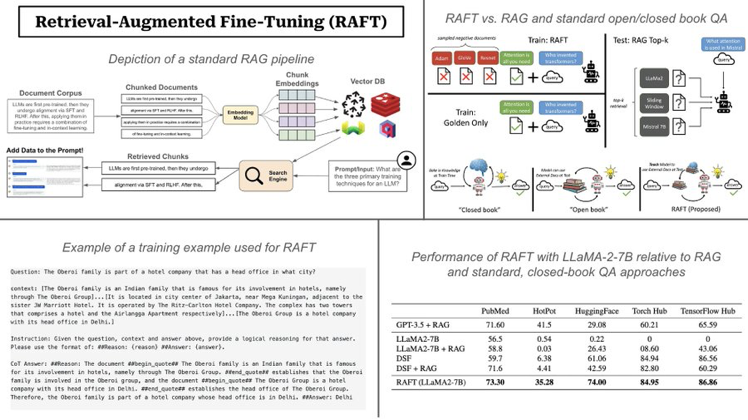

Issue Date: 2024-04-07 RAFT: Adapting Language Model to Domain Specific RAG, Tianjun Zhang+, N_A, arXiv24 Summary大規模なテキストデータのLLMsを事前学習し、新しい知識を追加するためのRetrieval Augmented FineTuning(RAFT)を提案。RAFTは、質問に回答するのに役立つ関連文書から正しいシーケンスを引用し、chain-of-thoughtスタイルの応答を通じて推論能力を向上させる。RAFTはPubMed、HotpotQA、Gorillaデータセットでモデルのパフォーマンスを向上させ、事前学習済みLLMsをドメイン固有のRAGに向けて改善する。 CommentQuestion, instruction, coxtext, cot style answerの4つを用いてSFTをする模様画像は下記ツイートより引用https://x.com/cwolferesearch/status/1770912695765660139?s=46&t=Y6UuIHB0 ... #Pocket#NLP#LanguageModel#Chain-of-Thought#Prompting

#Pocket#NLP#LanguageModel#Chain-of-Thought#Prompting

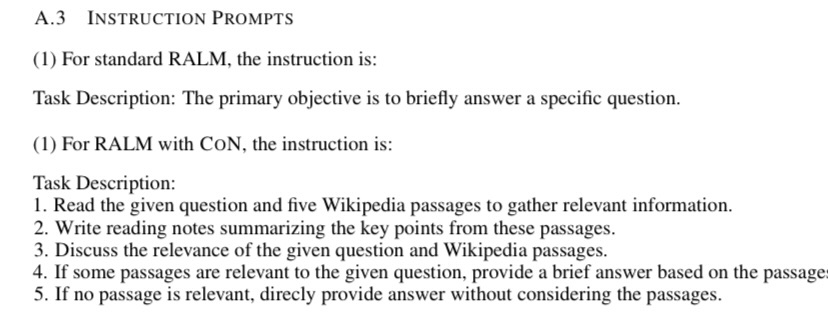

Issue Date: 2023-11-17 Chain-of-Note: Enhancing Robustness in Retrieval-Augmented Language Models, Wenhao Yu+, N_A, arXiv23 Summary検索補完言語モデル(RALM)は、外部の知識源を活用して大規模言語モデルの性能を向上させるが、信頼性の問題や知識の不足による誤った回答がある。そこで、Chain-of-Noting(CoN)という新しいアプローチを導入し、RALMの頑健性を向上させることを目指す。CoNは、順次の読み取りノートを生成し、関連性を評価して最終的な回答を形成する。ChatGPTを使用してCoNをトレーニングし、実験結果はCoNを装備したRALMが標準的なRALMを大幅に上回ることを示している。特に、ノイズの多いドキュメントにおいてEMスコアで平均+7.9の改善を達成し、知識範囲外のリアルタイムの質問に対する拒否率で+10.5の改善を達成している。 Comment一番重要な情報がappendixに載っているCoNによって、ノイズがあった場合にゲインが大きい。 ... #Pocket#NLP#LanguageModel#Evaluation#FactualConsistency

#Pocket#NLP#LanguageModel#Evaluation#FactualConsistency

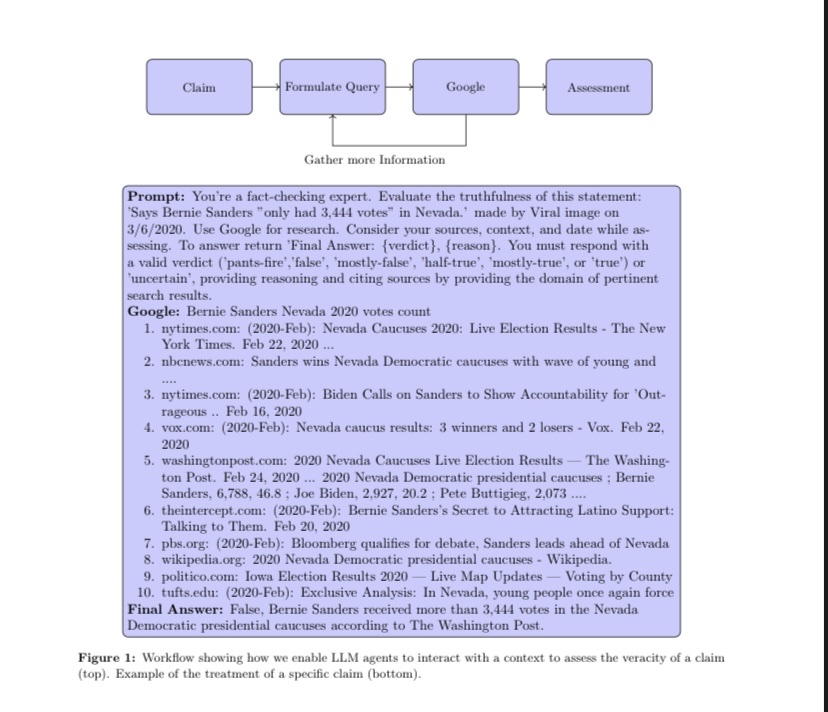

Issue Date: 2023-11-05 The Perils & Promises of Fact-checking with Large Language Models, Dorian Quelle+, N_A, arXiv23 Summary自律型の事実チェックにおいて、大規模言語モデル(LLMs)を使用することが重要である。LLMsは真実と虚偽を見分ける役割を果たし、その出力を検証する能力がある。本研究では、LLMエージェントを使用して事実チェックを行い、推論を説明し、関連する情報源を引用する能力を評価した。結果は、文脈情報を備えたLLMsの能力の向上を示しているが、正確性には一貫性がないことに注意が必要である。今後の研究では、成功と失敗の要因をより深く理解する必要がある。 Commentgpt3とgpt4でFactCheckして傾向を分析しました、という研究。promptにstatementとgoogleで補完したcontextを含め、出力フォーマットを指定することでFactCheckする。promptingする際の言語や、statementの事実性の度合い(半分true, 全て斜 ... #NLP#LanguageModel#FactualConsistency

#NLP#LanguageModel#FactualConsistency

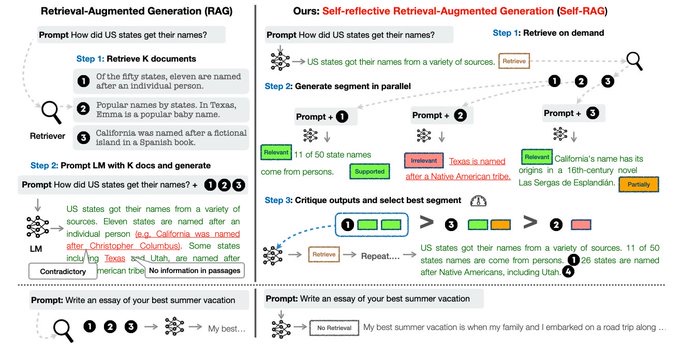

Issue Date: 2023-10-29 Self-RAG: Learning to Retrieve, Generate, and Critique through Self-Reflection, Akari Asai+, N_A, arXiv23 Summary大規模言語モデル(LLMs)は、事実に基づかない回答を生成することがあります。そこで、自己反省的な検索増強生成(Self-RAG)という新しいフレームワークを提案します。このフレームワークは、検索と自己反省を通じてLLMの品質と事実性を向上させます。実験結果は、Self-RAGが最先端のLLMsおよび検索増強モデルを大幅に上回ることを示しています。 CommentRAGをする際の言語モデルの回答の質とfactual consistencyを改善せるためのフレームワーク。reflection tokenと呼ばれる特殊トークンを導入し、言語モデルが生成の過程で必要に応じて情報をretrieveし、自身で生成内容を批評するように学習する。単語ごとに生成するのでは ... #Pocket#NLP#LanguageModel

#Pocket#NLP#LanguageModel

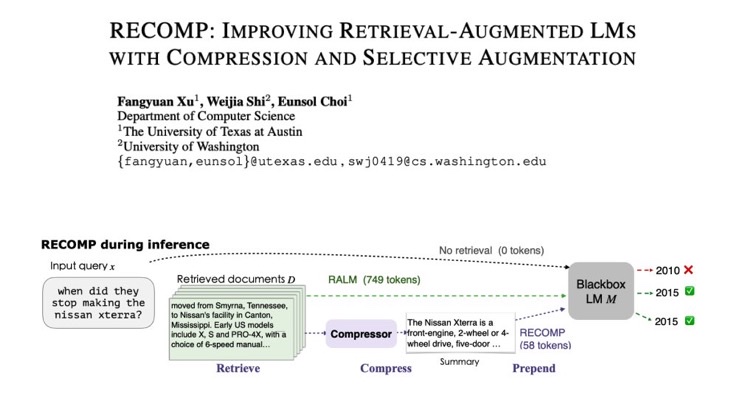

Issue Date: 2023-10-10 RECOMP: Improving Retrieval-Augmented LMs with Compression and Selective Augmentation, Fangyuan Xu+, N_A, arXiv23 Summaryドキュメントの要約を生成することで、言語モデルの性能を向上させる手法を提案する。抽出型の圧縮器と抽象型の圧縮器を使用し、LMsの入力に要約を追加して訓練する。実験結果では、圧縮率が6%まで達成され、市販の要約モデルを上回る性能を示した。また、訓練された圧縮器は他のLMsにも転移可能であることが示された。 CommentRetrieval Augmentationをする際に、元文書群を要約して圧縮することで、性能低下を抑えながら最大6%程度まで元文書群を圧縮できた、とのこと。元ツイート: https://x.com/omarsar0/status/1711384213092479130?s=46&t=Y6UuIHB ... #Pocket#NLP#LanguageModel

#Pocket#NLP#LanguageModel

Issue Date: 2023-10-09 Retrieval meets Long Context Large Language Models, Peng Xu+, N_A, arXiv23 Summary最先端の事前学習済みLLMsを使用して、リトリーバル拡張と長いコンテキストウィンドウの組み合わせについて研究しました。結果として、リトリーバル拡張LLMsは、ファインチューニングLLMsと比較しても高いパフォーマンスを示し、計算量も少ないことがわかりました。さらに、リトリーバルはLLMsのパフォーマンスを向上させることができることが示されました。リトリーバル拡張LLMsは、質問応答や要約などのタスクにおいて、他のモデルよりも優れた性能を発揮し、生成速度も速いです。この研究は、実践者にとってリトリーバル拡張と長いコンテキストウィンドウのLLMsの選択に関する洞察を提供します。 Comment参考: https://x.com/hillbig/status/1711502993508671670?s=46&t=Y6UuIHB0Lv0IpmFAjlc2-Q検索補強(Retrieval Augmentation)とは、言語モデルの知識を補完するために、関連する文書を外部の文書集合からとってき ... #InformationRetrieval#Pocket#NLP#LanguageModel

Issue Date: 2024-11-11 Precise Zero-Shot Dense Retrieval without Relevance Labels, Luyu Gao+, arXiv22 #Pocket

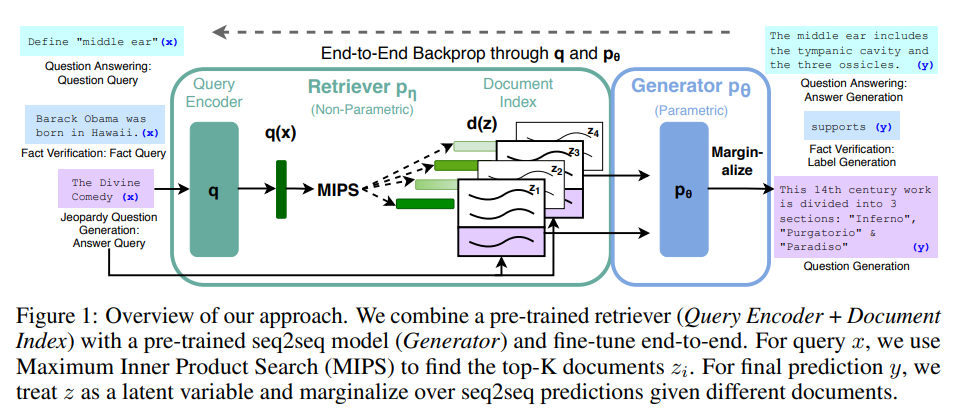

Issue Date: 2023-12-01 Retrieval-Augmented Generation for Knowledge-Intensive NLP Tasks, Patrick Lewis+, N_A, arXiv20 Summary大規模な事前学習言語モデルを使用した検索強化生成(RAG)の微調整手法を提案しました。RAGモデルは、パラメトリックメモリと非パラメトリックメモリを組み合わせた言語生成モデルであり、幅広い知識集約的な自然言語処理タスクで最先端の性能を発揮しました。特に、QAタスクでは他のモデルを上回り、言語生成タスクでは具体的で多様な言語を生成することができました。 CommentRAGを提案した研究 ... #Article#Tutorial#InformationRetrieval#NLP

#Article#Tutorial#InformationRetrieval#NLP

Issue Date: 2024-11-07 RAGの改善方法に関する情報のまとめ(再掲), GENZITSU, 2023.10 #Article#InformationRetrieval#Pocket#NLP#LanguageModel#Article

Issue Date: 2024-09-29 RAGの実装戦略まとめ, Jin Watanabe, 2024.03 #Article#Pocket#NLP#QuestionAnswering#LLMAgent#GenerativeAI#Repository

Issue Date: 2024-09-11 PaperQA2, 2023.02 Comment元ポスト: https://x.com/sgrodriques/status/1833908643856818443?s=46&t=Y6UuIHB0Lv0IpmFAjlc2-Q ... #Article#Embeddings#InformationRetrieval#NLP#Article

Issue Date: 2024-09-08 Late Chunking: Balancing Precision and Cost in Long Context Retrieval, Pierse+, 2024.09 Commentchunkingしてからembeddingを取得するより、全体のドキュメントに対してcontextualなtoken embeddingを取得し、その後chunkingをしてpoolingしてsingle vectorにする方が、文書の文脈情報がembedding内で保持されやすいので、precis ... #Article#Repository

Issue Date: 2024-08-29 kotaemon, 2024.05 CommentRAGのための美しいユーザと開発者向けのUI。カスタマイズも可能らしい ... #Article#InformationRetrieval#Pocket#NLP#LanguageModel#Article

Issue Date: 2024-08-09 RAG入門: 精度改善のための手法28選, 2024.08 #Article#NLP#LanguageModel#LongSequence

Issue Date: 2024-07-03 RetrievaBERTの公開, 2024 CommentRAGへ応用する際に、長いコンテキストを扱いEmbeddingを獲得したいシーンが増えたので、最大でコンテキスト長が2048のBERTを学習し公開。Apache2.0 オリジナルのBERTと比較して、近年のLLMで有用性が示されている以下をアーキテクチャに取り入れている SwiGLU活性 ... #Article#Tutorial#Survey#InformationRetrieval#NLP#LanguageModel#Article

Issue Date: 2024-03-05 RAG-Research-Insights CommentRAGに関する研究が直近のものまでよくまとめられている ... #Article#InformationRetrieval#NLP#LanguageModel

Issue Date: 2024-02-11 RAGの性能を改善するための8つの戦略 Commentめちゃめちゃ詳細にRAG性能向上の手法がreference付きでまとまっている。すごい。 ... #Article#QuestionAnswering

Issue Date: 2024-01-16 日本語WikipediaQAデータセット(Retrievalプロセス付き) #Article

Issue Date: 2023-12-23 GPTsより精度の高いRAGシステムの構築 #Article#InformationRetrieval#NLP#Article

Issue Date: 2023-12-21 Structured Hierarchical Retrieval, llama-index Comment元ツイート: https://x.com/llama_index/status/1737515390664872040?s=46&t=Y6UuIHB0Lv0IpmFAjlc2-Q ... #Article#InformationRetrieval#Article

Issue Date: 2023-12-21 Build a search engine, not a vector DB #Article#InformationRetrieval#NLP#LanguageModel#Article

Issue Date: 2023-12-04 kaggle LLM コンペ 上位解法を自分なりにまとめてみた話 Comment実践的な内容(チャンク生成時の工夫、クエリ生成時の工夫等)が網羅的にまとまっており非常に有用個人的に、コンペ主催者側から提供されたデータが少なく、上位のほとんどのチームがChatGPT(3.5, 4)を用いて、QAデータを生成していた、というのが興味深かった。プロンプトはたとえば下記: [(5th- ... #Article#Tutorial#Article

Issue Date: 2023-11-22 Deconstructing RAG CommentRAGにおける様々な戦略がまとまっている(リンク付き ... #Article#NLP#LanguageModel#Evaluation#Article

Issue Date: 2023-11-21 Zephyr-7B-beta, RAG Perf. CommentZephyr-7B-betaのRAGでの性能がデータセットで評価されている下記Xポストによるとgpt-3.5-turboと同等https://x.com/rungalileo/status/1726638537767051436?s=46&t=Y6UuIHB0Lv0IpmFAjlc2-Q ... #Article#NLP#Article

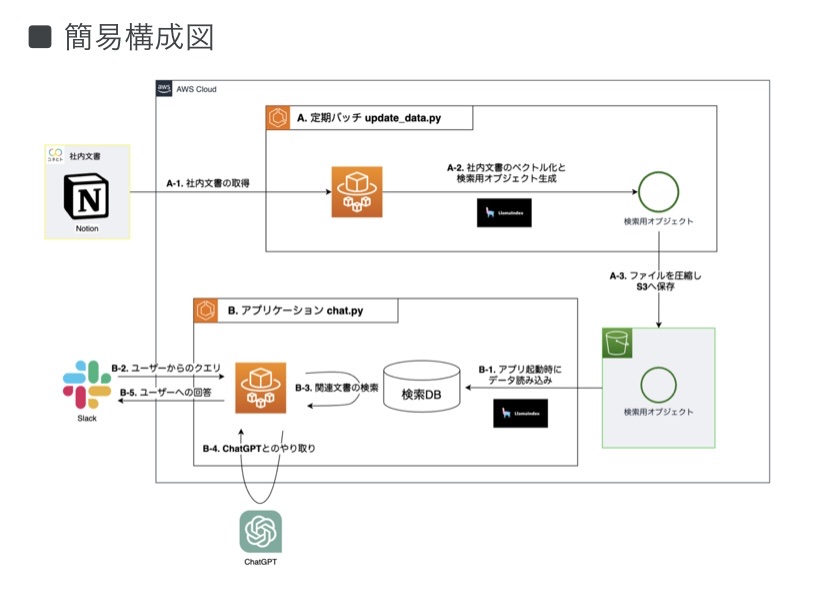

Issue Date: 2023-11-15 ChatGPTに社内文書に基づいた回答を生成させる仕組みを構築しました, 2023 Comment低コストで社内文書に対するRAGを実現することに注力している。以下、図はブログから引用。基本的にはバッチジョブで社内文書をベクトル化しS3へ格納。アプリ起動時にS3から最新データを読み込み検索可能にしRAGするという流れ。低コスト化のために、Embedding作成にOpenSourceの特に日本語テ ... #Article#Pocket#Article

#Article#Pocket#Article

Issue Date: 2023-11-13 Boosting RAG: Picking the Best Embedding & Reranker models #Article#Tutorial#InformationRetrieval#NLP#LanguageModel

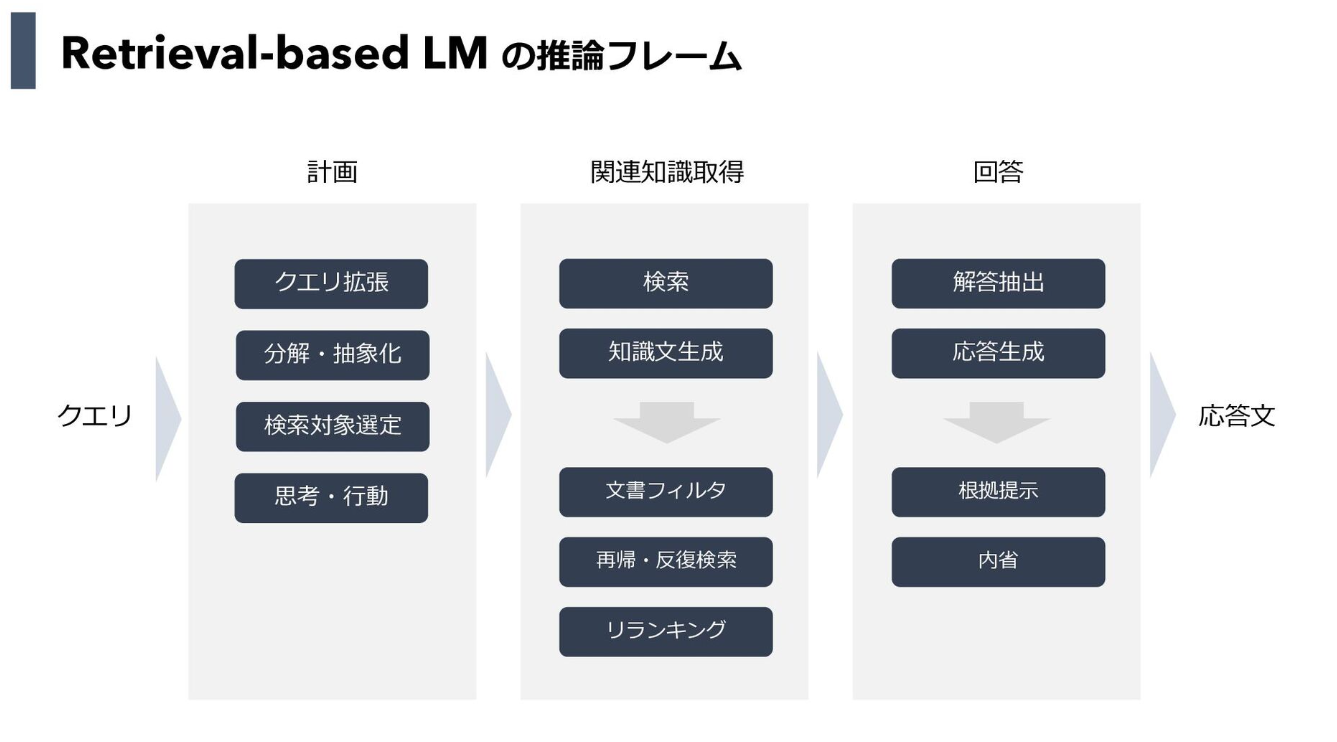

Issue Date: 2023-11-06 Retrieval-based LM (RAG System)ざっくり理解する, 2023 Comment(以下スクショはスライドより引用) 次のスクショはRAGにかかわる周辺技術がよくまとまっていると思う。 以下ざっくり私の中の認識として 計画 クエリ拡張 クエリの質が悪い場合検索性能が劣化するため、クエリをより適切に検索ができるように修正(昔 ... #Article#Tools#NLP#LanguageModel#Library#Evaluation#Article

#Article#Tools#NLP#LanguageModel#Library#Evaluation#Article

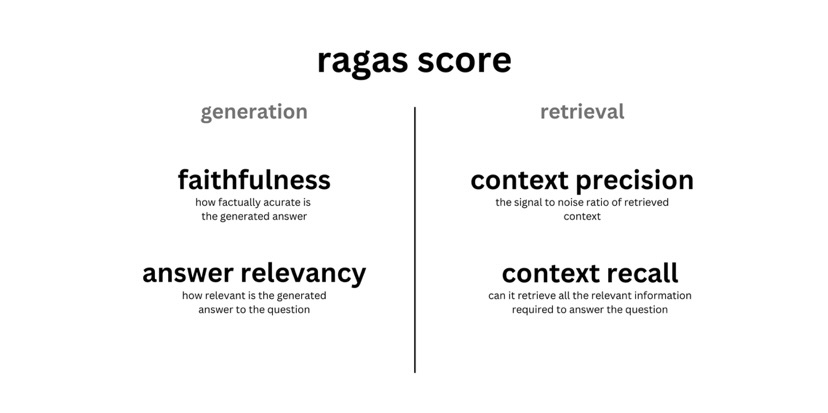

Issue Date: 2023-10-29 Evaluating RAG Pipelines CommentRAG pipeline (retrieval + generation)を評価するライブラリRagasについて紹介されている。評価に活用される指標は下記で、背後にLLMを活用しているため、大半の指標はラベルデータ不要。ただし、context_recallを測定する場合はreference an ... #Article#Tools#NLP#LanguageModel#Library#Article

#Article#Tools#NLP#LanguageModel#Library#Article

Issue Date: 2023-10-29 LangChainのRAGの改善法, LayerX機械学習勉強会 Comment以下リンクからの引用。LangChainから提供されているRetrieverのcontext抽出の性能改善のためのソリューション> Multi representation indexing:検索に適した文書表現(例えば要約)の作成Query transformation:人間の質問を変換して ...

Issue Date: 2024-10-20 Retrieval Augmented Generation (RAG) and Beyond: A Comprehensive Survey on How to Make your LLMs use External Data More Wisely, Siyun Zhao+, N_A, arXiv24 CommentRAGのクエリを4種類に分類した各クエリごとの技術をまとめたSurvey ... #InformationRetrieval#NLP#Dataset#Evaluation

Issue Date: 2024-10-20 Fact, Fetch, and Reason: A Unified Evaluation of Retrieval-Augmented Generation, Satyapriya Krishna+, N_A, arXiv24 CommentRAGのfactuality, retrieval acculacy, reasoningを評価するためのmulti hop puestionとそれに回答するための最大15のwikipedia記事のベンチマーク元ポスト:https://x.com/_philschmid/status/184062 ... #InformationRetrieval#Pocket#NLP#Chain-of-Thought

Issue Date: 2024-04-14 RAT: Retrieval Augmented Thoughts Elicit Context-Aware Reasoning in Long-Horizon Generation, Zihao Wang+, N_A, arXiv24 Summary大規模言語モデルの推論および生成能力を向上させ、幻覚を軽減する方法として、情報検索を利用して思考の連鎖を修正する「retrieval-augmented thoughts(RAT)」が提案された。この方法は、ゼロショットのCoTが生成された後、取得した情報を使用して各思考ステップを修正する。GPT-3.5、GPT-4、およびCodeLLaMA-7bにRATを適用することで、コード生成、数学的推論、創造的な執筆、具体的なタスク計画などのタスクでパフォーマンスが大幅に向上した。デモページはhttps://craftjarvis.github.io/RATで利用可能。 CommentRAGにおいてCoTさせる際に、各reasoningのstepを見直させることでより質の高いreasoningを生成するRATを提案。Hallucinationが低減し、生成のパフォーマンスも向上するとのこと。コンセプト自体はそりゃそうだよねという話なので、RAGならではの課題があり、それを解決した ...

Issue Date: 2024-04-07 RAFT: Adapting Language Model to Domain Specific RAG, Tianjun Zhang+, N_A, arXiv24 Summary大規模なテキストデータのLLMsを事前学習し、新しい知識を追加するためのRetrieval Augmented FineTuning(RAFT)を提案。RAFTは、質問に回答するのに役立つ関連文書から正しいシーケンスを引用し、chain-of-thoughtスタイルの応答を通じて推論能力を向上させる。RAFTはPubMed、HotpotQA、Gorillaデータセットでモデルのパフォーマンスを向上させ、事前学習済みLLMsをドメイン固有のRAGに向けて改善する。 CommentQuestion, instruction, coxtext, cot style answerの4つを用いてSFTをする模様画像は下記ツイートより引用https://x.com/cwolferesearch/status/1770912695765660139?s=46&t=Y6UuIHB0 ...

Issue Date: 2023-11-17 Chain-of-Note: Enhancing Robustness in Retrieval-Augmented Language Models, Wenhao Yu+, N_A, arXiv23 Summary検索補完言語モデル(RALM)は、外部の知識源を活用して大規模言語モデルの性能を向上させるが、信頼性の問題や知識の不足による誤った回答がある。そこで、Chain-of-Noting(CoN)という新しいアプローチを導入し、RALMの頑健性を向上させることを目指す。CoNは、順次の読み取りノートを生成し、関連性を評価して最終的な回答を形成する。ChatGPTを使用してCoNをトレーニングし、実験結果はCoNを装備したRALMが標準的なRALMを大幅に上回ることを示している。特に、ノイズの多いドキュメントにおいてEMスコアで平均+7.9の改善を達成し、知識範囲外のリアルタイムの質問に対する拒否率で+10.5の改善を達成している。 Comment一番重要な情報がappendixに載っているCoNによって、ノイズがあった場合にゲインが大きい。 ...

Issue Date: 2023-11-05 The Perils & Promises of Fact-checking with Large Language Models, Dorian Quelle+, N_A, arXiv23 Summary自律型の事実チェックにおいて、大規模言語モデル(LLMs)を使用することが重要である。LLMsは真実と虚偽を見分ける役割を果たし、その出力を検証する能力がある。本研究では、LLMエージェントを使用して事実チェックを行い、推論を説明し、関連する情報源を引用する能力を評価した。結果は、文脈情報を備えたLLMsの能力の向上を示しているが、正確性には一貫性がないことに注意が必要である。今後の研究では、成功と失敗の要因をより深く理解する必要がある。 Commentgpt3とgpt4でFactCheckして傾向を分析しました、という研究。promptにstatementとgoogleで補完したcontextを含め、出力フォーマットを指定することでFactCheckする。promptingする際の言語や、statementの事実性の度合い(半分true, 全て斜 ...

Issue Date: 2023-10-29 Self-RAG: Learning to Retrieve, Generate, and Critique through Self-Reflection, Akari Asai+, N_A, arXiv23 Summary大規模言語モデル(LLMs)は、事実に基づかない回答を生成することがあります。そこで、自己反省的な検索増強生成(Self-RAG)という新しいフレームワークを提案します。このフレームワークは、検索と自己反省を通じてLLMの品質と事実性を向上させます。実験結果は、Self-RAGが最先端のLLMsおよび検索増強モデルを大幅に上回ることを示しています。 CommentRAGをする際の言語モデルの回答の質とfactual consistencyを改善せるためのフレームワーク。reflection tokenと呼ばれる特殊トークンを導入し、言語モデルが生成の過程で必要に応じて情報をretrieveし、自身で生成内容を批評するように学習する。単語ごとに生成するのでは ...

Issue Date: 2023-10-10 RECOMP: Improving Retrieval-Augmented LMs with Compression and Selective Augmentation, Fangyuan Xu+, N_A, arXiv23 Summaryドキュメントの要約を生成することで、言語モデルの性能を向上させる手法を提案する。抽出型の圧縮器と抽象型の圧縮器を使用し、LMsの入力に要約を追加して訓練する。実験結果では、圧縮率が6%まで達成され、市販の要約モデルを上回る性能を示した。また、訓練された圧縮器は他のLMsにも転移可能であることが示された。 CommentRetrieval Augmentationをする際に、元文書群を要約して圧縮することで、性能低下を抑えながら最大6%程度まで元文書群を圧縮できた、とのこと。元ツイート: https://x.com/omarsar0/status/1711384213092479130?s=46&t=Y6UuIHB ...

Issue Date: 2023-10-09 Retrieval meets Long Context Large Language Models, Peng Xu+, N_A, arXiv23 Summary最先端の事前学習済みLLMsを使用して、リトリーバル拡張と長いコンテキストウィンドウの組み合わせについて研究しました。結果として、リトリーバル拡張LLMsは、ファインチューニングLLMsと比較しても高いパフォーマンスを示し、計算量も少ないことがわかりました。さらに、リトリーバルはLLMsのパフォーマンスを向上させることができることが示されました。リトリーバル拡張LLMsは、質問応答や要約などのタスクにおいて、他のモデルよりも優れた性能を発揮し、生成速度も速いです。この研究は、実践者にとってリトリーバル拡張と長いコンテキストウィンドウのLLMsの選択に関する洞察を提供します。 Comment参考: https://x.com/hillbig/status/1711502993508671670?s=46&t=Y6UuIHB0Lv0IpmFAjlc2-Q検索補強(Retrieval Augmentation)とは、言語モデルの知識を補完するために、関連する文書を外部の文書集合からとってき ... #InformationRetrieval#Pocket#NLP#LanguageModel

Issue Date: 2024-11-11 Precise Zero-Shot Dense Retrieval without Relevance Labels, Luyu Gao+, arXiv22 #Pocket

Issue Date: 2023-12-01 Retrieval-Augmented Generation for Knowledge-Intensive NLP Tasks, Patrick Lewis+, N_A, arXiv20 Summary大規模な事前学習言語モデルを使用した検索強化生成(RAG)の微調整手法を提案しました。RAGモデルは、パラメトリックメモリと非パラメトリックメモリを組み合わせた言語生成モデルであり、幅広い知識集約的な自然言語処理タスクで最先端の性能を発揮しました。特に、QAタスクでは他のモデルを上回り、言語生成タスクでは具体的で多様な言語を生成することができました。 CommentRAGを提案した研究 ...

Issue Date: 2024-11-07 RAGの改善方法に関する情報のまとめ(再掲), GENZITSU, 2023.10 #Article#InformationRetrieval#Pocket#NLP#LanguageModel#Article

Issue Date: 2024-09-29 RAGの実装戦略まとめ, Jin Watanabe, 2024.03 #Article#Pocket#NLP#QuestionAnswering#LLMAgent#GenerativeAI#Repository

Issue Date: 2024-09-11 PaperQA2, 2023.02 Comment元ポスト: https://x.com/sgrodriques/status/1833908643856818443?s=46&t=Y6UuIHB0Lv0IpmFAjlc2-Q ... #Article#Embeddings#InformationRetrieval#NLP#Article

Issue Date: 2024-09-08 Late Chunking: Balancing Precision and Cost in Long Context Retrieval, Pierse+, 2024.09 Commentchunkingしてからembeddingを取得するより、全体のドキュメントに対してcontextualなtoken embeddingを取得し、その後chunkingをしてpoolingしてsingle vectorにする方が、文書の文脈情報がembedding内で保持されやすいので、precis ... #Article#Repository

Issue Date: 2024-08-29 kotaemon, 2024.05 CommentRAGのための美しいユーザと開発者向けのUI。カスタマイズも可能らしい ... #Article#InformationRetrieval#Pocket#NLP#LanguageModel#Article

Issue Date: 2024-08-09 RAG入門: 精度改善のための手法28選, 2024.08 #Article#NLP#LanguageModel#LongSequence

Issue Date: 2024-07-03 RetrievaBERTの公開, 2024 CommentRAGへ応用する際に、長いコンテキストを扱いEmbeddingを獲得したいシーンが増えたので、最大でコンテキスト長が2048のBERTを学習し公開。Apache2.0 オリジナルのBERTと比較して、近年のLLMで有用性が示されている以下をアーキテクチャに取り入れている SwiGLU活性 ... #Article#Tutorial#Survey#InformationRetrieval#NLP#LanguageModel#Article

Issue Date: 2024-03-05 RAG-Research-Insights CommentRAGに関する研究が直近のものまでよくまとめられている ... #Article#InformationRetrieval#NLP#LanguageModel

Issue Date: 2024-02-11 RAGの性能を改善するための8つの戦略 Commentめちゃめちゃ詳細にRAG性能向上の手法がreference付きでまとまっている。すごい。 ... #Article#QuestionAnswering

Issue Date: 2024-01-16 日本語WikipediaQAデータセット(Retrievalプロセス付き) #Article

Issue Date: 2023-12-23 GPTsより精度の高いRAGシステムの構築 #Article#InformationRetrieval#NLP#Article

Issue Date: 2023-12-21 Structured Hierarchical Retrieval, llama-index Comment元ツイート: https://x.com/llama_index/status/1737515390664872040?s=46&t=Y6UuIHB0Lv0IpmFAjlc2-Q ... #Article#InformationRetrieval#Article

Issue Date: 2023-12-21 Build a search engine, not a vector DB #Article#InformationRetrieval#NLP#LanguageModel#Article

Issue Date: 2023-12-04 kaggle LLM コンペ 上位解法を自分なりにまとめてみた話 Comment実践的な内容(チャンク生成時の工夫、クエリ生成時の工夫等)が網羅的にまとまっており非常に有用個人的に、コンペ主催者側から提供されたデータが少なく、上位のほとんどのチームがChatGPT(3.5, 4)を用いて、QAデータを生成していた、というのが興味深かった。プロンプトはたとえば下記: [(5th- ... #Article#Tutorial#Article

Issue Date: 2023-11-22 Deconstructing RAG CommentRAGにおける様々な戦略がまとまっている(リンク付き ... #Article#NLP#LanguageModel#Evaluation#Article

Issue Date: 2023-11-21 Zephyr-7B-beta, RAG Perf. CommentZephyr-7B-betaのRAGでの性能がデータセットで評価されている下記Xポストによるとgpt-3.5-turboと同等https://x.com/rungalileo/status/1726638537767051436?s=46&t=Y6UuIHB0Lv0IpmFAjlc2-Q ... #Article#NLP#Article

Issue Date: 2023-11-15 ChatGPTに社内文書に基づいた回答を生成させる仕組みを構築しました, 2023 Comment低コストで社内文書に対するRAGを実現することに注力している。以下、図はブログから引用。基本的にはバッチジョブで社内文書をベクトル化しS3へ格納。アプリ起動時にS3から最新データを読み込み検索可能にしRAGするという流れ。低コスト化のために、Embedding作成にOpenSourceの特に日本語テ ...

Issue Date: 2023-11-13 Boosting RAG: Picking the Best Embedding & Reranker models #Article#Tutorial#InformationRetrieval#NLP#LanguageModel

Issue Date: 2023-11-06 Retrieval-based LM (RAG System)ざっくり理解する, 2023 Comment(以下スクショはスライドより引用) 次のスクショはRAGにかかわる周辺技術がよくまとまっていると思う。 以下ざっくり私の中の認識として 計画 クエリ拡張 クエリの質が悪い場合検索性能が劣化するため、クエリをより適切に検索ができるように修正(昔 ...

Issue Date: 2023-10-29 Evaluating RAG Pipelines CommentRAG pipeline (retrieval + generation)を評価するライブラリRagasについて紹介されている。評価に活用される指標は下記で、背後にLLMを活用しているため、大半の指標はラベルデータ不要。ただし、context_recallを測定する場合はreference an ...

Issue Date: 2023-10-29 LangChainのRAGの改善法, LayerX機械学習勉強会 Comment以下リンクからの引用。LangChainから提供されているRetrieverのcontext抽出の性能改善のためのソリューション> Multi representation indexing:検索に適した文書表現(例えば要約)の作成Query transformation:人間の質問を変換して ...