SIGIR

[Paper Note] Large Language Models are Versatile Decomposers: Decompose Evidence and Questions for Table-based Reasoning, Yunhu Ye+, SIGIR'23, 2023.01

Paper/Blog Link My Issue

#NLP #LanguageModel #QuestionAnswering #TabularData #KeyPoint Notes Issue Date: 2023-04-28 GPT Summary- LLMを活用して、表ベースの推論における巨大な証拠を小さなサブ証拠に分解し、複雑な質問をシンプルなサブ質問に分解。各ステップで論理と数値計算を分離することで、思考の連鎖における幻覚を防止。提案手法は、TabFactで人間を超える性能を達成。 Comment

テーブルとquestionが与えられた時に、questionをsub-questionとsmall tableにLLMでin-context learningすることで分割。subquestionの解を得るためのsqlを作成しスポットを埋め、hallucinationを防ぐ。最終的にLLM Reasonerが解答を導出する。TabFact Reasoningで初めて人間を超えた性能を発揮。

[Paper Note] Graph Collaborative Signals Denoising and Augmentation for Recommendation, Ziwei Fan+, SIGIR'23, 2023.04

Paper/Blog Link My Issue

#RecommenderSystems #NeuralNetwork #CollaborativeFiltering #GraphBased #KeyPoint Notes #Short Issue Date: 2023-04-26 GPT Summary- 新たなグラフ隣接行列を提案し、ユーザーとアイテムの相互作用を最適化。ユーザー間・アイテム間の相関を組み込み、相互作用のバランスを取ることで、従来の方法よりも顕著な推薦効果を実現。これにより、豊富な相互作用を持つユーザーと乏しいユーザー双方への推薦が改善された。 Comment

グラフ協調フィルタリングを改善する手法を提案している。既存のグラフ協調フィルタリングはユーザ-アイテム間の隣接行列に基づく二部グラフによって学習されるが、これにはいくつか課題がある:

- ノイズが多く、スパースで、バイアスを含み、long tailな性質(ほとんどのユーザがアイテムとほとんどinterctionしていない)を持つがこれらに対処できていない

- また、interactionの情報がリッチなアクティブユーザはinteractionに多くのノイズ情報を含むが、うまくモデル化されていない

- グラフ協調フィルタリングのmessage passinpによって、user間、item間の情報が事前に学習されるが、message passingの回数が増えるとノイズが多くなる

これらに対処するために、学習を2つのプロセスに分ける方法を提案している。具体的には、GCNを用いて、まず通常通り隣接行列に基づいてuser, itemノードのembeddingを事前学習する。続いて、隣接行列に対して下記2種類の拡張を行う。

- user-item interaction: 事前学習したembeddingを用いて、user-item間のTopKのneighborを見つけ、TopKのみにフィルタリングして隣接行列を再構築する(アクティブユーザーはノイズ除去、インアクティブユーザはインタラクション情報の拡張につながる)

- user-user / item-item interaction: 同じく事前学習したembeddingを用いて、それぞれのneighborsを見つけてuser-user, item-item interactionの要素が非ゼロとなるように拡張する(message passingによるノイズを低減しつつ、ユーザ間、アイテム間の情報を取り入れる)

元ポスト:

Transformer Reasoning Network for Personalized Review Summarization, Xu+, SIGIR'21

Paper/Blog Link My Issue

#PersonalizedDocumentSummarization #NLP #review #One-Line Notes Issue Date: 2023-05-06 Comment

先行研究は、review summarizationにおいて生成されるsummaryは、過去にユーザが作成したsummaryのwriting styleやproductに非常に関係しているのに、これらを活用してこなかったので、活用しました(=personalized)という話っぽい

Knowledge Tracing with Sequential Key-Value Memory Networks, Ghodai+, Research School of Computer Science, Australian National University, SIGIR'19

Paper/Blog Link My Issue

#NeuralNetwork #AdaptiveLearning #EducationalDataMining #LearningAnalytics #KnowledgeTracing Issue Date: 2022-04-28

[Paper Note] Neural Rating Regression with Abstractive Tips Generation for Recommendation, Piji Li+, arXiv'17

Paper/Blog Link My Issue

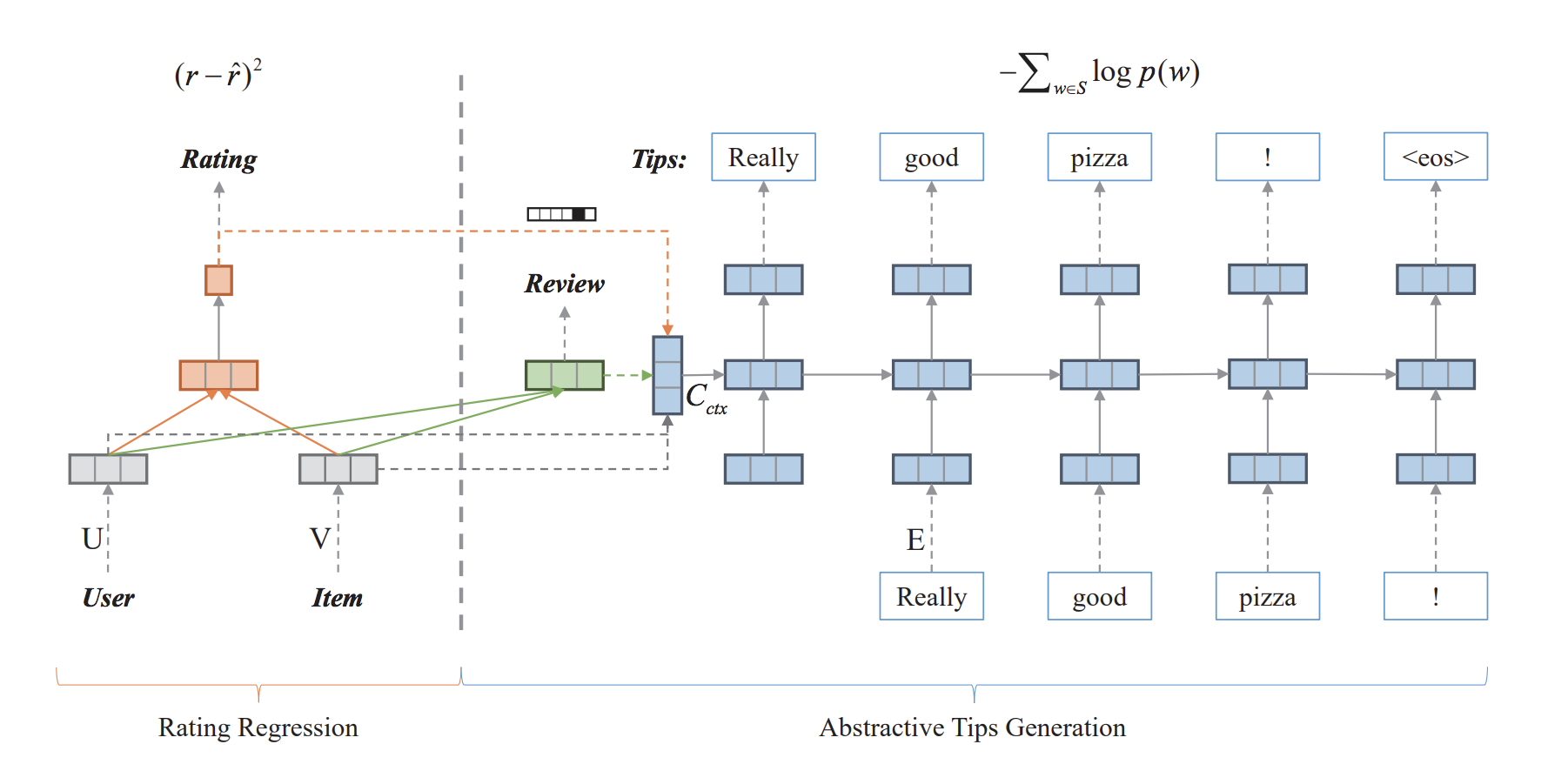

#RecommenderSystems #NeuralNetwork #NLP #ReviewGeneration #KeyPoint Notes Issue Date: 2019-04-12 GPT Summary- Eコマースサイトの新しい「Tips」機能を活用し、ユーザーの経験や感情を表現する短いテキストを生成する深層学習フレームワーク「NRT」を提案。NRTは、ユーザーとアイテムの潜在表現を基に、正確な評価予測と高品質な抽象的ヒントの生成を実現。実験により、NRTは既存手法に対して顕著な改善を示し、ユーザーの体験や感情を効果的に反映することが確認された。 Comment

Rating Predictionとtips generationを同時に行うことで、両者の性能を向上させた最初の研究。

tipsとは、ユーザの経験や感じたことを、短いテキスト(1文とか)で簡潔に記したもの。

モデルについてはあまりく詳しく読んでいないが、図を見る感じ、user latent factorとitem latent factorをMF layerとseq2seqで共有し、同時学習させていると思われる。

おそらく、MFとtext generationをjointで行うNNモデルはこの研究が初めて(textの情報をMFの改善に使おうという試みは古くからやられているが、generationまでは多分やってない)で、このモデル化の仕方がその後のスタンダードになっている。

[Paper Note] Online Learning to Rank for Information Retrieval, Grotov+, SIGIR'16

Paper/Blog Link My Issue

#Tutorial #InformationRetrieval #LearningToRank #Online/Interactive Issue Date: 2018-01-01

[Paper Note] CTSUM: Extracting More Certain Summaries for News Articles, Wan+, SIGIR'14

Paper/Blog Link My Issue

#Multi #Single #DocumentSummarization #Document #Unsupervised #GraphBased #NLP #Extractive #KeyPoint Notes Issue Date: 2018-01-01 Comment

要約を生成する際に、情報の”確実性”を考慮したモデルCTSUMを提案しましたという論文(今まではそういう研究はなかった)

```

"However, it seems that Obama will not use the platform to relaunch his stalled drive for Israeli-Palestinian peace"

```

こういう文は、"It seems"とあるように、情報の確実性が低いので要約には入れたくないという気持ち。

FactBankのニュースコーパスから1000 sentenceを抽出し、5-scaleでsentenceの確実性をラベルづけ。

このデータを用いてSVRを学習し、sentenceの確実性をoutputする分類器を構築

affinity-propagationベース(textrank, lexrankのような手法)手法のaffinityの計算(edge間の重みのこと。普通はsentence同士の類似度とかが使われる)を行う際に、情報の確実性のスコアを導入することで確実性を考慮した要約を生成

DUC2007のMDSデータセットで、affinity計算の際に確実性を導入する部分をablationしたモデル(GRSUM)と比較したところ、CTSUMのROUGEスコアが向上した。

また、自動・人手評価により、生成された要約に含まれる情報の確実性を評価したところ、GRSUMをoutperformした

SIGIRでは珍しい、要約に関する研究

情報の確実性を考慮するという、いままであまりやられていなかった部分にフォーカスしたのはおもしろい

「アイデアはおもしろいし良い研究だが、affinity weightが変化するということは、裏を返せばdamping factorを変更してもそういう操作はできるので、certaintyを考慮したことに意味があったのかが完全に示せていない。」という意見があり、なるほどと思った。

Practical Online Retrieval Evaluation, SIGIR'11, Tutorial

Paper/Blog Link My Issue

#Tutorial #InformationRetrieval #OnlineEvaluation #Slide Issue Date: 2018-01-01

[Paper Note] A support vector method for Optimizing Average Precision, Yue+, SIGIR'07

Paper/Blog Link My Issue

#MachineLearning #StructuredLearning #InformationRetrieval #One-Line Notes Issue Date: 2017-12-31 Comment

SVM-MAPの論文

構造化SVMを用いて、MAPを直接最適化する。

[Paper Note] Personalizing Search via Automated Analysis of Interests and Activities, Teevan+, SIGIR'05, 2005.08

Paper/Blog Link My Issue

#InformationRetrieval #Personalization #One-Line Notes Issue Date: 2017-12-28 Comment

・userに関するデータがrichなほうが、Personalizationは改善する。

・queries, visited web pages, emails, calendar items, stored desktop

documents、全てのsetを用いた場合が最も良かった

(次点としてqueriesのみを用いたモデルが良かった)

[Paper Note] The Use of MMR, Diversity-Based Reranking for Reordering Documents and Producing Summaries, Carbonell+, SIGIR'98

Paper/Blog Link My Issue

#DocumentSummarization #InformationRetrieval #NLP #Search #Selected Papers/Blogs #KeyPoint Notes Issue Date: 2018-01-17 Comment

Maximal Marginal Relevance (MMR) 論文。

検索エンジンや文書要約において、文書/文のランキングを生成する際に、既に選んだ文書と類似度が低く、かつqueryとrelevantな文書をgreedyに選択していく手法を提案。

ILPによる定式化が提案される以前のMulti Document Summarization (MDS) 研究において、冗長性の排除を行う際には典型的な手法。

[Paper Note] A Trainable Document Summarizer, Kupiec+, SIGIR'95

Paper/Blog Link My Issue

#DocumentSummarization #Document #Supervised #NLP #Extractive Issue Date: 2017-12-31

[Paper Note] The Identification of Important Concepts in Highly Structured Technical Papers, ACL-SIGIR'93

Paper/Blog Link My Issue

#PersonalizedDocumentSummarization #NLP #ACL #One-Line Notes Issue Date: 2023-05-13 Comment

ユーザは自分が興味があるpartをsummary evaluationにおいて選択する傾向にある、ということを示した研究

[Paper Note] The Decomposition of Human-Written Summary Sentences, Hongyan Jing+, SIGIR’99

Paper/Blog Link My Issue

#Article #DocumentSummarization #NLP #Selected Papers/Blogs #One-Line Notes #WordAlignment Issue Date: 2018-01-11 Comment

参照要約 - 原文書対が与えられた時に、参照要約中の単語と原文書中の単語のアライメントをとるHMMベースな手法を提案。

outputのサンプルはFigure3参照のこと。

[Paper Note] The automatic construction of large-scale corpora for summarization research, Daniel Marcu, SIGIR’99

Paper/Blog Link My Issue

#Article #DocumentSummarization #NLP #One-Line Notes Issue Date: 2018-01-11 Comment

[Paper Note] Web page summarization using clickthrough data, Sun et al., SIGIR’05, 2005.08

Paper/Blog Link My Issue

#Article #DocumentSummarization #NLP #Snippets Issue Date: 2017-12-28

[Paper Note] SCENE: A Scalable Two-Stage Personalized News Recommendation System, Li et al., SIGIR’11

Paper/Blog Link My Issue

#Article #RecommenderSystems #Document #NewsRecommendation #Personalization #One-Line Notes Issue Date: 2017-12-28 Comment

・ニュース推薦には3つのチャレンジがある。

1. スケーラビリティ より高速なreal-time processing

2. あるニュース記事を読むと、続いて読む記事に影響を与える

3. popularityとrecencyが時間経過に従い変化するので、これらをどう扱うか

これらに対処する手法を提案

[Paper Note] TimedTextRank: Adding the Temporal Dimension to Multi-Document Summarization, Xiaojun Wan, SIGIR’07, 2007.07

Paper/Blog Link My Issue

#Article #DocumentSummarization #NLP #Update #KeyPoint Notes Issue Date: 2017-12-28 Comment

・evolving topicsを要約するときは,基本的に新しい情報が重要だが,TextRankはそれが考慮できないので拡張したという話.

・dynamic document setのnew informationをより重視するTimedTextRankを提案

・TextRankのvoteの部分に重み付けをする.old sentenceからのvoteよりも,new documentsに含まれるsentenceからのvoteをより重要視

・評価のときは,news pageをクローリングし,incremental single-pass clustering algorithmでホットなトピックを抽出しユーザにみせて評価(ただしこれはPreliminary Evaluation).

[Paper Note] Comments-Oriented Document Summarization: Understanding Documents with Reader’s Feedback, Hu+, SIGIR’08, 2008.07

Paper/Blog Link My Issue

#Article #DocumentSummarization #GraphBased #Comments #NLP #Extractive #KeyPoint Notes Issue Date: 2017-12-28