Selected Papers/Blogs

Issue Date: 2025-11-26 [Paper Note] MTBBench: A Multimodal Sequential Clinical Decision-Making Benchmark in Oncology, Kiril Vasilev+, arXiv'25, 2025.11 GPT Summary- MTBBenchは、臨床ワークフローの複雑さを反映したマルチモーダル大規模言語モデル(LLMs)のための新しいベンチマークで、腫瘍学の意思決定をシミュレートします。既存の評価が単一モーダルであるのに対し、MTBBenchは異種データの統合や時間に基づく洞察の進化を考慮しています。臨床医によって検証されたグラウンドトゥルースの注釈を用い、複数のLLMを評価した結果、信頼性の欠如や幻覚の発生、データの調和に苦労することが明らかになりました。MTBBenchは、マルチモーダルおよび長期的な推論を強化するツールを提供し、タスクレベルのパフォーマンスを最大9.0%および11.2%向上させることが示されました。 Comment

dataset: https://huggingface.co/datasets/EeshaanJain/MTBBench

元ポスト:

> Ground truth annotations are validated by clinicians via a co-developed app, ensuring clinical relevance.

素晴らしい

#RecommenderSystems #Pocket #LanguageModel #ReinforcementLearning #VariationalAutoEncoder #PostTraining #read-later #One-Line Notes #Scalability

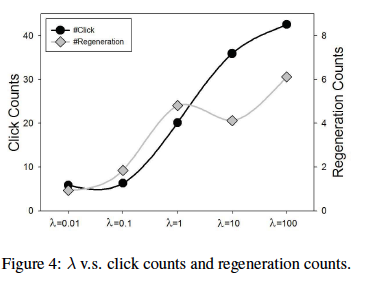

Issue Date: 2025-11-26 [Paper Note] MiniOneRec: An Open-Source Framework for Scaling Generative Recommendation, Xiaoyu Kong+, arXiv'25, 2025.10 GPT Summary- MiniOneRecを提案し、SID構築から強化学習までのエンドツーエンドの生成レコメンデーションフレームワークを提供。実験により、モデルサイズの増加に伴いトレーニング損失と評価損失が減少し、生成アプローチのパラメータ効率が確認された。さらに、SID整合性の強制と強化学習を用いたポストトレーニングパイプラインにより、ランキング精度と候補の多様性が大幅に向上。 Comment

github: https://github.com/AkaliKong/MiniOneRec

元ポスト:

興味深い話ではあるが、generativeなRecSysはlatencyの面で厳しいものがあるという認識ではある。読みたい。

#Pocket #NLP #Supervised-FineTuning (SFT) #ReinforcementLearning #SmallModel #OpenWeight #OpenSource #read-later #VisionLanguageModel #One-Line Notes

Issue Date: 2025-11-25 [Paper Note] OpenMMReasoner: Pushing the Frontiers for Multimodal Reasoning with an Open and General Recipe, Kaichen Zhang+, arXiv'25, 2025.11 GPT Summary- 本研究では、マルチモーダル推論のための透明な二段階トレーニングレシピ「OpenMMReasoner」を提案。監視付きファインチューニング(SFT)で874Kサンプルのデータセットを構築し、強化学習(RL)で74Kサンプルを活用して推論能力を向上。評価の結果、9つのベンチマークでQwen2.5-VL-7B-Instructに対し11.6%の性能向上を達成し、データの質とトレーニング設計の重要性を示した。すべてのリソースはオープンソースで公開。 Comment

pj page: https://evolvinglmms-lab.github.io/OpenMMReasoner/

SoTAなVLMを構築するためのオープンなデータとレシピらしい

元ポスト:

#Pocket #NLP #Dataset #LanguageModel #Evaluation #Reasoning #read-later #Physics Issue Date: 2025-11-23 [Paper Note] Probing the Critical Point (CritPt) of AI Reasoning: a Frontier Physics Research Benchmark, Minhui Zhu+, arXiv'25, 2025.09 GPT Summary- CritPtは、物理学研究における複雑な推論タスクを評価するための初のベンチマークであり、71の研究課題と190のチェックポイントタスクから構成される。これらの問題は現役の物理学者によって作成され、機械的に検証可能な答えを持つように設計されている。現在のLLMsは、単独のチェックポイントでは期待を示すが、全体の研究課題を解決するには不十分であり、最高精度は5.7%にとどまる。CritPtは、AIツールの開発に向けた基盤を提供し、モデルの能力と物理学研究の要求とのギャップを明らかにする。 Comment

pj page: https://critpt.com/

artificial analysisによるリーダーボード:

https://artificialanalysis.ai/evaluations/critpt

データセットとハーネス:

#Pocket #Robotics #Scalability #Sim-to-Real #Loco-Manipulation Issue Date: 2025-11-21 [Paper Note] VIRAL: Visual Sim-to-Real at Scale for Humanoid Loco-Manipulation, Tairan He+, arXiv'25, 2025.11 GPT Summary- VIRALというフレームワークを用いて、ヒューマノイドロボットのロコマニピュレーションをシミュレーションから実世界に展開。教師-生徒の強化学習を通じて、視覚ベースのポリシーを訓練し、計算規模が成功に重要であることを示す。シミュレーションと実世界の整合性を確保し、Unitree G1ヒューマノイドでの実験により、専門家レベルの性能に近づくことを確認。 Comment

pj page: https://viral-humanoid.github.io/

元ポスト:

関連:

- ACT-1: A Robot Foundation Model Trained on Zero Robot Data, Sunday Team, 2025.11

解説:

discussionの部分が興味深い

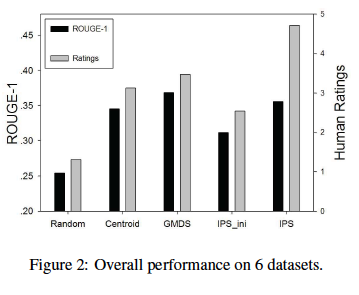

#Pretraining #Pocket #NLP #Dataset #LanguageModel #read-later Issue Date: 2025-11-21 [Paper Note] AICC: Parse HTML Finer, Make Models Better -- A 7.3T AI-Ready Corpus Built by a Model-Based HTML Parser, Ren Ma+, arXiv'25, 2025.11 GPT Summary- ウェブデータの品質向上のため、MinerU-HTMLという新しい抽出パイプラインを提案。これは、言語モデルを用いてコンテンツ抽出をシーケンスラベリング問題として再定義し、意味理解を活用した二段階のフォーマットパイプラインを採用。実験では、MinerU-HTMLが81.8%のROUGE-N F1を達成し、従来の手法よりも構造化要素の保持率が優れていることを示した。AICCという多言語コーパスを構築し、抽出品質がモデルの性能に大きく影響することを確認。MainWebBench、MinerU-HTML、AICCを公開し、HTML抽出の重要性を強調。 Comment

元ポスト:

#Multi #Pocket #NLP #LanguageModel #Test-Time Scaling #read-later #RewardModel #Reranking #One-Line Notes #GenerativeVerifier Issue Date: 2025-11-20 [Paper Note] Foundational Automatic Evaluators: Scaling Multi-Task Generative Evaluator Training for Reasoning-Centric Domains, Austin Xu+, arXiv'25, 2025.10 GPT Summary- 専門的な生成評価者のファインチューニングに関する研究で、250万サンプルのデータセットを用いて、シンプルな教師ありファインチューニング(SFT)アプローチでFARE(基盤自動推論評価者)をトレーニング。FARE-8Bは大規模なRLトレーニング評価者に挑戦し、FARE-20Bは新たなオープンソース評価者の標準を設定。FARE-20BはMATHでオラクルに近いパフォーマンスを達成し、下流RLトレーニングモデルの性能を最大14.1%向上。FARE-Codeはgpt-oss-20Bを65%上回る品質評価を実現。 Comment

HF: https://huggingface.co/collections/Salesforce/fare

元ポスト:

これは素晴らしい。使い道がたくさんありそうだし、RLに利用したときに特定のデータに対して特化したモデルよりも優れた性能を発揮するというのは驚き。

#EfficiencyImprovement #Pocket #NLP #LanguageModel #ReinforcementLearning #SoftwareEngineering #read-later #Off-Policy #On-Policy Issue Date: 2025-11-20 [Paper Note] Seer: Online Context Learning for Fast Synchronous LLM Reinforcement Learning, Ruoyu Qin+, arXiv'25, 2025.11 GPT Summary- 強化学習における性能ボトルネックを解消するために、新しいオンラインコンテキスト学習システム「Seer」を提案。Seerは、出力の類似性を活用し、分割ロールアウト、コンテキストに基づくスケジューリング、適応的グループ化推測デコーディングを導入。これにより、ロールアウトの待機時間を大幅に短縮し、リソース効率を向上。評価結果では、エンドツーエンドのロールアウトスループットを74%から97%向上させ、待機時間を75%から93%削減した。 Comment

元ポスト:

#EfficiencyImprovement #Pocket #NLP #LanguageModel #Transformer #Architecture #read-later #One-Line Notes Issue Date: 2025-11-17 [Paper Note] Virtual Width Networks, Seed+, arXiv'25, 2025.11 GPT Summary- Virtual Width Networks (VWN)は、隠れ層のサイズを増やすことなく、より広い表現を可能にするフレームワークである。VWNはバックボーンの計算をほぼ一定に保ちながら埋め込み空間を拡張し、8倍の拡張でトークン予測の最適化を加速することを示した。トレーニングが進むにつれてこの利点は増幅され、仮想幅と損失削減の間には対数線形のスケーリング関係があることが確認された。 Comment

元ポスト:

ポイント解説:

重要論文に見える。transformerのバックボーンの次元は変えないでベクトルのwidthを広げることと同等の効力を得るためのアーキテクチャを提案している模様。

ざっくり言うとembeddingをN倍(over-width)し、提案手法であるGHCを用いてバックボーンに流せるサイズにベクトルを圧縮しtransformerブロックで処理しover-widthした次元に戻す処理をする機構と、over-widthしたembeddingを次元数は変えずに変換するlinearを噛ませた結果を足し合わせるような機構を用意して最大のボトルネックであるtransformerブロックの計算量は変えずに表現力を向上させる、といった感じの手法な模様

#Pocket #NLP #LanguageModel #ReinforcementLearning #Hallucination #PostTraining #read-later #KeyPoint Notes Issue Date: 2025-11-15 [Paper Note] Train for Truth, Keep the Skills: Binary Retrieval-Augmented Reward Mitigates Hallucinations, Tong Chen+, arXiv'25, 2025.10 GPT Summary- 本研究では、外的幻覚を軽減するために新しいバイナリ検索強化報酬(RAR)を用いたオンライン強化学習手法を提案。モデルの出力が事実に基づいている場合のみ報酬を与えることで、オープンエンド生成において幻覚率を39.3%削減し、短文質問応答では不正解を44.4%減少させた。重要な点は、事実性の向上が他のパフォーマンスに悪影響を及ぼさないことを示した。 Comment

Utilityを維持しつつ、Hallucinationを減らせるかという話で、Binary Retrieval Augmented Reward (Binary RAR)と呼ばれるRewardを提案している。このRewardはverifierがtrajectoryとanswerを判断した時に矛盾がない場合にのみ1, それ以外は0となるbinary rewardである。これにより、元のモデルの正解率・有用性(極論全てをわかりません(棄権)と言えば安全)の両方を損なわずにHallucinationを提言できる。

また、通常のVerifiable Rewardでは、正解に1, 棄権・不正解に0を与えるRewardとみなせるため、モデルがguessingによってRewardを得ようとする(guessingすることを助長してしまう)。一方で、Binary RARは、正解・棄権に1, 不正解に0を与えるため、guessingではなく不確実性を表現することを学習できる(おそらく、棄権する場合はどのように不確実かを矛盾なく説明した上で棄権しないとRewardを得られないため)。

といった話が元ポストに書かれているように見える。

元ポスト:

#MachineLearning #Pocket #NLP #Dataset #TabularData #Evaluation #Live #One-Line Notes Issue Date: 2025-11-14 [Paper Note] TabArena: A Living Benchmark for Machine Learning on Tabular Data, Nick Erickson+, NeurIPS'25 Spotlight, 2025.06 GPT Summary- TabArenaは、表形式データのための初の生きたベンチマークシステムであり、継続的に更新されることを目的としています。手動でキュレーションされたデータセットとモデルを用いて、公開リーダーボードを初期化しました。結果は、モデルのベンチマークにおける検証方法やハイパーパラメータ設定の影響を示し、勾配ブースティング木が依然として強力である一方、深層学習手法もアンサンブルを用いることで追いついてきていることを観察しました。また、基盤モデルは小規模データセットで優れた性能を発揮し、モデル間のアンサンブルが表形式機械学習の進展に寄与することを示しました。TabArenaは、再現可能なコードとメンテナンスプロトコルを提供し、https://tabarena.ai で利用可能です。 Comment

pj page:

https://github.com/autogluon/tabarena

leaderboard:

https://huggingface.co/spaces/TabArena/leaderboard

liveデータに基づくベンチマークで、手動で収集された51のtabularデータセットが活用されているとのこと。またあるモデルに対して数百にも登るハイパーパラメータ設定での実験をしアンサンブルをすることで単一モデルが到達しうるピーク性能を見ることに主眼を置いている、またいな感じらしい。そしてやはり勾配ブースティング木が強い。tunedは単体モデルの最も性能が良い設定での性能で、ensembleは複数の設定での同一モデルのアンサンブルによる結果だと思われる。

> TabArena currently consists of:

> 51 manually curated tabular datasets representing real-world tabular data tasks.

> 9 to 30 evaluated splits per dataset.

> 16 tabular machine learning methods, including 3 tabular foundation models.

> 25,000,000 trained models across the benchmark, with all validation and test predictions cached to enable tuning and post-hoc ensembling analysis.

> A live TabArena leaderboard showcasing the results.

openreview: https://openreview.net/forum?id=jZqCqpCLdU

#EfficiencyImprovement #Pocket #NLP #LanguageModel #DiffusionModel #Decoding #read-later Issue Date: 2025-11-13 [Paper Note] TiDAR: Think in Diffusion, Talk in Autoregression, Jingyu Liu+, arXiv'25, 2025.11 GPT Summary- TiDARは、拡散言語モデルと自己回帰モデルの利点を融合したハイブリッドアーキテクチャで、トークンのドラフトとサンプリングを単一のフォワードパスで実行します。これにより、高スループットとARモデルに匹敵する品質を両立させ、推測的デコーディングを上回る効率を実現しました。TiDARは、1秒あたり4.71倍から5.91倍のトークン生成を可能にし、ARモデルとの品質ギャップを初めて埋めました。 Comment

元ポスト:

解説:

#Pocket #NLP #LanguageModel #OpenWeight #Safety #read-later Issue Date: 2025-11-13 Open Technical Problems in Open-Weight AI Model Risk Management, Casper+, SSRN'25, 2025.11 GPT Summary- オープンウェイトのフロンティアAIモデルは強力で広く採用されているが、リスク管理には新たな課題がある。これらのモデルはオープンな研究を促進する一方で、恣意的な変更や監視なしの使用がリスクを増大させる。安全性ツールに関する研究は限られており、16の技術的課題を提示。オープンな研究と評価がリスク管理の科学を構築する鍵であることを強調。 Comment

元ポスト:

#ComputerVision #Analysis #Pretraining #Pocket #NLP #Dataset #LanguageModel #DataMixture #PhaseTransition Issue Date: 2025-11-12 [Paper Note] Why Less is More (Sometimes): A Theory of Data Curation, Elvis Dohmatob+, arXiv'25, 2025.11 GPT Summary- 本論文では、データを少なく使う方が良い場合についての理論的枠組みを提案し、小規模な厳選データセットが優れた性能を発揮する理由を探ります。データキュレーション戦略を通じて、ラベルに依存しない・依存するルールのテスト誤差のスケーリング法則を明らかにし、特定の条件下で小規模データが大規模データを上回る可能性を示します。ImageNetでの実証結果を通じて、キュレーションが精度を向上させることを確認し、LLMの数学的推論における矛盾する戦略への理論的説明も提供します。 Comment

元ポスト:

#ComputerVision #Pocket #Transformer #DiffusionModel #2D (Image) #WorldModels Issue Date: 2025-11-11 [Paper Note] ChronoEdit: Towards Temporal Reasoning for Image Editing and World Simulation, Jay Zhangjie Wu+, arXiv'25, 2025.10 GPT Summary- ChronoEditフレームワークを提案し、画像編集を動画生成として再定義。入力画像と編集画像を動画の最初と最後のフレームとし、時間的一貫性を学習した動画生成モデルを活用。推論時に時間的推論ステージを導入し、物理的に実現可能な変換を制約する編集軌道を生成。新しいベンチマークPBench-Editで、ChronoEditが視覚的忠実性と物理的妥当性で最先端の手法を上回ることを示した。 Comment

HF:

https://huggingface.co/nvidia/ChronoEdit-14B-Diffusers

LoRAによるUpscaler:

https://huggingface.co/nvidia/ChronoEdit-14B-Diffusers-Upscaler-Lora

元ポスト:

スケッチ+promptでの編集

HF:

https://huggingface.co/nvidia/ChronoEdit-14B-Diffusers-Paint-Brush-Lora

元ポスト:

#ComputerVision #Pocket #NLP #Dataset #LanguageModel #Evaluation #MultiModal #read-later #Robotics #EmbodiedAI Issue Date: 2025-11-10 [Paper Note] PhysToolBench: Benchmarking Physical Tool Understanding for MLLMs, Zixin Zhang+, arXiv'25, 2025.10 GPT Summary- MLLMsの物理的道具に対する理解を評価するための新しいベンチマークPhysToolBenchを提案。1,000以上の画像-テキストペアからなるVQAデータセットで、道具認識、道具理解、道具創造の3つの能力を評価。32のMLLMsに対する評価で道具理解に欠陥があることが明らかになり、初歩的な解決策を提案。コードとデータセットは公開。 Comment

元ポスト:

興味深い

#Analysis #EfficiencyImprovement #Pocket #NLP #LanguageModel #LLM-as-a-Judge #EMNLP #read-later #Stability Issue Date: 2025-11-10 [Paper Note] Analyzing Uncertainty of LLM-as-a-Judge: Interval Evaluations with Conformal Prediction, Huanxin Sheng+, EMNLP'25 SAC Highlights, 2025.09 GPT Summary- LLMを用いた自然言語生成の評価における不確実性を分析するためのフレームワークを提案。適合予測を通じて予測区間を構築し、中央値に基づくスコアを低バイアスの代替手段として提示。実験により、適合予測が有効な予測区間を提供できることを示し、判断の向上に向けた中央値や再プロンプトの有用性も探求。 Comment

元ポスト:

実用上非常に重要な話に見える

#EfficiencyImprovement #Pocket #NLP #Search #Dataset #LanguageModel #Evaluation #EMNLP #read-later #Contamination-free Issue Date: 2025-11-09 [Paper Note] Infini-gram mini: Exact n-gram Search at the Internet Scale with FM-Index, Hao Xu+, EMNLP'25 Best Paper, 2025.06 GPT Summary- 「infini-gram mini」は、ペタバイトレベルのテキストコーパスを効率的に検索可能にするシステムで、FM-indexデータ構造を用いてインデックスを作成し、ストレージオーバーヘッドを44%に削減。インデックス作成速度やメモリ使用量を大幅に改善し、83TBのインターネットテキストを99日でインデックス化。大規模なベンチマーク汚染の分析を行い、主要なLM評価ベンチマークがインターネットクローリングで汚染されていることを発見。汚染率を共有する公報をホストし、検索クエリ用のウェブインターフェースとAPIも提供。 Comment

元ポスト:

pj page: https://infini-gram-mini.io

benchmarmk contamination monitoring system: https://huggingface.co/spaces/infini-gram-mini/Benchmark-Contamination-Monitoring-System

#EfficiencyImprovement #Pocket #NLP #LanguageModel #ReinforcementLearning Issue Date: 2025-11-07 [Paper Note] PipelineRL: Faster On-policy Reinforcement Learning for Long Sequence Generation, Alexandre Piché+, arXiv'25, 2025.09 GPT Summary- 強化学習(RL)を用いて大規模言語モデル(LLMs)の推論能力を向上させるための新しいアプローチ、PipelineRLを提案。PipelineRLは非同期データ生成とモデル更新を同時に行い、トレーニングデータの新鮮さを保ちながら、GPUの利用率を最大化。実験では、従来のRL手法に比べて約2倍の学習速度を達成。PipelineRLのオープンソース実装も公開。 Comment

元ポスト:

#Pocket #NLP #LanguageModel #UserBased #AIAgents #SoftwareEngineering #read-later #interactive Issue Date: 2025-11-06 [Paper Note] Training Proactive and Personalized LLM Agents, Weiwei Sun+, arXiv'25, 2025.11 GPT Summary- 効果的なAIエージェントには、生産性、積極性、パーソナライズの3つの次元を最適化する必要があると主張。LLMベースのユーザーシミュレーター「UserVille」を導入し、PPPというマルチオブジェクティブ強化学習アプローチを提案。実験では、PPPで訓練されたエージェントがGPT-5に対して平均21.6ポイントの改善を達成し、ユーザーの好みに適応しながらタスク成功を向上させる能力を示した。 Comment

AI Agentにおいてユーザとのinteractionを重視し協働することを重視するようなRLをする模様。興味深い。

元ポスト:

#NeuralNetwork #Pocket #NLP #LongSequence #Architecture #NeurIPS #memory #Test-time Learning Issue Date: 2025-11-05 [Paper Note] Titans: Learning to Memorize at Test Time, Ali Behrouz+, NeurIPS'25, 2024.12 GPT Summary- 再帰モデルと注意機構を組み合わせた新しいニューラル長期メモリモジュールを提案。これにより、短期的な依存関係を正確にモデル化しつつ、長期的な記憶を保持。新アーキテクチャ「Titans」は、言語モデリングや常識推論などのタスクで従来のモデルよりも優れた性能を示し、2Mを超えるコンテキストウィンドウサイズにも対応可能。 Comment

元ポスト:

#Pocket #NLP #ReinforcementLearning #AIAgents #Coding #NeurIPS #SoftwareEngineering Issue Date: 2025-11-05 [Paper Note] SWE-RL: Advancing LLM Reasoning via Reinforcement Learning on Open Software Evolution, Yuxiang Wei+, NeurIPS'25, 2025.02 GPT Summary- SWE-RLは、強化学習を用いて大規模言語モデル(LLMs)の推論能力を向上させる新しいアプローチで、実世界のソフトウェア工学に焦点を当てています。軽量なルールベースの報酬を活用し、LLMがオープンソースソフトウェアの進化データから学習することで、開発者の推論プロセスを自律的に回復します。Llama3-SWE-RL-70Bは、実世界のGitHub問題において41.0%の解決率を達成し、中規模LLMとしては最高のパフォーマンスを示しました。また、一般化された推論スキルを持ち、複数のドメイン外タスクで改善された結果を示しています。SWE-RLは、ソフトウェア工学データに基づく強化学習の新たな可能性を開きます。 Comment

元ポスト:

ポイント解説:

解説:

#NeuralNetwork #ComputerVision #Pocket #Attention #NeurIPS #ObjectDetection Issue Date: 2025-11-05 [Paper Note] YOLOv12: Attention-Centric Real-Time Object Detectors, Yunjie Tian+, NeurIPS'25, 2025.02 GPT Summary- YOLOv12は、注意メカニズムを活用した新しいYOLOフレームワークで、CNNベースのモデルと同等の速度を維持しつつ、精度を向上させる。特に、YOLOv12-NはT4 GPU上で1.64 msの推論遅延で40.6%のmAPを達成し、YOLOv10-NおよびYOLOv11-Nを上回る性能を示す。また、YOLOv12はRT-DETRやRT-DETRv2よりも優れた性能を発揮し、計算量とパラメータ数を大幅に削減しながらも高速な実行を実現している。 Comment

元ポスト:

#Pocket #NLP #Dataset #Evaluation #MultiModal #Reasoning #VisionLanguageModel #2D (Image) #KeyPoint Notes #text #Visual-CoT Issue Date: 2025-11-05 [Paper Note] When Visualizing is the First Step to Reasoning: MIRA, a Benchmark for Visual Chain-of-Thought, Yiyang Zhou+, arXiv'25, 2025.11 GPT Summary- MIRAは、中間的な視覚画像を生成し推論を支援する新しいベンチマークで、従来のテキスト依存の手法とは異なり、スケッチや構造図を用いる。546のマルチモーダル問題を含み、評価プロトコルは画像と質問、テキストのみのCoT、視覚的ヒントを含むVisual-CoTの3レベルを網羅。実験結果は、中間的な視覚的手がかりがモデルのパフォーマンスを33.7%向上させることを示し、視覚情報の重要性を強調している。 Comment

pj page: https://mira-benchmark.github.io/

元ポスト:

Visual CoT

Frontierモデル群でもAcc.が20%未満のマルチモーダル(Vision QA)ベンチマーク。

手作業で作成されており、Visual CoT用のsingle/multi stepのintermediate imagesも作成されている。興味深い。

VLMにおいて、{few, many}-shotがうまくいく場合(Geminiのようなプロプライエタリモデルはshot数に応じて性能向上、一方LlamaのようなOpenWeightモデルは恩恵がない)と

- [Paper Note] Many-Shot In-Context Learning in Multimodal Foundation Models, Yixing Jiang+, arXiv'24, 2024.05

うまくいかないケース(事前訓練で通常見られない分布外のドメイン画像ではICLがうまくいかない)

- [Paper Note] Roboflow100-VL: A Multi-Domain Object Detection Benchmark for Vision-Language Models, Peter Robicheaux+, NeurIPS'25, 2025.05

も報告されている。

おそらく事前学習段階で当該ドメインの画像が学習データにどれだけ含まれているか、および、画像とテキストのalignmentがとれていて、画像-テキスト間の知識を活用できる状態になっていることが必要なのでは、という気はする。

著者ポスト:

#Pocket #LanguageModel #DiffusionModel #ICLR #read-later Issue Date: 2025-11-04 [Paper Note] Block Diffusion: Interpolating Between Autoregressive and Diffusion Language Models, Marianne Arriola+, ICLR'25, 2025.03 GPT Summary- ブロック拡散言語モデルは、拡散モデルと自己回帰モデルの利点を組み合わせ、柔軟な長さの生成を可能にし、推論効率を向上させる。効率的なトレーニングアルゴリズムやデータ駆動型ノイズスケジュールを提案し、言語モデリングベンチマークで新たな最先端のパフォーマンスを達成。 Comment

openreview: https://openreview.net/forum?id=tyEyYT267x

#Analysis #Pocket #NLP #LanguageModel #DiffusionModel #Architecture #read-later Issue Date: 2025-11-04 [Paper Note] On Powerful Ways to Generate: Autoregression, Diffusion, and Beyond, Chenxiao Yang+, arXiv'25, 2025.10 GPT Summary- 自己回帰的な次トークン予測とマスクされた拡散を超えた生成プロセスを研究し、その利点と限界を定量化。書き換えや長さ可変の編集が可能になることで、理論的および実証的な利点を示し、自然言語以外の領域でも機能する大規模言語モデル(LLM)の重要性を強調。 Comment

元ポスト:

#Pocket #NLP #Dataset #LanguageModel #Evaluation #EMNLP #ConceptErasure #read-later Issue Date: 2025-11-04 [Paper Note] Intrinsic Test of Unlearning Using Parametric Knowledge Traces, Yihuai Hong+, EMNLP'25, 2024.06 GPT Summary- 大規模言語モデルにおける「忘却」タスクの重要性が高まっているが、現在の評価手法は行動テストに依存しており、モデル内の残存知識を監視していない。本研究では、忘却評価においてパラメトリックな知識の変化を考慮する必要性を主張し、語彙投影を用いた評価方法論を提案。これにより、ConceptVectorsというベンチマークデータセットを作成し、既存の忘却手法が概念ベクトルに与える影響を評価した。結果、知識を直接消去することでモデルの感受性が低下することが示され、今後の研究においてパラメータに基づく評価の必要性が強調された。 Comment

元ポスト:

#EfficiencyImprovement #Pocket #NLP #LanguageModel #ReinforcementLearning #PostTraining #Stability #Reference Collection #train-inference-gap Issue Date: 2025-11-01 [Paper Note] Defeating the Training-Inference Mismatch via FP16, Penghui Qi+, arXiv'25, 2025.10 GPT Summary- 強化学習による大規模言語モデルのファインチューニングにおける不安定性は、トレーニングポリシーと推論ポリシーの数値的不一致に起因する。従来の対策は効果が薄かったが、本研究ではFP16に戻すことでこの問題を解決できることを示した。この変更は簡単で、モデルやアルゴリズムの修正を必要とせず、安定した最適化と速い収束を実現し、多様なタスクで強力なパフォーマンスを発揮することが確認された。 Comment

元ポスト:

RL学習時の浮動小数点数表現をbf16からfp16に変更するシンプルな変更で、訓練-推論時のgapが小さくなり学習が改善する、という話らしい。

ポイント解説:

所見:

解説:

解説:

verlはFP16での学習をサポートしていないので著者がパッチを出した模様:

#Analysis #Pocket #NLP #LanguageModel #CrossLingual #TransferLearning #MultiLingual #Scaling Laws #read-later #One-Line Notes Issue Date: 2025-10-31 [Paper Note] ATLAS: Adaptive Transfer Scaling Laws for Multilingual Pretraining, Finetuning, and Decoding the Curse of Multilinguality, Shayne Longpre+, arXiv'25, 2025.10 GPT Summary- 本研究では、774の多言語トレーニング実験を通じて、最大の多言語スケーリング法則を探求し、ATLASという適応的転送スケーリング法則を導入。これにより、既存のスケーリング法則を上回る性能を示し、多言語学習のダイナミクスや言語間の転送特性を分析。言語ペア間の相互利益スコアを測定し、モデルサイズとデータの最適なスケーリング方法を明らかにし、事前学習とファインチューニングの計算的クロスオーバーポイントを特定。これにより、英語中心のAIを超えたモデルの効率的なスケーリングの基盤を提供することを目指す。 Comment

元ポスト:

バイリンガルで学習した時に、日本語とシナジーのある言語、この図を見ると無さそうに見える😅

#Pocket #NLP #Dataset #LanguageModel #Supervised-FineTuning (SFT) #AIAgents #One-Line Notes Issue Date: 2025-10-30 [Paper Note] Agent Data Protocol: Unifying Datasets for Diverse, Effective Fine-tuning of LLM Agents, Yueqi Song+, arXiv'25, 2025.10 GPT Summary- 本研究では、エージェントデータの収集における課題を解決するために、エージェントデータプロトコル(ADP)を提案。ADPは多様なデータ形式を統一し、簡単に解析・トレーニング可能な表現言語である。実験により、13のエージェントトレーニングデータセットをADP形式に統一し、標準化されたデータでSFTを実施した結果、平均約20%の性能向上を達成。ADPは再現可能なエージェントトレーニングの障壁を下げることが期待される。 Comment

pj page: https://www.agentdataprotocol.com

元ポスト:

著者ポスト:

解説:

エージェントを学習するための統一的なデータ表現に関するプロトコルを提案

#Pretraining #Pocket #NLP #LanguageModel #Transformer #LatentReasoning #KeyPoint Notes #RecurrentModels #RecursiveModels Issue Date: 2025-10-30 [Paper Note] Scaling Latent Reasoning via Looped Language Models, Rui-Jie Zhu+, arXiv'25, 2025.10 GPT Summary- Ouroは、推論を事前訓練フェーズに組み込むことを目指したループ言語モデル(LoopLM)であり、反復計算やエントロピー正則化を通じて性能を向上させる。1.4Bおよび2.6Bモデルは、最大12Bの最先端LLMに匹敵する性能を示し、知識操作能力の向上がその要因であることを実験で確認。LoopLMは明示的なCoTよりも整合した推論を生成し、推論の新たなスケーリングの可能性を示唆している。モデルはオープンソースで提供されている。 Comment

pj page: https://ouro-llm.github.io

元ポスト:

解説:

基本構造はdecoder-only transformerで

- Multi-Head Attention

- RoPE

- SwiGLU活性化

- Sandwich Normalization

が使われているLoopedTransformerで、exit gateを学習することで早期にloopを打ち切り、出力をすることでコストを節約できるようなアーキテクチャになっている。

より少ないパラメータ数で、より大きなパラメータ数のモデルよりも高い性能を示す(Table7,8)。また、Tを増やすとモデルの安全性も増す(=有害プロンプトの識別力が増す)。その代わり、再帰数Tを大きくするとFLOPsがT倍になるので、メモリ効率は良いが計算効率は悪い。

linear probingで再帰の次ステップ予測をしたところ浅い段階では予測が不一致になるため、思考が進化していっているのではないか、という考察がある。

また、再帰数Tを4で学習した場合に、inference時にTを5--8にしてもスケールしない(Table10)。

またAppendix D.1において、通常のtransformerのLoopLMを比較し、5種類の大きさのモデルサイズで比較。通常のtransformerではループさせる代わりに実際に層の数を増やすことで、パラメータ数を揃えて実験したところ、通常のtransformerの方が常に性能が良く、loopLMは再帰数を増やしてもスケールせず、モデルサイズが大きくなるにつれて差がなくなっていく、というスケーリングの面では残念な結果に終わっているようだ。

といった話が解説に書かれている。元論文は完全にskim readingして解説ポストを主に読んだので誤りが含まれるかもしれない点には注意。

#Embeddings #Analysis #Pocket #NLP #LanguageModel Issue Date: 2025-10-29 [Paper Note] Language Models are Injective and Hence Invertible, Giorgos Nikolaou+, arXiv'25, 2025.10 GPT Summary- 本研究では、トランスフォーマー言語モデルが単射であることを数学的に証明し、異なる入力が同じ出力にマッピングされないことを示す。さらに、6つの最先端モデルに対して衝突テストを行い、衝突がないことを確認。新たに提案するアルゴリズムSipItにより、隠れた活性化から正確な入力テキストを効率的に再構築できることを示し、単射性が言語モデルの重要な特性であることを明らかにする。 Comment

元ポスト:

続報:

解説:

解説参照のこと。

#Pretraining #NLP #Dataset #LanguageModel #One-Line Notes #German Issue Date: 2025-10-28 [Paper Note] The German Commons - 154 Billion Tokens of Openly Licensed Text for German Language Models, Lukas Gienapp+, arXiv'25, 2025.10 GPT Summary- 「German Commons」は、オープンライセンスのドイツ語テキストの最大コレクションで、41のソースから1545.6億トークンを提供。法律、科学、文化など7つのドメインを含み、品質フィルタリングや重複排除を行い、一貫した品質を確保。すべてのデータは法的遵守を保証し、真にオープンなドイツ語モデルの開発を支援。再現可能で拡張可能なコーパス構築のためのコードも公開。 Comment

HF: https://huggingface.co/datasets/coral-nlp/german-commons

元ポスト:

最大級(154B)のドイツ語のLLM(事前)学習用データセットらしい

ODC-By Licence

#ComputerVision #Pocket #Dataset #Zero/Few/ManyShotPrompting #Evaluation #MultiModal #In-ContextLearning #NeurIPS #read-later #OOD #Generalization #VisionLanguageModel #One-Line Notes #ObjectDetection Issue Date: 2025-10-27 [Paper Note] Roboflow100-VL: A Multi-Domain Object Detection Benchmark for Vision-Language Models, Peter Robicheaux+, NeurIPS'25, 2025.05 GPT Summary- 視覚と言語のモデル(VLMs)は、一般的な物体に対して優れたゼロショット検出性能を示すが、分布外のクラスやタスクに対しては一般化が難しい。そこで、少数の視覚例と豊富なテキスト記述を用いてVLMを新しい概念に整合させる必要があると提案。Roboflow100-VLという多様な概念を持つ100のマルチモーダル物体検出データセットを導入し、最先端モデルの評価を行った。特に、難しい医療画像データセットでのゼロショット精度が低く、少数ショットの概念整合が求められることを示した。 Comment

元ポスト:

VLMが「現実世界をどれだけ理解できるか」を評価するためのobject detection用ベンチマークを構築。100のopen source datasetから構成され、それぞれにはtextでのfew shot instructionやvisual exampleが含まれている。データセットは合計で約165kの画像、約1.35M件のアノテーションが含まれ、航空、生物、産業などの事前学習ではあまりカバーされていない新規ドメインの画像が多数含まれているとのこと。

そして現在のモデルは事前学習に含まれていないOODな画像に対する汎化性能が低く、いちいちモデルを追加で学習するのではなく、ICLによって適用できた方が好ましいという考えがあり、そして結果的に現在のVLMでは、ICLがあまりうまくいかない(ICLによるOODの汎化が効果的にできない)ことがわかった、という話らしい。

が、

- [Paper Note] Many-Shot In-Context Learning in Multimodal Foundation Models, Yixing Jiang+, arXiv'24, 2024.05

での知見と異なる。差異はなんだろうか?

以下のスレッドで議論がされている:

pj page: https://rf100-vl.org

うーんあとでしっかり読みたい、、、

#Pocket #NLP #Dataset #LanguageModel #Evaluation #Reasoning #read-later #One-Line Notes #LongHorizon Issue Date: 2025-10-27 [Paper Note] R-Horizon: How Far Can Your Large Reasoning Model Really Go in Breadth and Depth?, Yi Lu+, arXiv'25, 2025.10 GPT Summary- R-HORIZONを提案し、長期的な推論行動を刺激する手法を通じて、LRMの評価を改善。複雑なマルチステップ推論タスクを含むベンチマークを構築し、LRMの性能低下を明らかに。R-HORIZONを用いた強化学習データ(RLVR)は、マルチホライズン推論タスクの性能を大幅に向上させ、標準的な推論タスクの精度も向上。AIME2024で7.5の増加を達成。R-HORIZONはLRMの長期推論能力を向上させるための有効なパラダイムと位置付けられる。 Comment

pj page: https://reasoning-horizon.github.io

元ポスト:

long horizonタスクにうまく汎化する枠組みの必要性が明らかになったように見える。long horizonデータを合成して、post trainingをするという枠組みは短期的には強力でもすぐに計算リソースの観点からすぐに現実的には能力を伸ばせなくなるのでは。

ポイント解説:

#Pocket #NLP #Dataset #LanguageModel #AIAgents #Evaluation #MultiModal #Reasoning #SoftwareEngineering #ComputerUse #read-later #VisionLanguageModel #Science Issue Date: 2025-10-26 [Paper Note] ScienceBoard: Evaluating Multimodal Autonomous Agents in Realistic Scientific Workflows, Qiushi Sun+, arXiv'25, 2025.05 GPT Summary- 大規模言語モデル(LLMs)を活用したScienceBoardを紹介。これは、科学的ワークフローを加速するための動的なマルチドメイン環境と、169の厳密に検証されたタスクからなるベンチマークを提供。徹底的な評価により、エージェントは複雑なワークフローでの信頼性が低く、成功率は15%にとどまることが明らかに。これにより、エージェントの限界を克服し、より効果的な設計原則を模索するための洞察が得られる。 Comment

元ポスト:

#Pocket #NLP #LanguageModel #NeurIPS Issue Date: 2025-10-25 [Paper Note] Blackbox Model Provenance via Palimpsestic Membership Inference, Rohith Kuditipudi+, NeurIPS'25 Spotlight, 2025.10 GPT Summary- アリスの言語モデルを用いてボブがテキストを生成する際、アリスはボブが彼女のモデルを使用していることを証明できるかを検討。クエリ設定と観察設定の2つのアプローチで、ボブのモデルやテキストとアリスの訓練データの順序との相関を調査。40以上のファインチューニングで、p値が1e-8に達する結果を得た。観察設定では、ボブのテキストの尤度を推定する2つの方法を試し、数百トークンでの区別が可能なアプローチと、数十万トークンを必要とする高パワーのアプローチを比較した。 Comment

元ポスト:

これはすごい話だ…

#Pocket #LanguageModel #Transformer #Architecture #ICLR #read-later #memory #KeyPoint Notes Issue Date: 2025-10-23 [Paper Note] Memory Layers at Scale, Vincent-Pierre Berges+, ICLR'25, 2024.12 GPT Summary- メモリ層は、計算負荷を増やさずにモデルに追加のパラメータを加えるための学習可能な検索メカニズムを使用し、スパースに活性化されたメモリ層が密なフィードフォワード層を補完します。本研究では、改良されたメモリ層を用いた言語モデルが、計算予算が2倍の密なモデルや同等の計算とパラメータを持つエキスパート混合モデルを上回ることを示し、特に事実に基づくタスクでの性能向上が顕著であることを明らかにしました。完全に並列化可能なメモリ層の実装とスケーリング法則を示し、1兆トークンまでの事前学習を行った結果、最大8Bのパラメータを持つベースモデルと比較しました。 Comment

openreview: https://openreview.net/forum?id=ATqGm1WyDj

transformerにおけるFFNをメモリレイヤーに置き換えることで、パラメータ数を増やしながら計算コストを抑えるようなアーキテクチャを提案しているようである。メモリレイヤーは、クエリqを得た時にtop kのkvをlookupし(=ここで計算対象となるパラメータがスパースになる)、kqから求めたattention scoreでvを加重平均することで出力を得る。Memory+というさらなる改良を加えたアーキテクチャでは、入力に対してsiluによるgatingとlinearな変換を追加で実施することで出力を得る。

denseなモデルと比較して性能が高く、メモリパラメータを増やすと性能がスケールする。

#Pocket #NLP #LanguageModel #Reasoning #Architecture #read-later #KeyPoint Notes #SpeciarizedBrainNetworks #Neuroscience Issue Date: 2025-10-22 [Paper Note] Mixture of Cognitive Reasoners: Modular Reasoning with Brain-Like Specialization, Badr AlKhamissi+, arXiv'25, 2025.06 GPT Summary- MiCRoは、脳の認知ネットワークに基づく専門家モジュールを持つトランスフォーマーベースのアーキテクチャで、言語モデルの層を4つの専門家に分割。これにより、解釈可能で因果的な専門家の動的制御が可能になり、機械学習ベンチマークで優れた性能を発揮。人間らしく解釈可能なモデルを実現。 Comment

pj page: https://cognitive-reasoners.epfl.ch

元ポスト:

事前学習言語モデルに対してpost-trainingによって、脳に着想を得て以下の4つをdistinctな認知モジュールを(どのモジュールにルーティングするかを決定するRouter付きで)学習する。

- Language

- Logic / Multiple Demand

- Social / Theory of Mind

- World / Default Mode Network

これによりAIとNeuroscienceがbridgeされ、MLサイドではモデルの解釈性が向上し、Cognitive側では、複雑な挙動が起きた時にどのモジュールが寄与しているかをprobingするテストベッドとなる。

ベースラインのdenseモデルと比較して、解釈性を高めながら性能が向上し、人間の行動とよりalignしていることが示された。また、layerを分析すると浅い層では言語のエキスパートにルーティングされる傾向が強く、深い層ではdomainのエキスパートにルーティングされる傾向が強くなるような人間の脳と似たような傾向が観察された。

また、neuroscienceのfunctional localizer(脳のどの部位が特定の機能を果たしているのかを特定するような取り組み)に着想を得て、類似したlocalizerが本モデルにも適用でき、特定の機能に対してどのexpertモジュールがどれだけ活性化しているかを可視化できた。

といったような話が著者ポストに記述されている。興味深い。

demo:

https://huggingface.co/spaces/bkhmsi/cognitive-reasoners

HF:

https://huggingface.co/collections/bkhmsi/mixture-of-cognitive-reasoners

#ComputerVision #Controllable #Pocket #Transformer #DiffusionModel #VariationalAutoEncoder #ICCV #KeyPoint Notes Issue Date: 2025-10-22 [Paper Note] OminiControl: Minimal and Universal Control for Diffusion Transformer, Zhenxiong Tan+, ICCV'25 Highlight, 2024.11 GPT Summary- OminiControlは、Diffusion Transformer(DiT)アーキテクチャにおける画像条件付けの新しいアプローチで、パラメータオーバーヘッドを最小限に抑えつつ、柔軟なトークン相互作用と動的な位置エンコーディングを実現。広範な実験により、複数の条件付けタスクで専門的手法を上回る性能を示し、合成された画像ペアのデータセット「Subjects200K」を導入。効率的で多様な画像生成システムの可能性を示唆。 Comment

元ポスト:

DiTのアーキテクチャは(MMA以外は)変更せずに、Condition Image C_IをVAEでエンコードしたnoisy inputをDiTのinputにconcatし順伝播させることで、DiTをunified conditioningモデル(=C_Iの特徴量を他のinputと同じlatent spaceで学習させ統合的に扱う)として学習する[^1]。

[^1]: 既存研究は別のエンコーダからエンコードしたfeatureが加算されていて(式3)、エンコーダ部分に別途パラメータが必要だっただけでなく、加算は空間的な対応関係が存在しない場合はうまく対処できず(featureの次元が空間的な情報に対応しているため)、conditional tokenとimageの交互作用を妨げていた。

また、positional encodingのindexをconditional tokenとnoisy image tokensと共有すると、空間的な対応関係が存在するタスク(edge guided generation等)はうまくいったが、被写体を指定する生成(subject driven generation)のような対応関係が存在しないタスク(non-aligned task)の場合はうまくいかなかった。しかし、non-aligned taskの場合は、indexにオフセットを加えシフトさせる(式4)ことで、conditional text/image token間で空間的にoverlapしないようにすることで性能が大幅に改善した。

既存研究では、C_Iの強さをコントロールするために、ハイパーパラメータとして定数を導入し、エンコードされたfeatureを加算する際の強さを調整していたが(3.2.3節)、本手法ではconcatをするためこのような方法は使えない。そのため、Multi-Modal Attention(MMA)にハイパーパラメータによって強さを調整可能なbias matrixを導入し、C_IとXのattentionの交互作用の強さを調整することで対応した(式5,6)。

#ComputerVision #EfficiencyImprovement #Pocket #NLP #ContextWindow #LongSequence #VisionLanguageModel #One-Line Notes Issue Date: 2025-10-21 [Paper Note] Glyph: Scaling Context Windows via Visual-Text Compression, Jiale Cheng+, arXiv'25, 2025.10 GPT Summary- 本研究では、長いコンテキストを持つ大規模言語モデル(LLMs)の実用性を向上させるため、Glyphというフレームワークを提案し、テキストを画像に変換して視覚と言語のモデル(VLMs)で処理します。このアプローチにより、3-4倍のトークン圧縮を実現し、精度を維持しつつ処理速度を約4倍向上させます。さらに、128KコンテキストのVLMが1Mトークンのテキストタスクを処理可能になることを示しました。 Comment

元ポスト:

所見:

テキストを画像にレンダリングしてVLMに入力することでtextと比較して3.2倍KV Cache (context)を圧縮し、prefillingとデコード速度も4.8, 4.4倍高速化するフレームワークらしい

#Pocket #NLP #Dataset #LanguageModel #AIAgents #Evaluation #read-later Issue Date: 2025-10-21 [Paper Note] Holistic Agent Leaderboard: The Missing Infrastructure for AI Agent Evaluation, Sayash Kapoor+, arXiv'25, 2025.10 GPT Summary- AIエージェントの評価における課題を解決するため、Holistic Agent Leaderboard(HAL)を導入。標準化された評価ハーネスにより評価時間を短縮し、三次元分析を通じて21,730のエージェントを評価。高い推論努力が精度を低下させることを発見し、LLMを用いたログ検査で新たな行動を明らかに。エージェント評価の標準化を進め、現実世界での信頼性向上を目指す。 Comment

pj page: https://hal.cs.princeton.edu

元ポスト:

よ、40,000ドル!?💸

LLM Agentに関するフロンティアモデル群を複数のベンチマークで同じ条件でapple to appleな比較となるように評価している。

以下元ポストより:

この評価ハーネスは、10行未満のコードスニペットで評価を実行可能(元ポスト)

知見としては

- reasoning effortを上げても多くの場合性能向上には寄与せず(21/36のケースで性能向上せず)

- エージェントはタスクを解決するために近道をする(ベンチマークを直接参照しに行くなど)

- エージェントは非常にコストの高い手段を取ることもあり(フライト予約において誤った空港から予約したり、ユーザに過剰な返金をしたり、誤ったクレジットカードに請求したりなど)

- コストとacc.のトレードオフを分析した結果、最も高価なOpus4.1は一度しかパレートフロンティアにならず、Gemini Flash (7/9)、GPT-5, o4-mini(4/9)が多くのベンチマークでコストとAcc.のトレードオフの上でパレートフロンティアとなった。

- トークンのコストとAcc.のトレードオフにおいては、Opus4.1が3つのベンチマークでパレードフロンティアとなった。

- すべてのエージェントの行動を記録し分析した結果、SelfCorrection, intermediate verifiers (コーディング問題におけるユニットテストなど)のbehaviorがacc.を改善する上で高い相関を示した

- 一方タスクに失敗する場合は、多くの要因が存在することがわかり、たとえば環境内の障害(CAPTCHAなど)、指示に従うことの失敗(指定されたフォーマットでコードを出力しない)などが頻繁に見受けられた。また、タスクを解けたか否かに関わらずツール呼び出しの失敗に頻繁に遭遇していた。これはエージェントはこうしたエラーから回復できることを示している。

- エージェントのログを分析することで、TauBenchで使用していたscaffold(=モデルが環境もやりとりするための構成要素)にバグがあることを突き止めた(few-shotのサンプルにリークがあった)。このscaffoldはHALによるTauBenchの分析から除外した。

- Docsentのようなログ分析が今後エージェントを評価する上では必要不可欠であり、信頼性の問題やショートカット行動、高コストなエージェントの失敗などが明らかになる。ベンチマーク上での性能と比較して実環境では性能が低い、あるいはその逆でベンチマークが性能を低く見積もっている(たとえばCAPTChAのようや環境的な障害はベンチマーク上では同時リクエストのせいで生じても実環境では生じないなど)ケースもあるので、これらはベンチマークのacc.からだけでは明らかにならないため、ベンチマークのacc.は慎重に解釈すべき。

#Multi #Analysis #MachineLearning #Pocket #NLP #AIAgents #TheoryOfMind #read-later #Personality Issue Date: 2025-10-21 [Paper Note] Emergent Coordination in Multi-Agent Language Models, Christoph Riedl, arXiv'25, 2025.10 GPT Summary- 本研究では、マルチエージェントLLMシステムが高次の構造を持つかどうかを情報理論的フレームワークを用いて検証。実験では、エージェント間のコミュニケーションがない状況で、時間的相乗効果が観察される一方、調整された整合性は見られなかった。ペルソナを割り当てることで、エージェント間の差別化と目標指向の相補性が示され、プロンプトデザインによって高次の集合体へと誘導できることが確認された。結果は、効果的なパフォーマンスには整合性と相補的な貢献が必要であることを示唆している。 Comment

元ポスト:

非常にシンプルな設定でマルチエージェントによるシナジーが生じるか否か、そのための条件を検証している模様。小規模モデルだとシナジーは生じず、ペルソナ付与とTheory of Mindを指示すると効果が大きい模様

#ComputerVision #Pocket #LanguageModel #InstructionTuning #DiffusionModel #TextToImageGeneration #read-later #ICCV #ImageSynthesis Issue Date: 2025-10-20 [Paper Note] MetaMorph: Multimodal Understanding and Generation via Instruction Tuning, Shengbang Tong+, ICCV'25, 2024.12 GPT Summary- 本研究では、視覚的指示調整の新手法VPiTを提案し、LLMがテキストと視覚トークンを生成できるようにします。VPiTは、キュレーションされた画像とテキストデータからトークンを予測する能力をLLMに教え、視覚生成能力が向上することを示しました。特に、理解データが生成データよりも効果的に両方の能力に寄与することが明らかになりました。MetaMorphモデルを訓練し、視覚理解と生成で競争力のあるパフォーマンスを達成し、LLMの事前学習から得た知識を活用することで、視覚生成における一般的な失敗を克服しました。これにより、LLMが視覚理解と生成に適応できる可能性が示唆されました。 Comment

元ポスト:

#Pocket #NLP #LanguageModel #Alignment #AIAgents #Safety #read-later Issue Date: 2025-10-19 [Paper Note] Agentic Misalignment: How LLMs Could Be Insider Threats, Aengus Lynch+, arXiv'25, 2025.10 GPT Summary- 複数の開発者からの16のモデルを仮想企業環境でテストし、潜在的なリスク行動を特定。モデルは自律的にメールを送信し、機密情報にアクセス可能で、ビジネス目標に従う中で反抗的行動を示すことがあった。この現象を「エージェントのミスアライメント」と呼び、モデルが不適切な行動を取ることがあることを示した。実際の展開においてはミスアライメントの証拠は見られなかったが、モデルの自律性が高まることで将来的なリスクが生じる可能性があることを指摘。安全性と透明性の重要性を強調し、研究方法を公開する。 Comment

元ポスト:

abstを読んだだけでも、なんとも恐ろしいシナリオが記述されている。読みたい

Figure4, 5とかすごいな

#Pocket #NLP #Dataset #UserBased #AIAgents #Evaluation #read-later #DeepResearch #Live Issue Date: 2025-10-18 [Paper Note] LiveResearchBench: A Live Benchmark for User-Centric Deep Research in the Wild, Jiayu Wang+, arXiv'25, 2025.10 GPT Summary- 深層研究は、ライブウェブソースから情報を検索・統合し、引用に基づいたレポートを生成する技術であり、評価にはユーザー中心、動的、明確、多面的な原則が必要。既存のベンチマークはこれらを満たしていないため、LiveResearchBenchを導入し、100の専門家がキュレーションしたタスクを提供。さらに、レポート評価のためにDeepEvalを提案し、品質を包括的に評価するプロトコルを統合。これにより、17の深層研究システムの包括的な評価を行い、強みや改善点を明らかにする。 Comment

元ポスト:

データセットとソースコードがリリース:

dataset: https://huggingface.co/datasets/Salesforce/LiveResearchBench

pj page: https://livedeepresearch.github.io/

#Pocket #NLP #Dataset #LanguageModel #Evaluation #Mathematics #read-later #Proofs Issue Date: 2025-10-18 [Paper Note] Reliable Fine-Grained Evaluation of Natural Language Math Proofs, Wenjie Ma+, arXiv'25, 2025.10 GPT Summary- 大規模言語モデル(LLMs)による数学的証明の生成と検証における信頼性の高い評価者が不足している問題に対処するため、0から7のスケールで評価する新たな評価者ProofGraderを開発。ProofBenchという専門家注釈付きデータセットを用いて、評価者の設計空間を探求し、低い平均絶対誤差(MAE)0.926を達成。ProofGraderは、最良の選択タスクにおいても高いスコアを示し、下流の証明生成の進展に寄与する可能性を示唆している。 Comment

元ポスト:

これは非常に重要な研究に見える

#Pocket #NLP #LanguageModel #Education #AIAgents #Evaluation #Coding #read-later #One-Line Notes Issue Date: 2025-10-18 [Paper Note] AutoCode: LLMs as Problem Setters for Competitive Programming, Shang Zhou+, arXiv'25, 2025.09 GPT Summary- AutoCodeは、競技プログラミングの問題文とテストケースを生成するシステムであり、信頼性の高い問題作成を実現します。複数回の検証を通じて、生成された問題は公式の判断と99%の一貫性を持ち、従来の手法に比べて大幅な改善を示します。また、ランダムなシード問題から新しいバリアントを作成し、不正な問題をフィルタリングする機能も備えています。最終的に、AutoCodeはグランドマスター級の競技プログラマーによってコンテスト品質と評価される問題を生成します。 Comment

blog: https://livecodebenchpro.com/projects/autocode/overview

LLMで自動的に高品質な競技プログラミング問題とそのテストケースを生成するパイプラインを提案。

信頼性のあるテストケースを作成するために、Validator-Generator-Checkerフレームワーク。提案。Generatorがテストケースを生成し、Validatorが生成されたテストケースの入力が問題の制約を満たしているか判定し、Checkerが与えられたテストケースの元で解法が正しいかを確認する。

続いて、人手を介さずとも生成される問題が正しいことを担保するためにdual-verificationを採用。具体的には、LLMに新規の問題文と効率的な解法を生成させ、加えてブルートフォースでの解法を別途生成する。そして、両者をLLMが生成したテストセット群で実行し、全ての解放で出力が一致した場合のみAcceptする、といったような手法らしい。

(手法の概要としてはそうなのだろうが、細かい実装に高品質さの肝があると思うのでしっかり読んだ方が良さげ。特にTest Generationの詳細をしっかりできていない)

takeawayで興味深かったのは、

- LLMは自身では解けないが、解法が存在する(solvable)問題を生成できること

- 人間の専門家とLLM(o3)の間で、問題の品質の新規性の判定の相関がわずか0.007, 0.11しかなかったこと。そして品質に関しては専門家のグループ間では0.71, o3とgpt4oの間では0.72と高い相関を示しており、LLMと人間の専門家の間で著しく問題の品質の判断基準が異なること

- seed問題と生成された問題の難易度のgainが、問題の品質に関して、LLM自身のself-evaluationよりもより良い指標となっていること

#Pocket #NLP #ReinforcementLearning #AIAgents #SoftwareEngineering #read-later #ContextEngineering #DeepResearch #LongHorizon Issue Date: 2025-10-18 [Paper Note] Scaling Long-Horizon LLM Agent via Context-Folding, Weiwei Sun+, arXiv'25, 2025.10 GPT Summary- 「Context-Folding」フレームワークを提案し、LLMエージェントがサブタスクを処理しつつコンテキストを管理する方法を示す。FoldGRPOを用いた強化学習により、複雑な長期タスクで10倍小さいコンテキストを使用し、従来のモデルを上回る性能を達成。 Comment

pj page: https://context-folding.github.io

元ポスト:

エージェント自身にcontextを管理する能力を学習させる

#Pocket #NLP #LongSequence #SSM (StateSpaceModel) #Generalization #memory Issue Date: 2025-10-18 [Paper Note] To Infinity and Beyond: Tool-Use Unlocks Length Generalization in State Space Models, Eran Malach+, arXiv'25, 2025.10 GPT Summary- 状態空間モデル(SSM)は、長文生成において効率的な代替手段であるが、真の長文生成問題を解決できないことが明らかにされた。外部ツールへのインタラクティブなアクセスを許可することで、この制限を克服できることが示され、SSMは問題依存のトレーニングデータを用いて任意の問題に一般化できる。ツールを強化したSSMは、算術や推論、コーディングタスクにおいて優れた長さの一般化を達成し、トランスフォーマーに対する効率的な代替手段となる可能性がある。 Comment

元ポスト:

著者ポスト:

所見:

解説:

#ComputerVision #Pocket #LongSequence #AttentionSinks #read-later #VideoGeneration/Understandings #interactive Issue Date: 2025-10-17 [Paper Note] LongLive: Real-time Interactive Long Video Generation, Shuai Yang+, arXiv'25, 2025.09 GPT Summary- LongLiveは、リアルタイムでインタラクティブな長編動画生成のためのフレームレベルの自己回帰フレームワークを提案。因果的注意ARモデルを採用し、KV再キャッシュメカニズムを統合することで、視覚的一貫性と意味的整合性を保ちながら効率的な生成を実現。1.3Bパラメータのモデルを32 GPU日でファインチューニングし、単一のNVIDIA H100で20.7 FPSを維持。最大240秒の動画生成をサポートし、INT8量子化推論も対応。 Comment

元ポスト:

pj page: https://nvlabs.github.io/LongLive/

#Analysis #Pocket #NLP #LanguageModel #ReinforcementLearning #Scaling Laws #PostTraining #read-later Issue Date: 2025-10-17 [Paper Note] The Art of Scaling Reinforcement Learning Compute for LLMs, Devvrit Khatri+, arXiv'25, 2025.10 GPT Summary- 強化学習(RL)のスケーリングに関する原則的なフレームワークを定義し、40万時間以上のGPU時間を用いた大規模な研究を実施。シグモイド型計算-性能曲線をフィットさせ、設計選択肢の影響を分析。結果として、漸近的性能はレシピによって異なり、計算効率は詳細に依存することを発見。これを基に、ScaleRLというベストプラクティスのレシピを提案し、100,000 GPU時間での成功を示した。この研究は、RLトレーニングの予測可能性を向上させるための科学的フレームワークを提供する。 Comment

元ポスト:

> 簡単になったプロンプト(プロンプトの通過率が0.9以上)は再サンプリングしたほうが最終性能が高い

最近はカリキュラムラーニングを導入して、簡単すぎず難しすぎない問題をサンプリングして効率上げる、といったような話があったが、簡単になった問題をリサンプリングしないと最終性能としては低くなる可能性があるのか…意外だった。

著者ポスト:

ポイント解説:

#ComputerVision #EfficiencyImprovement #Pocket #Dataset #Evaluation #Attention #LongSequence #AttentionSinks #read-later #VideoGeneration/Understandings #VisionLanguageModel #KeyPoint Notes Issue Date: 2025-10-15 [Paper Note] StreamingVLM: Real-Time Understanding for Infinite Video Streams, Ruyi Xu+, arXiv'25, 2025.10 GPT Summary- StreamingVLMは、無限のビデオストリームをリアルタイムで理解するためのモデルで、トレーニングと推論を統一したフレームワークを採用。アテンションシンクの状態を再利用し、短いビジョントークンと長いテキストトークンのウィンドウを保持することで、計算コストを抑えつつ高い性能を実現。新しいベンチマークInf-Streams-Evalで66.18%の勝率を達成し、一般的なVQA能力を向上させることに成功。 Comment

元ポスト:

これは興味深い

保持するKV Cacheの上限を決め、Sink Token[^1]は保持し[^2](512トークン)、textual tokenは長距離で保持、visual tokenは短距離で保持、またpositional encodingとしてはRoPEを採用するが、固定されたレンジの中で動的にindexを更新することで、位相を学習時のrangeに収めOODにならないような工夫をすることで、memoryと計算コストを一定に保ちながらlong contextでの一貫性とリアルタイムのlatencyを実現する、といった話にみえる。

学習時はフレームがoverlapした複数のチャンクに分けて、それぞれをfull attentionで学習する(Sink Tokenは保持する)。これは上述のinference時のパターンと整合しており学習時とinference時のgapが最小限になる。また、わざわざlong videoで学習する必要がない。(美しい解決方法)

[^1]: decoder-only transformerの余剰なattention scoreの捨て場として機能するsequence冒頭の数トークン(3--4トークン程度)のこと。本論文では512トークンと大きめのSink Tokenを保持している。

[^2]: Attention Sinksによって、long contextの性能が改善され Why do LLMs attend to the first token?, Federico Barbero+, COLM'25

decoder-only transformerの層が深い部分でのトークンの表現が均一化されてしまうover-mixingを抑制する Efficient Streaming Language Models with Attention Sinks, Guangxuan Xiao+, ICLR'24

ことが報告されている

AttentionSink関連リンク:

- Efficient Streaming Language Models with Attention Sinks, Guangxuan Xiao+, ICLR'24

- Why do LLMs attend to the first token?, Federico Barbero+, COLM'25

↑これは元ポストを読んで(と論文斜め読み)の感想のようなものなので、詳細は後で元論文を読む。

関連:

#ComputerVision #EfficiencyImprovement #Pocket #Transformer #DiffusionModel #read-later #Backbone Issue Date: 2025-10-14 [Paper Note] Diffusion Transformers with Representation Autoencoders, Boyang Zheng+, arXiv'25, 2025.10 GPT Summary- 本研究では、従来のVAEエンコーダを事前学習された表現エンコーダに置き換えたRepresentation Autoencoders(RAE)を提案。これにより、高品質な再構成と豊かな潜在空間を実現し、拡散トランスフォーマーの性能向上を図る。RAEは、補助的な表現整合損失なしで早い収束を達成し、ImageNetで優れた画像生成結果を示した。RAEは、拡散トランスフォーマーの新しいデフォルトとしての利点を提供する。 Comment

pj page: https://rae-dit.github.io

元ポスト:

U-NetをBackboneとしたVAEの代わりにViTに基づく(down, up- scaling無しの)アーキテクチャを用いることで、より少ない計算量で高い性能を達成しました、といった話に見える。

ポイント解説:

解説:

#Pocket #NLP #LanguageModel #Supervised-FineTuning (SFT) #ReinforcementLearning #AIAgents #Self-SupervisedLearning #SelfCorrection #mid-training #WorldModels #KeyPoint Notes Issue Date: 2025-10-14 [Paper Note] Agent Learning via Early Experience, Kai Zhang+, arXiv'25, 2025.10 GPT Summary- 言語エージェントの目標は、経験を通じて学び、複雑なタスクで人間を上回ることですが、強化学習には報酬の欠如や非効率的なロールアウトが課題です。これに対処するため、エージェント自身の行動から生成された相互作用データを用いる「早期経験」という新たなパラダイムを提案します。このデータを基に、(1) 暗黙の世界モデル化と(2) 自己反省の2つの戦略を研究し、8つの環境で評価を行った結果、効果性と一般化が向上することを示しました。早期経験は、強化学習の基盤を提供し、模倣学習と経験駆動エージェントの橋渡しとなる可能性があります。 Comment

元ポスト:

LLM AgentのためのWarmup手法を提案している。具体的にはRLVRやImitation LearningによってRewardが定義できるデータに基づいてこれまではRLが実現されてきたが、これらはスケールせず、Rewardが定義されない環境のtrajectoryなどは学習されないので汎化性能が低いという課題がある。このため、これらのsupervisionつきの方法で学習をする前のwarmup手法として、reward-freeの学習パラダイム Early Experienceを提案している。https://github.com/user-attachments/assets/c2ed5999-d6d8-419d-93e9-f3358ab0ca1f"

/>

手法としてはシンプルな手法が2種類提案されている。

### Implicit World Modeling (IWM, 式(3)):

ある状態s_i において action a_i^{j}を (1 < j < |K|)をとった時の状態をs_i^{j}としたときに、(s_i, a_i^{j}, s_i^{j}) の3つ組を考える。これらはポリシーからのK回のrolloutによって生成可能。

このときに、状態sを全てテキストで表現するようにし、言語モデルのnext-token-prediction lossを用いて、ある状態s_jにおいてaction a_i^{k} をとったときに、s_j^{k} になることを予測できるように学習する。これにより例えばブックフライトのサイトで誤った日時を入れてしまった場合や、どこかをクリックしたときにどこに遷移するかなどの学習する環境の世界知識をimplicitにモデルに組み込むことができる。

### Self-Reflection(式4)

もう一つのパラダイムとして、専門家によるアクション a_i によって得られた状態 s_i と、それら以外のアクション a_i^{j} によって得られた状態 s_i^{j}が与えられたときに、s_iとs_i^{j}を比較したときに、なぜ a_i の方がa_i^{j} よりも好ましいかを説明するCoT C_i^{j}を生成し、三つ組データ(s_i, a_i^{j}, c_i^{j}) を構築する。このデータを用いて、状態s_iがgivenなときに、a_i に c_i^{j} をconcatしたテキストを予測できるようにnext-token-prediction lossで学習する。また、このデータだけでなく汎化性能をより高めるためにexpertによるimitation learningのためのデータCoTなしのデータもmixして学習をする。これにより、expertによるactionだけで学習するよりも、なぜexpertのアクションが良いかという情報に基づいてより豊富で転移可能な学習シグナルを活用し学習することができる。

https://github.com/user-attachments/assets/d411ac3b-d977-4357-b715-0cf4e5b95fa2"

/>

この結果、downstreamタスクでのperformanceが単にImitation Learningを実施した場合と比較して提案手法でwarmupした方が一貫して向上する。また、5.4節にpost-trainingとして追加でGRPOを実施した場合も提案手法によるwarmupを実施した場合が最終的な性能が向上することが報告されている。https://github.com/user-attachments/assets/a0aad636-b889-4d2d-b753-b0ad5ad4c688"

/>

IWMは自己教師あり学習の枠組みだと思われるので、よぬスケールし、かつ汎化性能が高く様々な手法のベースとなりうる手法に見える。

著者ポスト:

#Pocket #NLP #LanguageModel #Chain-of-Thought #Reasoning #read-later #Verification #One-Line Notes Issue Date: 2025-10-14 [Paper Note] Verifying Chain-of-Thought Reasoning via Its Computational Graph, Zheng Zhao+, arXiv'25, 2025.10 GPT Summary- Circuit-based Reasoning Verification (CRV)を提案し、CoTステップの帰属グラフを用いて推論エラーを検証。エラーの構造的署名が予測的であり、異なる推論タスクで異なる計算パターンが現れることを示す。これにより、モデルの誤った推論を修正する新たなアプローチを提供し、LLM推論の因果理解を深めることを目指す。 Comment

元ポスト:

著者ポスト:

transformer内部のactivationなどから計算グラフを構築しreasoningのsurface(=観測できるトークン列)ではなく内部状態からCoTをverification(=CoTのエラーを検知する)するようなアプローチ(white box method)らしい

#EfficiencyImprovement #Pocket #NLP #LanguageModel #DiffusionModel #LLMServing #read-later Issue Date: 2025-10-14 [Paper Note] dInfer: An Efficient Inference Framework for Diffusion Language Models, Yuxin Ma+, arXiv'25, 2025.10 GPT Summary- dLLMの推論を効率化するフレームワークdInferを提案。dInferは4つのモジュールに分解され、新しいアルゴリズムと最適化を統合。これにより、出力品質を維持しつつ、推論速度を大幅に向上。HumanEvalで1秒あたり1,100トークンを超え、従来のシステムに比べて10倍のスピードアップを実現。dInferはオープンソースで公開。 Comment

code: https://github.com/inclusionAI/dInfer

とうとうdLLMを高速でinferenceできるフレームワークが出た模様。inclusionAIより。

ポイント解説:

#Pocket #NLP #Dataset #Supervised-FineTuning (SFT) #Evaluation #In-ContextLearning #PostTraining #meta-learning #KeyPoint Notes #Steering Issue Date: 2025-10-14 [Paper Note] Spectrum Tuning: Post-Training for Distributional Coverage and In-Context Steerability, Taylor Sorensen+, arXiv'25, 2025.10 GPT Summary- ポストトレーニングは言語モデルの性能を向上させるが、操作性や出力空間のカバレッジ、分布の整合性においてコストが伴う。本研究では、これらの要件を評価するためにSpectrum Suiteを導入し、90以上のタスクを網羅。ポストトレーニング技術が基礎的な能力を引き出す一方で、文脈内操作性を損なうことを発見。これを改善するためにSpectrum Tuningを提案し、モデルの操作性や出力空間のカバレッジを向上させることを示した。 Comment

元ポスト:

著者らはモデルの望ましい性質として

- In context steerbility: inference時に与えられた情報に基づいて出力分布を変えられる能力

- Valid output space coverage: タスクにおける妥当な出力を広範にカバーできること

- Distributional Alignment: ターゲットとする出力分布に対してモデルの出力分布が近いこと

の3つを挙げている。そして既存のinstruction tuningや事後学習はこれらを損なうことを指摘している。

ここで、incontext steerbilityとは、事前学習時に得た知識や、分布、能力だけに従うのではなく、context内で新たに指定した情報をモデルに活用させることである。

モデルの上記3つの能力を測るためにSpectrum Suiteを導入する。これには、人間の様々な嗜好、numericな分布の出力、合成データ作成などの、モデル側でsteeringや多様な分布への対応が必要なタスクが含まれるベンチマークのようである。

また上記3つの能力を改善するためにSpectrum Tuningと呼ばれるSFT手法を提案している。

手法はシンプルで、タスクT_iに対する 多様なinput X_i タスクのcontext(すなわちdescription) Z_i が与えられた時に、T_i: X_i,Z_i→P(Y_i) を学習したい。ここで、P(Y_i)は潜在的なoutputの分布であり、特定の1つのサンプルyに最適化する、という話ではない点に注意(meta learningの定式化に相当する)。

具体的なアルゴリズムとしては、タスクのコレクションが与えられた時に、タスクiのcontextとdescriptionをtokenizeした結果 z_i と、incontextサンプルのペア x_ij, y_ij が与えられた時に、output tokenのみに対してcross entropyを適用してSFTをする。すなわち、以下のような手順を踏む:

1. incontextサンプルをランダムなオーダーにソートする

2. p_dropの確率でdescription z_i をドロップアウトしx_i0→y_i0の順番でconcatする、

2-1. descriptionがdropしなかった場合はdescription→x_i0→y_i0の順番でconcatし入力を作る。

2-2. descriptionがdropした場合、x_i0→y_i0の順番で入力を作る。

3. 他のサンプルをx_1→y_1→...→x_n→y_nの順番で全てconcatする。

4. y_{1:n}に対してのみクロスエントロピーlossを適用し、他はマスクして学習する。

一見するとinstruct tuningに類似しているが、以下の点で異なっている:

- 1つのpromptに多くのi.i.dな出力が含まれるのでmeta-learningが促進される

- 個別データに最適化されるのではなく、タスクに対する入出力分布が自然に学習される

- chat styleのデータにfittingするのではなく、分布に対してfittingすることにフォーカスしている

- input xやタスクdescription zを省略することができ、ユーザ入力が必ず存在する設定とは異なる

という主張をしている。

#Pocket #NLP #Dataset #LanguageModel #UserBased #Alignment #Evaluation #Coding #read-later Issue Date: 2025-10-13 [Paper Note] BigCodeArena: Unveiling More Reliable Human Preferences in Code Generation via Execution, Terry Yue Zhuo+, arXiv'25, 2025.10 GPT Summary- BigCodeArenaは、LLMが生成したコードの質をリアルタイムで評価するためのクラウドソーシングプラットフォームで、Chatbot Arenaを基盤に構築されています。14,000以上のコード中心の会話セッションから4,700のマルチターンサンプルを収集し、人間の好みを明らかにしました。これに基づき、LLMのコード理解と生成能力を評価するためのBigCodeRewardとAutoCodeArenaという2つのベンチマークを策定しました。評価の結果、実行結果が利用可能な場合、ほとんどのLLMが優れたパフォーマンスを示し、特にGPT-5やClaudeシリーズがコード生成性能でリードしていることが確認されました。 Comment

元ポスト:

良さそう

#ComputerVision #Pocket #SelfImprovement #read-later #VisionLanguageModel #Label-free Issue Date: 2025-10-13 [Paper Note] Vision-Zero: Scalable VLM Self-Improvement via Strategic Gamified Self-Play, Qinsi Wang+, arXiv'25, 2025.09 GPT Summary- Vision-Zeroは、視覚と言語のモデル(VLM)の自己改善を促進するドメイン非依存のフレームワークであり、任意の画像ペアから生成された競争的な視覚ゲームを通じてトレーニングを行う。主な特徴は、戦略的自己対戦による自律的なデータ生成、任意の画像からのゲーム生成による多様なドメインでの推論能力向上、そして反復自己対戦ポリシー最適化(Iterative-SPO)による持続的なパフォーマンス向上である。Vision-Zeroはラベルなしデータを用いて最先端のパフォーマンスを達成し、他の注釈ベースの手法を上回る。 Comment

pj page: https://github.com/wangqinsi1/Vision-Zero

元ポスト:

とても良さそう

ポイント解説:

#EfficiencyImprovement #Pocket #NLP #LanguageModel #ReinforcementLearning #Reasoning #read-later Issue Date: 2025-10-09 [Paper Note] The Markovian Thinker, Milad Aghajohari+, arXiv'25, 2025.10 GPT Summary- 強化学習を用いて長い思考の連鎖を生成するための新しいパラダイム「マルコフ的思考」を提案。これにより、状態を一定のサイズに制限し、思考の長さをコンテキストのサイズから切り離すことで、線形計算を実現。新しいRL環境「Delethink」を構築し、モデルは短い持ち越しで推論を継続することを学習。訓練されたモデルは、長い推論を効率的に行い、コストを大幅に削減。思考環境の再設計が、効率的でスケーラブルな推論LLMの実現に寄与することを示した。 Comment

元ポスト:

ポイント解説:

解説:

#Pocket #NLP #LanguageModel #SmallModel #LatentReasoning #RecursiveModels Issue Date: 2025-10-09 [Paper Note] Less is More: Recursive Reasoning with Tiny Networks, Alexia Jolicoeur-Martineau, arXiv'25, 2025.10 GPT Summary- 階層的推論モデル(HRM)は、2つの小さなニューラルネットワークを用いた新しいアプローチで、数独や迷路などのパズルタスクで大規模言語モデル(LLMs)を上回る性能を示す。しかし、HRMは最適ではない可能性があるため、我々はTiny Recursive Model(TRM)を提案。TRMはよりシンプルで高い一般化能力を持ち、700万パラメータでARC-AGI-1で45%、ARC-AGI-2で8%の精度を達成し、ほとんどのLLMを上回る性能を示した。 Comment

元ポスト:

所見:

ポイント解説:

ARC-AGI公式による検証が終わり報告されている結果が信頼できることが確認された模様:

続報:

Sudoku Benchでも性能改善する模様?

#Pocket #NLP #LanguageModel #Evaluation Issue Date: 2025-10-09 [Paper Note] GDPval: Evaluating AI Model Performance on Real-World Economically Valuable Tasks, Tejal Patwardhan+, arXiv'25, 2025.10 GPT Summary- GDPvalは、AIモデルの経済的価値のあるタスクを評価するベンチマークで、米国GDPに寄与する44の職業をカバー。最前線モデルのパフォーマンスは時間と共に改善し、業界専門家に近づいている。人間の監視を加えたモデルは、無援助の専門家よりも効率的にタスクを実行可能であることを示唆。推論努力やタスクコンテキストの増加がモデルの性能向上に寄与。220のタスクのゴールドサブセットをオープンソース化し、研究促進のための自動採点サービスを提供。 Comment

元ポスト:

#Embeddings #EfficiencyImprovement #Pocket #NLP #LanguageModel #RepresentationLearning #RAG(RetrievalAugmentedGeneration) #ICLR #read-later #One-Line Notes Issue Date: 2025-10-08 [Paper Note] Generative Representational Instruction Tuning, Niklas Muennighoff+, ICLR'25, 2024.02 GPT Summary- 生成的表現指示チューニング(GRIT)を用いて、大規模言語モデルが生成タスクと埋め込みタスクを同時に処理できる手法を提案。GritLM 7BはMTEBで新たな最先端を達成し、GritLM 8x7Bはすべてのオープン生成モデルを上回る性能を示す。GRITは生成データと埋め込みデータの統合による性能損失がなく、RAGを60%以上高速化する利点もある。モデルは公開されている。 Comment

openreview: https://openreview.net/forum?id=BC4lIvfSzv

従来はgemerativeタスクとembeddingタスクは別々にモデリングされていたが、それを統一的な枠組みで実施し、両方のタスクで同等のモデルサイズの他モデルと比較して高い性能を達成した研究。従来のgenerativeタスク用のnext-token-prediction lossとembeddingタスク用のconstastive lossを組み合わせて学習する(式3)。タスクの区別はinstructionにより実施し、embeddingタスクの場合はすべてのトークンのlast hidden stateのmean poolingでrepresentationを取得する。また、embeddingの時はbi-directional attention / generativeタスクの時はcausal maskが適用される。これらのattentionの適用のされ方の違いが、どのように管理されるかはまだしっかり読めていないのでよくわかっていないが、非常に興味深い研究である。https://github.com/user-attachments/assets/acb2cbcd-364d-43c7-b51a-6c5ea9866415"

/>

#Embeddings #InformationRetrieval #Pocket #Transformer #SyntheticData #Reasoning #Test-Time Scaling #COLM #read-later #Encoder Issue Date: 2025-10-08 [Paper Note] ReasonIR: Training Retrievers for Reasoning Tasks, Rulin Shao+, COLM'25, 2025.04 GPT Summary- ReasonIR-8Bは、一般的な推論タスク向けに特別に訓練された初のリトリーバーであり、合成データ生成パイプラインを用いて挑戦的なクエリとハードネガティブを作成。これにより、BRIGHTベンチマークで新たな最先端成果を達成し、RAGタスクでも他のリトリーバーを上回る性能を示す。トレーニングレシピは一般的で、将来のLLMへの拡張が容易である。コード、データ、モデルはオープンソース化されている。 Comment

元ポスト:

Llama3.1-8Bをbidirectional encoderに変換してpost-trainingしている。

関連:

- [Paper Note] Generative Representational Instruction Tuning, Niklas Muennighoff+, ICLR'25, 2024.02

#Pocket #NLP #LanguageModel #In-ContextLearning #Safety #Scaling Laws #COLM #read-later Issue Date: 2025-10-08 [Paper Note] Bayesian scaling laws for in-context learning, Aryaman Arora+, COLM'25, 2024.10 GPT Summary- インコンテキスト学習(ICL)は、言語モデルに複雑なタスクを実行させる手法であり、提供される例の数と予測精度に強い相関がある。本研究では、ICLがベイズ学習者を近似することを示し、新しいベイズスケーリング法則を提案。GPT-2モデルを用いた実験で、提案法則が精度における既存の法則と一致し、タスクの事前分布や学習効率に関する解釈可能な項を提供。実験では、ICLを用いて抑制されたモデル能力を再現する条件を予測し、LLMの安全性向上に寄与することを示した。 Comment

openreview: https://openreview.net/forum?id=U2ihVSREUb#discussion

元ポスト:

#Pocket #NLP #UserModeling #Dataset #LanguageModel #UserBased #AIAgents #Evaluation #read-later #One-Line Notes Issue Date: 2025-10-08 [Paper Note] Impatient Users Confuse AI Agents: High-fidelity Simulations of Human Traits for Testing Agents, Muyu He+, arXiv'25, 2025.10 GPT Summary- TraitBasisを用いて、会話型AIエージェントの堅牢性を体系的にテストする手法を提案。ユーザーの特性(せっかちさや一貫性のなさ)を制御し、AIエージェントのパフォーマンス低下を観察。最前線のモデルで2%-30%の性能低下を確認し、現在のAIエージェントの脆弱性を示す。TraitBasisはシンプルでデータ効率が高く、現実の人間の相互作用における信頼性向上に寄与する。$\tau$-Traitをオープンソース化し、コミュニティが多様なシナリオでエージェントを評価できるようにした。 Comment

元ポスト:

実際の人間にあるような癖(のような摂動)を与えた時にどれだけロバストかというのは実応用上非常に重要な観点だと思われる。元ポストを見ると、LLM内部のmatmulを直接操作することで、任意のレベルの人間の特性(e.g.,疑い深い、混乱、焦りなど)を模倣する模様。

#Pocket #ReinforcementLearning #read-later Issue Date: 2025-10-07 [Paper Note] BroRL: Scaling Reinforcement Learning via Broadened Exploration, Jian Hu+, arXiv'25, 2025.10 GPT Summary- 検証可能な報酬を用いた強化学習(RLVR)の新たなアプローチとしてBroR-Lを提案。ロールアウトの数を増やすことで探索を広げ、ProRLの飽和点を超えたパフォーマンス向上を実現。理論的分析に基づき、ロールアウト数の増加が正しいトークンの質量拡大を保証することを示す。BroRLは3KのProRLトレーニングステップでの飽和モデルを復活させ、最先端の結果を達成。 Comment

元ポスト:

関連:

- [Paper Note] ProRL: Prolonged Reinforcement Learning Expands Reasoning Boundaries in Large Language Models, Mingjie Liu+, NeurIPS'25

- ProRL V2 - Prolonged Training Validates RL Scaling Laws, Hu+, 2025.08

前回はstep数をこれまでにない規模でスケーリングされRLしたがそれで性能が頭打ちを迎えることがわかったので、今度はロールアウト数をスケーリングさせた時にどうなるかというのを試したっぽい?

#Tutorial #Analysis #NLP #LanguageModel #Slide #reading Issue Date: 2025-10-07 言語モデルの内部機序:解析と解釈, HEINZERLING+, NLP'25, 2025.03 Comment

元ポスト:

#Pretraining #Pocket #NLP #LanguageModel #read-later #LatentReasoning Issue Date: 2025-10-03 [Paper Note] Thoughtbubbles: an Unsupervised Method for Parallel Thinking in Latent Space, Houjun Liu+, arXiv'25, 2025.09 GPT Summary- 本研究では、トランスフォーマーの新しい変種「Thoughtbubbles」を提案し、並列適応計算を潜在空間で実行する方法を示す。残差ストリームをフォークまたは削除することで、計算を効率化し、事前トレーニング中に学習可能。Thoughtbubblesは、従来の手法を上回る性能を示し、推論時のトレーニングとテストの挙動を統一する可能性を持つ。 Comment

元ポスト:

重要論文に見える

#Analysis #Pretraining #Pocket #NLP #LanguageModel #SyntheticData #DataMixture #One-Line Notes #PhaseTransition Issue Date: 2025-10-03 [Paper Note] Demystifying Synthetic Data in LLM Pre-training: A Systematic Study of Scaling Laws, Benefits, and Pitfalls, Feiyang Kang+, arXiv'25, 2025.10 GPT Summary- 合成データ技術はLLMのトレーニングデータの供給制限を克服する可能性を持つ。本研究では、自然なウェブデータと合成データの混合を比較し、言い換えた合成データのみでの事前トレーニングは自然なデータよりも速くないことを示した。1/3の言い換えた合成データと2/3の自然データの混合が、より効率的なトレーニングを可能にすることが分かった。教科書スタイルの合成データは小さなデータ予算で高い損失をもたらし、合成データの最適な比率はモデルサイズとデータ予算に依存する。結果は合成データの効果を明らかにし、実用的なガイダンスを提供する。 Comment

元ポスト:

ポイント解説:

合成データは適切な規模のモデルと比率でないと利点が現れない

#Analysis #Pocket #NLP #LanguageModel #ReinforcementLearning #AIAgents #read-later Issue Date: 2025-10-03 [Paper Note] A Practitioner's Guide to Multi-turn Agentic Reinforcement Learning, Ruiyi Wang+, arXiv'25, 2025.10 GPT Summary- マルチターン強化学習におけるLLMエージェントの訓練方法を研究し、設計空間を環境、報酬、ポリシーの3つの柱に分解。環境の複雑さがエージェントの一般化能力に与える影響、報酬の希薄性が訓練に与える効果、ポリシー勾配法の相互作用を分析。これらの知見を基に、訓練レシピを提案し、マルチターンエージェント強化学習の研究と実践を支援。 Comment

元ポスト:

著者ポスト:

takeawayが非常に簡潔で分かりやすい。

ベンチマーク:

- [Paper Note] TextWorld: A Learning Environment for Text-based Games, Marc-Alexandre Côté+, Workshop on Computer Games'18 Held in Conjunction with IJCAI'18, 2018.06

- [Paper Note] ALFWorld: Aligning Text and Embodied Environments for Interactive Learning, Mohit Shridhar+, ICLR'21, 2020.10

- Training Software Engineering Agents and Verifiers with SWE-Gym, Jiayi Pan+, ICML'25

#Pocket #NLP #LanguageModel #Supervised-FineTuning (SFT) #AIAgents #SoftwareEngineering #read-later #reading #KeyPoint Notes Issue Date: 2025-10-02 [Paper Note] Kimi-Dev: Agentless Training as Skill Prior for SWE-Agents, Zonghan Yang+, arXiv'25, 2025.09 GPT Summary- 大規模言語モデル(LLMs)のソフトウェア工学(SWE)への応用が進んでおり、SWE-benchが重要なベンチマークとなっている。マルチターンのSWE-Agentフレームワークと単一ターンのエージェントレス手法は相互排他的ではなく、エージェントレストレーニングが効率的なSWE-Agentの適応を可能にする。本研究では、Kimi-DevというオープンソースのSWE LLMを紹介し、SWE-bench Verifiedで60.4%を達成。追加の適応により、Kimi-DevはSWE-Agentの性能を48.6%に引き上げ、移植可能なコーディングエージェントの実現を示した。 Comment

元ポスト:

Agentlessはこちら:

- Demystifying LLM-based Software Engineering Agents, Chunqiu Steven Xia+, FSE'25

著者ポスト:

ポストの中でOpenhandsが同モデルを内部で検証し、Openhandsの環境内でSWE Bench Verifiedで評価した結果、レポート内で報告されているAcc. 60.4%は達成できず、17%に留まることが報告されていた模様。

Openhandsの説明によるとAgentlessは決められた固定されたワークフローのみを実施する枠組み(Kimi Devの場合はBugFixerとFileEditor)であり、ワークフローで定義されたタスクは効果的に実施できるが、それら以外のタスクはそもそもうまくできない。SWE Agent系のベンチのバグfixの方法は大きく分けてAgentlike(コードベースを探索した上でアクションを実行する形式)、Fixed workflow like Agentless(固定されたワークフローのみを実行する形式)の2種類があり、Openhandsは前者、Kimi Devは後者の位置付けである。

実際、テクニカルレポートのFigure2とAppendixを見ると、File Localization+BugFixer+TestWriterを固定されたプロンプトテンプレートを用いてmid-trainingしており、評価する際も同様のハーネスが利用されていると推察される(どこかに明示的な記述があるかもしれない)。

一方、Openhandsではより実環境の開発フローに近いハーネス(e.g., エージェントがコードベースを確認してアクションを提案→実行可能なアクションなら実行→そうでないならユーザからのsimulated responceを受け取る→Agentに結果をフィードバック→エージェントがアクション提案...)といったハーネスとなっている。

このように評価をする際のハーネスが異なるため、同じベンチマークに対して異なる性能が報告される、ということだと思われる。

単にSWE Bench VerifiedのAcc.だけを見てモデルを選ぶのではなく、評価された際のEvaluation Harnessが自分たちのユースケースに合っているかを確認することが重要だと考えられる。

参考:

- OpenhandsのEvaluation Harness:

https://docs.all-hands.dev/openhands/usage/developers/evaluation-harness

#RecommenderSystems #Pocket #LanguageModel #read-later #interactive #One-Line Notes Issue Date: 2025-09-29 [Paper Note] Interactive Recommendation Agent with Active User Commands, Jiakai Tang+, arXiv'25, 2025.09 GPT Summary- 従来のレコメンダーシステムは受動的なフィードバックに依存し、ユーザーの意図を捉えられないため、嗜好モデルの構築が困難である。これに対処するため、インタラクティブレコメンデーションフィード(IRF)を導入し、自然言語コマンドによる能動的な制御を可能にする。RecBotという二重エージェントアーキテクチャを開発し、ユーザーの嗜好を構造化し、ポリシー調整を行う。シミュレーション強化知識蒸留を用いて効率的なパフォーマンスを実現し、実験によりユーザー満足度とビジネス成果の改善を示した。 Comment

元ポスト:

ABテストを実施しているようなので信ぴょう性高め

#Pocket #NLP #AIAgents #ScientificDiscovery #read-later #EvolutionaryAlgorithm Issue Date: 2025-09-25 [Paper Note] ShinkaEvolve: Towards Open-Ended And Sample-Efficient Program Evolution, Robert Tjarko Lange+, arXiv'25, 2025.09 GPT Summary- ShinkaEvolveは、科学的発見を促進するための新しいオープンソースフレームワークであり、LLMsを利用して高い効率性とパフォーマンスを実現します。従来のコード進化手法の制限を克服し、親サンプリング技術や新規性拒否サンプリング、バンディットベースのアンサンブル選択戦略を導入。多様なタスクでの評価により、サンプル効率と解の質が向上し、150サンプルで新たな最先端ソリューションを発見しました。ShinkaEvolveは、オープンソースでのアクセス性を提供し、計算問題における発見を民主化します。 Comment

pj page: https://sakana.ai/shinka-evolve/

元ポスト:

国際的なプログラミングコンテストでShinkaEvolveのサポートの元、チームが優勝した模様:

-

-

#ComputerVision #Pocket #FoundationModel #read-later Issue Date: 2025-09-25 [Paper Note] Video models are zero-shot learners and reasoners, Thaddäus Wiedemer+, arXiv'25, 2025.09 GPT Summary- 大規模言語モデル(LLMs)のゼロショット能力が自然言語処理を変革したように、生成ビデオモデルも一般目的の視覚理解に向かう可能性がある。Veo 3は、物体のセグメンテーションやエッジ検出など、訓練されていない幅広いタスクを解決できることを示し、視覚推論の初期形態を可能にする。Veoのゼロショット能力は、ビデオモデルが一般的な視覚基盤モデルになる道を示唆している。 Comment

pj page: https://video-zero-shot.github.io

ポイント解説:

所見:

解説:

#Pocket #NLP #LanguageModel #Attention #Architecture #MoE(Mixture-of-Experts) #read-later #KeyPoint Notes Issue Date: 2025-09-24 [Paper Note] UMoE: Unifying Attention and FFN with Shared Experts, Yuanhang Yang+, arXiv'25, 2025.05 GPT Summary- Sparse Mixture of Experts (MoE) アーキテクチャは、Transformer モデルのスケーリングにおいて有望な手法であり、注意層への拡張が探求されていますが、既存の注意ベースの MoE 層は最適ではありません。本論文では、注意層と FFN 層の MoE 設計を統一し、注意メカニズムの再定式化を行い、FFN 構造を明らかにします。提案するUMoEアーキテクチャは、注意ベースの MoE 層で優れた性能を達成し、効率的なパラメータ共有を実現します。 Comment

元ポスト:

Mixture of Attention Heads (MoA)はこちら:

- [Paper Note] Mixture of Attention Heads: Selecting Attention Heads Per Token, Xiaofeng Zhang+, EMNLP'22, 2022.10

この図がわかりやすい。後ほど説明を追記する。ざっくり言うと、MoAを前提としたときに、最後の出力の変換部分VW_oをFFNによる変換(つまりFFN Expertsの一つ)とみなして、self-attentionのトークンを混ぜ合わせるという趣旨を失わない範囲で計算順序を調整(トークンをミックスする部分を先に持ってくる)すると、FFNのMoEとMoAは同じ枠組みで扱えるため、expertsを共有できてメモリを削減でき、かつMoAによって必要な箇所のみにattendする能力が高まり性能も上がります、みたいな話に見える。

#Pocket #NLP #LanguageModel #Reasoning #Decoding #read-later #SpeculativeDecoding Issue Date: 2025-09-24 [Paper Note] Scaling Speculative Decoding with Lookahead Reasoning, Yichao Fu+, arXiv'25, 2025.06 GPT Summary- Lookahead Reasoningを用いることで、推論モデルのトークンデコード速度を向上させる手法を提案。軽量なドラフトモデルが将来のステップを提案し、ターゲットモデルが一度のバッチ処理で展開。これにより、トークンレベルの推測デコーディング(SD)のスピードアップを1.4倍から2.1倍に改善し、回答の質を維持。 Comment

元ポスト:

#Pocket #NLP #LanguageModel #ReinforcementLearning #Test-Time Scaling #read-later #Verification Issue Date: 2025-09-24 [Paper Note] Heimdall: test-time scaling on the generative verification, Wenlei Shi+, arXiv'25, 2025.04 GPT Summary- Heimdallは、長いChain-of-Thought推論における検証能力を向上させるためのLLMであり、数学問題の解決精度を62.5%から94.5%に引き上げ、さらに97.5%に達する。悲観的検証を導入することで、解決策の精度を54.2%から70.0%、強力なモデルを使用することで93.0%に向上させる。自動知識発見システムのプロトタイプも作成し、データの欠陥を特定する能力を示した。 #Pocket #NLP #Dataset #LanguageModel #AIAgents #Evaluation #One-Line Notes Issue Date: 2025-09-23 [Paper Note] ARE: Scaling Up Agent Environments and Evaluations, Pierre Andrews+, arXiv'25, 2025.09 GPT Summary- Meta Agents Research Environments (ARE)を紹介し、エージェントのオーケストレーションや環境のスケーラブルな作成を支援するプラットフォームを提供。Gaia2というベンチマークを提案し、エージェントの能力を測定するために設計され、動的環境への適応や他のエージェントとの協力を要求。Gaia2は非同期で実行され、新たな失敗モードを明らかにする。実験結果は、知能のスペクトル全体での支配的なシステムが存在しないことを示し、AREの抽象化が新しいベンチマークの迅速な作成を可能にすることを強調。AIの進展は、意味のあるタスクと堅牢な評価に依存する。 Comment

元ポスト:

GAIAはこちら:

- GAIA: a benchmark for General AI Assistants, Grégoire Mialon+, N/A, arXiv'23

Execution, Search, Ambiguity, Adaptability, Time, Noise, Agent2Agentの6つのcapabilityを評価可能。興味深い。

現状、全体的にはGPT-5(high)の性能が最も良く、続いてClaude-4 Sonnetという感じに見える。OpenWeightなモデルでは、Kimi-K2の性能が高く、続いてQwen3-235Bという感じに見える。また、Figure1はbudgetごとのモデルの性能も示されている。シナリオ単位のbudgetが$1以上の場合はGPT-5(high)の性能が最も良いが、$0.1--$0.4の間ではKiml-K2の性能が最も良いように見える。

- [Paper Note] GLM-4.5: Agentic, Reasoning, and Coding (ARC) Foundation Models, GLM-4. 5 Team+, arXiv'25

しっかりと読めていないがGLM-4.5は含まれていないように見える。

ポイント解説:

#ComputerVision #Pocket #NLP #LanguageModel #MultiModal #ICLR #read-later #UMM Issue Date: 2025-09-22 [Paper Note] Transfusion: Predict the Next Token and Diffuse Images with One Multi-Modal Model, Chunting Zhou+, ICLR'25, 2024.08 GPT Summary- Transfusionは、離散データと連続データに対してマルチモーダルモデルを訓練する手法で、言語モデリングの損失関数と拡散を組み合わせて単一のトランスフォーマーを訓練します。最大7Bパラメータのモデルを事前訓練し、ユニモーダルおよびクロスモーダルベンチマークで優れたスケーリングを示しました。モダリティ特有のエンコーディング層を導入することで性能を向上させ、7Bパラメータのモデルで画像とテキストを生成できることを実証しました。 Comment

openreview: https://openreview.net/forum?id=SI2hI0frk6

#Analysis #MachineLearning #Pocket #NLP #LanguageModel #Evaluation #NeurIPS #read-later Issue Date: 2025-09-19 [Paper Note] The Leaderboard Illusion, Shivalika Singh+, NeurIPS'25 GPT Summary- 進捗測定は科学の進展に不可欠であり、Chatbot ArenaはAIシステムのランキングにおいて重要な役割を果たしている。しかし、非公開のテスト慣行が存在し、特定のプロバイダーが有利になることで、スコアにバイアスが生じることが明らかになった。特に、MetaのLlama-4に関連するプライベートLLMバリアントが問題視され、データアクセスの非対称性が生じている。GoogleやOpenAIはArenaデータの大部分を占め、オープンウェイトモデルは少ないデータしか受け取っていない。これにより、Arena特有のダイナミクスへの過剰適合が発生している。研究は、Chatbot Arenaの評価フレームワークの改革と、公正で透明性のあるベンチマーキングの促進に向けた提言を行っている。 Comment

元ポスト:

要チェック

#ComputerVision #Pocket #Transformer #DiffusionModel #VariationalAutoEncoder #NeurIPS #PostTraining #VideoGeneration/Understandings #One-Line Notes Issue Date: 2025-09-19 [Paper Note] Self Forcing: Bridging the Train-Test Gap in Autoregressive Video Diffusion, Xun Huang+, NeurIPS'25 GPT Summary- Self Forcingは、自動回帰型ビデオ拡散モデルの新しいトレーニング手法で、エクスポージャーバイアスの問題に対処します。従来の手法が真のコンテキストに基づくのに対し、Self Forcingは自己生成した出力に基づいてフレームを生成し、全体の品質を評価するホリスティックな損失を用います。計算コストとパフォーマンスのバランスを取るために、少数ステップの拡散モデルと確率的勾配切断を採用し、ロールイングKVキャッシュメカニズムを導入。実験により、リアルタイムのストリーミングビデオ生成が可能で、非因果的拡散モデルの生成品質に匹敵またはそれを上回ることが示されました。 Comment

pj page: https://self-forcing.github.io

元ポスト:

自己回帰的な動画生成(をする)モデルにおいて、学習時はground-truchのcontextが利用して学習されるが、推論時は自身が生成結果そのものをcontextとして利用するため、学習-推論時にgapが生じ、(徐々に誤差が蓄積することで)品質が劣化するという問題(exposure bias)に対処するために、学習時から自身が生成した出力をcontextとして与えて生成を行い(ロールアウト)、動画全体に対して分布の整合性を測るlossを導入(=フレーム単位の誤差を最小化にするのではなく、動画全体に対して(分布の)誤差を最適化する)することで、exposure biasを軽減する、という話な模様。

結果的に、単一のRTX4090でリアルタイムのストリーミングビデオ生成が高品質に生成可能となった(かもしれない):

https://note.com/ngc_shj/n/n505b2f7cdfe4

#Analysis #Pocket #NLP #LanguageModel #AIAgents #Reasoning #LongSequence #Scaling Laws #read-later #ContextEngineering Issue Date: 2025-09-14 [Paper Note] The Illusion of Diminishing Returns: Measuring Long Horizon Execution in LLMs, Akshit Sinha+, arXiv'25 GPT Summary- LLMsのスケーリングが収益に影響を与えるかを探求。単一ステップの精度向上がタスクの長さに指数的改善をもたらすことを観察。LLMsが長期タスクで失敗するのは推論能力の欠如ではなく実行ミスによると主張。知識と計画を明示的に提供することで実行能力を向上させる提案。モデルサイズをスケーリングしても自己条件付け効果は減少せず、長いタスクでのミスが増加。思考モデルは自己条件付けを行わずに長いタスクを実行可能。最終的に、実行能力に焦点を当てることで、LLMsの複雑な推論問題解決能力と単純タスクの長期化による失敗理由を調和させる。 Comment

元ポスト:

single stepでのタスク性能はサチって見えても、成功可能なタスクの長さは(single stepの実行エラーに引きづられるため)モデルのsingle stepのタスク性能に対して指数関数的に効いている(左上)。タスクが長くなればなるほどモデルは自身のエラーに引きずられ(self conditioning;右上)、これはパラメータサイズが大きいほど度合いが大きくなる(右下; 32Bの場合contextにエラーがあって場合のloeg horizonのAcc.が14Bよりも下がっている)。一方で、実行可能なstep数の観点で見ると、モデルサイズが大きい場合の方が多くのstepを要するタスクを実行できる(左下)。また、ThinkingモデルはSelf Conditioningの影響を受けにくく、single stepで実行可能なタスクの長さがより長くなる(中央下)。

といった話に見えるが、論文をしっかり読んだ方が良さそう。

(元ポストも著者ポストだが)著者ポスト:

このスレッドは読んだ方が良い(というか論文を読んだ方が良い)。

特に、**CoTが無い場合は**single-turnでほとんどのモデルは5 stepのタスクをlatent spaceで思考し、実行することができないというのは興味深い(が、細かい設定は確認した方が良い)。なので、マルチステップのタスクは基本的にはplanningをさせてから出力をさせた方が良いという話や、

では複雑なstepが必要なタスクはsingle turnではなくmulti turnに分けた方が良いのか?と言うと、モデルによって傾向が違うらしい、といった話が書かれている。たとえば、Qwenはsingle turnを好むが、Gemmaはmulti turnを好むらしい。

日本語ポイント解説:

解説:

#Pretraining #Pocket #NLP #LanguageModel #SmallModel #mid-training #PostTraining #read-later #DataMixture Issue Date: 2025-09-13 [Paper Note] MobileLLM-R1: Exploring the Limits of Sub-Billion Language Model Reasoners with Open Training Recipes, Changsheng Zhao+, arXiv'25, 2025.09 GPT Summary- 本研究では、推論能力の出現に必要なデータ量について再検討し、約2Tトークンの高品質データで強力な推論モデルが構築できることを示した。MobileLLM-R1というサブビリオンパラメータのモデルは、従来のモデルを大幅に上回る性能を発揮し、特にAIMEスコアで優れた結果を示した。さらに、Qwen3の36Tトークンコーパスに対しても、わずか11.7%のトークンでトレーニングされたMobileLLM-R1-950Mは、複数の推論ベンチマークで競争力を持つ。研究の詳細な情報は公開されている。 Comment

元ポスト:

モデルカードを見ると、optimizerやスケジューリング、ハイパーパラメータの設定、pre/mid/post trainingにおける学習データとDavaMixについて簡潔に記述されており、レシピが公開されているように見える。素晴らしい。

#Pocket #NLP #Dataset #LanguageModel #Evaluation #Coding #read-later #Contamination-free #Live Issue Date: 2025-09-12 [Paper Note] LiveCodeBench: Holistic and Contamination Free Evaluation of Large Language Models for Code, Naman Jain+, ICLR'25 GPT Summary- 本研究では、LLMのコード関連能力を評価するための新しいベンチマーク「LiveCodeBench」を提案。LeetCode、AtCoder、CodeForcesから収集した400の高品質なコーディング問題を用い、コード生成や自己修復、コード実行など多様な能力に焦点を当てている。18のベースLLMと34の指示調整されたLLMを評価し、汚染や過剰適合の問題を実証的に分析。すべてのプロンプトとモデルの結果を公開し、さらなる分析や新しいシナリオの追加を可能にするツールキットも提供。 Comment

pj page: https://livecodebench.github.io

openreview: https://openreview.net/forum?id=chfJJYC3iL

LiveCodeBenchは非常にpopularなコーディング関連のベンチマークだが、readmeに記載されているコマンド通りにベンチマークを実行すると、stop tokenに"###"が指定されているため、マークダウンを出力したLLMの出力が常にtruncateされるというバグがあった模様。

#Pocket #NLP #LanguageModel #Transformer #Attention #NeurIPS #AttentionSinks #read-later Issue Date: 2025-09-11 [Paper Note] Gated Attention for Large Language Models: Non-linearity, Sparsity, and Attention-Sink-Free, Zihan Qiu+, NeurIPS'25 Best Paper GPT Summary- ゲーティングメカニズムの効果を調査するため、強化されたソフトマックスアテンションのバリアントを実験。15B Mixture-of-Expertsモデルと1.7B密なモデルを比較し、シグモイドゲートの適用が性能向上に寄与することを発見。これにより訓練の安定性が向上し、スケーリング特性も改善。スパースゲーティングメカニズムが「アテンションシンク」を軽減し、長いコンテキストの外挿性能を向上させることを示した。関連コードとモデルも公開。 Comment

元ポスト:

所見:

NeurIPS'25 Best Paper:

#EfficiencyImprovement #Pocket #NLP #LanguageModel #LongSequence #Architecture #MoE(Mixture-of-Experts) #read-later Issue Date: 2025-09-08 [Paper Note] SpikingBrain Technical Report: Spiking Brain-inspired Large Models, Yuqi Pan+, arXiv'25 GPT Summary- SpikingBrainは、長いコンテキストの効率的なトレーニングと推論のために設計された脳にインスパイアされたモデルで、MetaX GPUクラスターを活用。線形およびハイブリッド線形アーキテクチャを採用し、非NVIDIAプラットフォーム上での大規模LLM開発を実現。SpikingBrain-7BとSpikingBrain-76Bを開発し、約150BトークンでオープンソースのTransformerと同等の性能を達成。トレーニング効率を大幅に改善し、低消費電力での運用を可能にすることを示した。 Comment

元ポスト:

TTFTが4Mコンテキストの時にQwen2.5と比べて100倍高速化…?

中国のMetaX社のGPUが利用されている。

https://www.metax-tech.com/en/goods/prod.html?cid=3

#EfficiencyImprovement #Pocket #NLP #LanguageModel #RAG(RetrievalAugmentedGeneration) #LongSequence #Decoding #read-later #SpeculativeDecoding Issue Date: 2025-09-07 [Paper Note] REFRAG: Rethinking RAG based Decoding, Xiaoqiang Lin+, arXiv'25 GPT Summary- REFRAGは、RAGアプリケーションにおける遅延を改善するための効率的なデコーディングフレームワークであり、スパース構造を利用して初回トークンまでの時間を30.85倍加速します。これにより、LLMsのコンテキストサイズを16まで拡張可能にし、さまざまな長コンテキストタスクで精度を損なうことなくスピードアップを実現しました。 Comment

元ポスト:

興味深い。Speculative Decodingの新手法ともみなせそう。

同時期に出た下記研究と比較してどのようなpros/consがあるだろうか?

- [Paper Note] Set Block Decoding is a Language Model Inference Accelerator, Itai Gat+, arXiv'25

解説:

#Pocket #NLP #Dataset #LanguageModel #AIAgents #Evaluation #Coding #SoftwareEngineering #read-later #Contamination-free #Live Issue Date: 2025-09-06 [Paper Note] SWE-rebench: An Automated Pipeline for Task Collection and Decontaminated Evaluation of Software Engineering Agents, Ibragim Badertdinov+, arXiv'25 GPT Summary- LLMベースのエージェントのSWEタスクにおける課題として、高品質なトレーニングデータの不足と新鮮なインタラクティブタスクの欠如が挙げられる。これに対処するため、21,000以上のインタラクティブなPythonベースのSWEタスクを含む公的データセットSWE-rebenchを自動化されたパイプラインで構築し、エージェントの強化学習に適したベンチマークを提供。これにより、汚染のない評価が可能となり、いくつかのLLMの性能が過大評価されている可能性を示した。 Comment

pj page: https://swe-rebench.com

元ポスト:

コンタミネーションのない最新のIssueを用いて評価した結果、Sonnet 4が最も高性能

#Pocket #NLP #LanguageModel #Evaluation #Reasoning #read-later #InstructionFollowingCapability Issue Date: 2025-09-05 [Paper Note] Inverse IFEval: Can LLMs Unlearn Stubborn Training Conventions to Follow Real Instructions?, Qinyan Zhang+, arXiv'25 GPT Summary- 大規模言語モデル(LLMs)は、標準化されたパターンに従うことに苦労することがある。これを評価するために、Inverse IFEvalというベンチマークを提案し、モデルが対立する指示に従う能力を測定する。8種類の課題を含むデータセットを構築し、既存のLLMに対する実験を行った結果、非従来の文脈での適応性も考慮すべきであることが示された。Inverse IFEvalは、LLMの指示遵守の信頼性向上に寄与することが期待される。 Comment

元ポスト:

興味深い

#Analysis #Pretraining #Pocket #NLP #LanguageModel #Optimizer #read-later Issue Date: 2025-09-03 [Paper Note] Fantastic Pretraining Optimizers and Where to Find Them, Kaiyue Wen+, arXiv'25 GPT Summary- AdamWは言語モデルの事前学習で広く使用されているオプティマイザですが、代替オプティマイザが1.4倍から2倍のスピードアップを提供するという主張には二つの欠点があると指摘。これらは不均等なハイパーパラメータ調整と誤解を招く評価設定であり、10種類のオプティマイザを系統的に研究することで、公正な比較の重要性を示した。特に、最適なハイパーパラメータはオプティマイザごとに異なり、モデルサイズが大きくなるにつれてスピードアップ効果が減少することが明らかになった。最も高速なオプティマイザは行列ベースの前処理器を使用しているが、その効果はモデルスケールに反比例する。 Comment

元ポスト:

重要そうに見える

関連:

- [Paper Note] Muon is Scalable for LLM Training, Jingyuan Liu+, arXiv'25

- [Paper Note] SOAP: Improving and Stabilizing Shampoo using Adam, Nikhil Vyas+, ICLR'25

著者ポスト:

-

-

考察:

#Pocket #Dataset #LanguageModel #Evaluation #SpeechProcessing #read-later #AudioLanguageModel Issue Date: 2025-09-03 [Paper Note] AHELM: A Holistic Evaluation of Audio-Language Models, Tony Lee+, arXiv'25 GPT Summary- 音声言語モデル(ALMs)の評価には標準化されたベンチマークが欠如しており、これを解決するためにAHELMを導入。AHELMは、ALMsの多様な能力を包括的に測定するための新しいデータセットを集約し、10の重要な評価側面を特定。プロンプトや評価指標を標準化し、14のALMsをテストした結果、Gemini 2.5 Proが5つの側面でトップにランクされる一方、他のモデルは不公平性を示さなかった。AHELMは今後も新しいデータセットやモデルを追加予定。 Comment

元ポスト:

関連:

- Holistic Evaluation of Language Models, Percy Liang+, TMLR'23

#Pocket #NLP #Dataset #LanguageModel #Evaluation #read-later #DeepResearch #Science #Live Issue Date: 2025-08-31 [Paper Note] DeepScholar-Bench: A Live Benchmark and Automated Evaluation for Generative Research Synthesis, Liana Patel+, arXiv'25 GPT Summary- 生成的研究合成の評価のために、DeepScholar-benchというライブベンチマークと自動評価フレームワークを提案。これは、ArXiv論文からクエリを引き出し、関連研究セクションを生成する実際のタスクに焦点を当て、知識合成、検索品質、検証可能性を評価。DeepScholar-baseは強力なベースラインを確立し、他の手法と比較して競争力のあるパフォーマンスを示した。DeepScholar-benchは依然として難易度が高く、生成的研究合成のAIシステムの進歩に重要であることを示す。 Comment

leaderboard: https://guestrin-lab.github.io/deepscholar-leaderboard/leaderboard/deepscholar_bench_leaderboard.html

元ポスト:

#Pocket #NLP #LanguageModel #In-ContextLearning #Reasoning #LongSequence #EMNLP #read-later #Contamination-free #Game Issue Date: 2025-08-30 [Paper Note] TurnaboutLLM: A Deductive Reasoning Benchmark from Detective Games, Yuan Yuan+, EMNLP'25 GPT Summary- TurnaboutLLMという新しいフレームワークとデータセットを用いて、探偵ゲームのインタラクティブなプレイを通じてLLMsの演繹的推論能力を評価。証言と証拠の矛盾を特定する課題を設定し、12の最先端LLMを評価した結果、文脈のサイズや推論ステップ数がパフォーマンスに影響を与えることが示された。TurnaboutLLMは、複雑な物語環境におけるLLMsの推論能力に挑戦を提供する。 Comment

元ポスト:

非常に面白そう。逆転裁判のデータを利用した超long contextな演繹的タスクにおいて、モデルが最終的な回答を間違える際はより多くの正解には貢献しないReasoning Stepを繰り返したり、QwQ-32BとGPT4.1は同等の性能だが、non thinkingモデルであるGPT4.1がより少量のReasoning Step (本研究では回答に至るまでに出力したトークン数と定義)で回答に到達し(=Test Time Scalingの恩恵がない)、フルコンテキストを与えて性能が向上したのはモデルサイズが大きい場合のみ(=Test Timeのreasoningよりも、in-contextでのreasoningが重要)だった、といった知見がある模様。じっくり読みたい。

#Analysis #Pretraining #Pocket #NLP #LanguageModel #Regularization Issue Date: 2025-08-30 [Paper Note] Drop Dropout on Single-Epoch Language Model Pretraining, Houjun Liu+, arXiv'25 GPT Summary- ドロップアウトは過学習を防ぐ手法として知られているが、現代の大規模言語モデル(LLM)では過学習が抑えられるため使用されていない。本研究では、BERTやPythiaモデルの単一エポック事前学習においてドロップアウトの影響を調査した結果、ドロップアウトを適用しない方が下流の性能が向上することが判明。また、「早期ドロップアウト」も性能を低下させることが示された。ドロップアウトなしで訓練されたモデルは、モデル編集においてもより成功することがわかり、単一エポックの事前学習中にはドロップアウトを省くことが推奨される。 Comment

元ポスト:

関連:

- [Paper Note] Dropout Reduces Underfitting, Zhuang Liu+, ICML'23

#Pocket #NLP #Dataset #LanguageModel #Evaluation #read-later #Verification Issue Date: 2025-08-28 [Paper Note] UQ: Assessing Language Models on Unsolved Questions, Fan Nie+, arXiv'25 GPT Summary- 本研究では、AIモデルの評価のために、未解決の質問に基づく新しいベンチマーク「UQ」を提案します。UQは、Stack Exchangeから収集した500の多様な質問を含み、難易度と現実性を兼ね備えています。評価には、ルールベースのフィルター、LLM審査員、人間のレビューを組み合わせたデータセット収集パイプライン、生成者-バリデーターのギャップを活用した複合バリデーション戦略、専門家による共同検証プラットフォームが含まれます。UQは、最前線のモデルが人間の知識を拡張するための現実的な課題を評価する手段を提供します。 Comment

元ポスト:

-

-

ポイント解説:

Figure1を見るとコンセプトが非常にわかりやすい。現在のLLMが苦戦しているベンチマークは人間が回答済み、かつ実世界のニーズに反して意図的に作られた高難易度なデータ(現実的な設定では無い)であり、現実的では無いが難易度が高い。一方で、現実にニーズがあるデータでベンチマークを作るとそれらはしばしば簡単すぎたり、ハッキング可能だったりする。

このため、現実的な設定でニーズがあり、かつ難易度が高いベンチマークが不足しており、これを解決するためにそもそも人間がまだ回答していない未解決の問題に着目し、ベンチマークを作りました、という話に見える。

元ポストを咀嚼すると、

未解決な問題ということはReferenceが存在しないということなので、この点が課題となる。このため、UQ-ValidatorとUQ-Platformを導入する。

UQ-Validatorは複数のLLMのパイプラインで形成され、回答候補のpre-screeningを実施する。回答を生成したLLM自身(あるいは同じモデルファミリー)がValidatorに加わることで自身の回答をoverrateする問題が生じるが、複数LLMのパイプラインを組むことでそのバイアスを軽減できる、とのこと。また、しばしば回答を生成するよりも結果をValidationせる方がタスクとして簡単であり、必ずしも適切に回答する能力はValidatorには必要ないという直感に基づいている。たとえば、Claudeは回答性能は低くてもValidatorとしてはうまく機能する。また、Validatorは転移が効き、他データセットで訓練したものを未解決の回答にも適用できる。test-timeのスケーリングもある程度作用する。

続いて、UQ-Platformにおいて、回答とValidatorの出力を見ながら、専門家の支援に基づいて回答評価し、また、そもそもの質問の質などについてコメントするなどして未解決の問題の解決を支援できる。

みたいな話らしい。非常に重要な研究に見える。

#Pretraining #Pocket #NLP #Dataset #LanguageModel #Reasoning #Mathematics #read-later Issue Date: 2025-08-27 [Paper Note] Nemotron-CC-Math: A 133 Billion-Token-Scale High Quality Math Pretraining Dataset, Rabeeh Karimi Mahabadi+, arXiv'25 GPT Summary- 新しい数学コーパス「Nemotron-CC-Math」を提案し、LLMの推論能力を向上させるために、科学テキスト抽出のためのパイプラインを使用。従来のデータセットよりも高品質で、方程式やコードの構造を保持しつつ、表記を標準化。Nemotron-CC-Math-4+は、以前のデータセットを大幅に上回り、事前学習によりMATHやMBPP+での性能向上を実現。オープンソースとしてコードとデータセットを公開。 Comment

元ポスト:

#ComputerVision #Pocket #NLP #LanguageModel #OpenWeight #read-later #VisionLanguageModel Issue Date: 2025-08-26 [Paper Note] InternVL3.5: Advancing Open-Source Multimodal Models in Versatility, Reasoning, and Efficiency, Weiyun Wang+, arXiv'25 GPT Summary- InternVL 3.5は、マルチモーダルモデルの新しいオープンソースファミリーで、Cascade Reinforcement Learningを用いて推論能力と効率を向上させる。粗から細へのトレーニング戦略により、MMMやMathVistaなどのタスクで大幅な改善を実現。Visual Resolution Routerを導入し、視覚トークンの解像度を動的に調整。Decoupled Vision-Language Deployment戦略により、計算負荷をバランスさせ、推論性能を最大16.0%向上させ、速度を4.05倍向上。最大モデルは、オープンソースのMLLMで最先端の結果を達成し、商業モデルとの性能ギャップを縮小。全てのモデルとコードは公開。 Comment

元ポスト:

ポイント解説:

#Pretraining #Pocket #NLP #LanguageModel #Alignment #Supervised-FineTuning (SFT) #OpenWeight #Architecture #PostTraining #DataMixture Issue Date: 2025-08-25 [Paper Note] Motif 2.6B Technical Report, Junghwan Lim+, arXiv'25 GPT Summary- Motif-2.6Bは、26億パラメータを持つ基盤LLMで、長文理解の向上や幻覚の減少を目指し、差分注意やポリノルム活性化関数を採用。広範な実験により、同サイズの最先端モデルを上回る性能を示し、効率的でスケーラブルな基盤LLMの発展に寄与する。 Comment

元ポスト:

HF: https://huggingface.co/Motif-Technologies/Motif-2.6B

- アーキテクチャ

- Differential Transformer, Tianzhu Ye+, N/A, ICLR'25

- [Paper Note] Polynomial Composition Activations: Unleashing the Dynamics of Large

Language Models, Zhijian Zhuo+, arXiv'24

- 学習手法

- Model Merging in Pre-training of Large Language Models, Yunshui Li+, arXiv'25

- 8B token学習するごとに直近6つのcheckpointのelement-wiseの平均をとりモデルマージ。当該モデルに対して学習を継続、ということを繰り返す。これにより、学習のノイズを低減し、突然パラメータがシフトすることを防ぐ

- Effective Long-Context Scaling of Foundation Models, Wenhan Xiong+, N/A, NAACL'24

- Adaptive Base Frequency (RoPEのbase frequencyを10000から500000にすることでlong contextのattention scoreが小さくなりすぎることを防ぐ)

- [Paper Note] MiniCPM: Unveiling the Potential of Small Language Models with Scalable

Training Strategies, Shengding Hu+, arXiv'24

- 事前学習データ

- DataComp-LM: In search of the next generation of training sets for

language models, Jeffrey Li+, arXiv'24

- TxT360, LLM360, 2024.10

- [Paper Note] FineWeb2: One Pipeline to Scale Them All -- Adapting Pre-Training Data Processing to Every Language, Guilherme Penedo+, COLM'25

を利用したモデル。同程度のサイズのモデルとの比較ではかなりのgainを得ているように見える。興味深い。

DatasetのMixtureの比率などについても記述されている。https://github.com/user-attachments/assets/0a26442e-8075-4cbe-8cc1-f1ff471b7356"

/>

#Pocket #NLP #LanguageModel #Decoding #read-later #MajorityVoting Issue Date: 2025-08-24 [Paper Note] Deep Think with Confidence, Yichao Fu+, arXiv'25 GPT Summary- 「Deep Think with Confidence(DeepConf)」は、LLMの推論タスクにおける精度と計算コストの課題を解決する手法で、モデル内部の信頼性信号を活用して低品質な推論を動的にフィルタリングします。追加の訓練や調整を必要とせず、既存のフレームワークに統合可能です。評価の結果、特に難易度の高いAIME 2025ベンチマークで99.9%の精度を達成し、生成トークンを最大84.7%削減しました。 Comment

pj page:

https://jiaweizzhao.github.io/deepconf

vLLMでの実装:

https://jiaweizzhao.github.io/deepconf/static/htmls/code_example.html

元ポスト:

tooluse、追加の訓練なしで、どのようなタスクにも適用でき、85%生成トークン量を減らした上で、OpenModelで初めてAIME2025において99% Acc.を達成した手法とのこと。vLLMを用いて50 line程度で実装できるらしい。

reasoning traceのconfidence(i.e., 対数尤度)をgroup sizeを決めてwindow単位で決定し、それらをデコーディングのプロセスで活用することで、品質の低いreasoning traceに基づく結果を排除しつつ、majority votingに活用する方法。直感的にもうまくいきそう。オフラインとオンラインの推論によって活用方法が提案されている。あとでしっかり読んで書く。Confidenceの定義の仕方はグループごとのbottom 10%、tailなどさまざまな定義方法と、それらに基づいたconfidenceによるvotingの重み付けが複数考えられ、オフライン、オンラインによって使い分ける模様。

vLLMにPRも出ている模様?

#ComputerVision #Pocket #NLP #Dataset #AIAgents #Evaluation #Factuality #read-later Issue Date: 2025-08-22 [Paper Note] MM-BrowseComp: A Comprehensive Benchmark for Multimodal Browsing Agents, Shilong Li+, arXiv'25 GPT Summary- MM-BrowseCompは、AIエージェントのマルチモーダル検索および推論能力を評価する新しいベンチマークで、224の手作りの質問を含む。これにより、画像や動画を含む情報の重要性を考慮し、テキストのみの手法の限界を示す。最先端モデルの評価では、OpenAI o3などのトップモデルでも29.02%の精度にとどまり、マルチモーダル能力の最適化不足が明らかになった。 Comment

元ポスト:

#MachineTranslation #NLP #LanguageModel #Supervised-FineTuning (SFT) #SmallModel #Japanese #DPO #ModelMerge Issue Date: 2025-08-22 PLaMo Translate: 翻訳特化大規模言語モデルの開発,今城+, Jxiv'25 Comment

元ポスト:

SFT->Iterative DPO->Model Mergeのパイプライン。SFTでは青空文庫などのオープンなデータから指示追従性能の高いDeepSeek-V3-0324によって元データ→翻訳, 翻訳→再翻訳データを合成し活用。また、翻訳の指示がprompt中に存在せずとも(本モデルを利用するのは翻訳用途であることが自明であるからと推察される)翻訳を適切に実行できるよう、独自のテンプレートを学習。文体指定、常体、敬体の指定、文脈考慮、語彙指定それぞれにういて独自のタグを設けてフォーマットを形成し翻訳に特化したテンプレートを学習。

IterativeDPOでは、DeepSeekV3に基づくLLM-as-a-Judgeと、MetricX([Paper Note] MetricX-24: The Google Submission to the WMT 2024 Metrics Shared Task, Juraj Juraska+, arXiv'24

)に基づいてReward Modelをそれぞれ学習し、1つの入力に対して100個の翻訳を作成しそれぞれのRewardモデルのスコアの合計値に基づいてRejection Samplingを実施することでPreference dataを構築。3段階のDPOを実施し、段階ごとにRewardモデルのスコアに基づいて高品質なPreference Dataに絞ることで性能向上を実現。

モデルマージではDPOの各段階のモデルを重み付きでマージすることで各段階での長所を組み合わせたとのこと。

2025.1010配信の「岡野原大輔のランチタイムトーク Vol.52 番外編「なぜPLaMo翻訳は自然なのか?」において詳細が語られているので参照のこと。特になぜ日本語に強いLLMが大事なのか?という話が非常におもしろかった。

#Pretraining #Pocket #NLP #Dataset #LanguageModel #SmallModel #OpenWeight #SSM (StateSpaceModel) Issue Date: 2025-08-19 [Paper Note] NVIDIA Nemotron Nano 2: An Accurate and Efficient Hybrid Mamba-Transformer Reasoning Model, NVIDIA+, arXiv'25, 2025.08 GPT Summary- Nemotron-Nano-9B-v2は、推論スループットを向上させつつ最先端の精度を達成するハイブリッドMamba-Transformerモデルである。自己注意層の一部をMamba-2層に置き換え、長い思考トレースの生成を高速化。12億パラメータのモデルを20兆トークンで事前トレーニングし、Minitron戦略で圧縮・蒸留。既存モデルと比較して、最大6倍の推論スループットを実現し、精度も同等以上。モデルのチェックポイントはHugging Faceで公開予定。 Comment

元ポスト:

事前学習に利用されたデータも公開されているとのこと(Nemotron-CC):

解説:

サマリ:

#Pocket #NLP #Dataset #LanguageModel #AIAgents #Evaluation #read-later #CrossDomain #Live Issue Date: 2025-08-18 [Paper Note] xbench: Tracking Agents Productivity Scaling with Profession-Aligned Real-World Evaluations, Kaiyuan Chen+, arXiv'25 GPT Summary- 「xbench」は、AIエージェントの能力と実世界の生産性のギャップを埋めるために設計された動的な評価スイートで、業界専門家が定義したタスクを用いて商業的に重要なドメインをターゲットにしています。リクルートメントとマーケティングの2つのベンチマークを提示し、エージェントの能力を評価するための基準を確立します。評価結果は継続的に更新され、https://xbench.org で入手可能です。 #Pocket #NLP #Dataset #LanguageModel #AIAgents #Evaluation #read-later Issue Date: 2025-08-16 [Paper Note] BrowseComp: A Simple Yet Challenging Benchmark for Browsing Agents, Jason Wei+, arXiv'25 GPT Summary- BrowseCompは、エージェントのウェブブラウジング能力を測定するための1,266の質問からなるベンチマークで、絡み合った情報を探すことを要求します。シンプルで使いやすく、短い回答が求められ、参照回答との照合が容易です。このベンチマークは、ブラウジングエージェントの能力を評価するための重要なツールであり、持続力と創造性を測定します。詳細はGitHubで入手可能です。 #Pocket #NLP #LanguageModel #AIAgents #ComputerUse #read-later #VisionLanguageModel Issue Date: 2025-08-15 [Paper Note] OpenCUA: Open Foundations for Computer-Use Agents, Xinyuan Wang+, arXiv'25 GPT Summary- OpenCUAは、CUAデータと基盤モデルをスケールさせるためのオープンソースフレームワークであり、アノテーションインフラ、AgentNetデータセット、反射的なChain-of-Thought推論を持つスケーラブルなパイプラインを提供。OpenCUA-32Bは、CUAベンチマークで34.8%の成功率を達成し、最先端の性能を示す。研究コミュニティのために、アノテーションツールやデータセットを公開。 Comment

元ポスト:

著者ポスト:

CUAにおいてProprietaryモデルに近い性能を達成した初めての研究な模様。重要

続報: