Grokking

[Paper Note] RL Grokking Recipe: How Does RL Unlock and Transfer New Algorithms in LLMs?, Yiyou Sun+, arXiv'25, 2025.09

Paper/Blog Link My Issue

#Analysis #NLP #LanguageModel #ReinforcementLearning #PostTraining #RLVR Issue Date: 2025-12-09 GPT Summary- DELTA-Codeを導入し、LLMの学習可能性と移転可能性を評価する。合成コーディング問題を用いて、RL訓練されたモデルが新しい推論戦略を獲得できるかを探る。実験では、報酬がほぼゼロの後に急激な精度向上が見られ、段階的ウォームアップやカリキュラムトレーニングが重要であることが示された。移転可能性の評価では、ファミリー内での向上が見られる一方、変革的なケースでは弱点が残る。DELTAは新しいアルゴリズムスキルの獲得を理解するためのテストベッドを提供する。

[Paper Note] Provable Scaling Laws of Feature Emergence from Learning Dynamics of Grokking, Yuandong Tian, arXiv'25, 2025.09

Paper/Blog Link My Issue

#NeuralNetwork #Analysis #MachineLearning #Optimizer Issue Date: 2025-10-10 GPT Summary- grokkingの現象を理解するために、2層の非線形ネットワークにおける新しい枠組み$\mathbf{Li_2}$を提案。これには、怠惰な学習、独立した特徴学習、相互作用する特徴学習の3段階が含まれる。怠惰な学習では、モデルが隠れ表現に過剰適合し、独立した特徴が学習される。後半段階では、隠れノードが相互作用を始め、学習すべき特徴に焦点を当てることが示される。本研究は、grokkingにおけるハイパーパラメータの役割を明らかにし、特徴の出現と一般化に関するスケーリング法則を導出する。 Comment

元ポスト:

Why Do You Grok? A Theoretical Analysis of Grokking Modular Addition, Mohamad Amin Mohamadi+, arXiv'24

Paper/Blog Link My Issue

Issue Date: 2024-11-13 GPT Summary- モデルの「grokking」現象を理論的に説明し、モジュラー加算問題に関連付ける。勾配降下法の初期段階では、順列不変モデルが小さな母集団誤差を達成するために一定割合のデータポイントを観察する必要があるが、最終的にはカーネル領域を脱出する。二層の二次ネットワークが限られたトレーニングポイントでゼロのトレーニング損失を達成し、良好に一般化することを示し、実証的証拠も提供。これにより、grokkingは深層ネットワークにおける勾配降下法の制限挙動への移行の結果であることが支持される。

Explaining grokking through circuit efficiency, Vikrant Varma+, N_A, arXiv'23

Paper/Blog Link My Issue

#NeuralNetwork #MachineLearning Issue Date: 2023-09-30 GPT Summary- グロッキングとは、完璧なトレーニング精度を持つネットワークでも一般化が悪い現象のことである。この現象は、タスクが一般化する解と記憶する解の両方を許容する場合に起こると考えられている。一般化する解は学習が遅く、効率的であり、同じパラメータノルムでより大きなロジットを生成する。一方、記憶回路はトレーニングデータセットが大きくなるにつれて非効率になるが、一般化回路はそうではないと仮説が立てられている。これは、記憶と一般化が同じくらい効率的な臨界データセットサイズが存在することを示唆している。さらに、グロッキングに関して4つの新しい予測が立てられ、それらが確認され、説明が支持される重要な証拠が提供されている。また、グロッキング以外の2つの新しい現象も示されており、それはアングロッキングとセミグロッキングである。アングロッキングは完璧なテスト精度から低いテスト精度に逆戻りする現象であり、セミグロッキングは完璧なテスト精度ではなく部分的なテスト精度への遅れた一般化を示す現象である。 Comment

Grokkingがいつ、なぜ発生するかを説明する理論を示した研究。

理由としては、最初はmemorizationを学習していくのだが、ある時点から一般化回路であるGenに切り替わる。これが切り替わる理由としては、memorizationよりも、genの方がlossが小さくなるから、とのこと。これはより大規模なデータセットで顕著。

Grokkingが最初に報告された研究は [Paper Note] Grokking: Generalization Beyond Overfitting on Small Algorithmic Datasets, Alethea Power+, ICLR'21 Workshop, 2022.01

[Paper Note] Grokking: Generalization Beyond Overfitting on Small Algorithmic Datasets, Alethea Power+, ICLR'21 Workshop, 2022.01

Paper/Blog Link My Issue

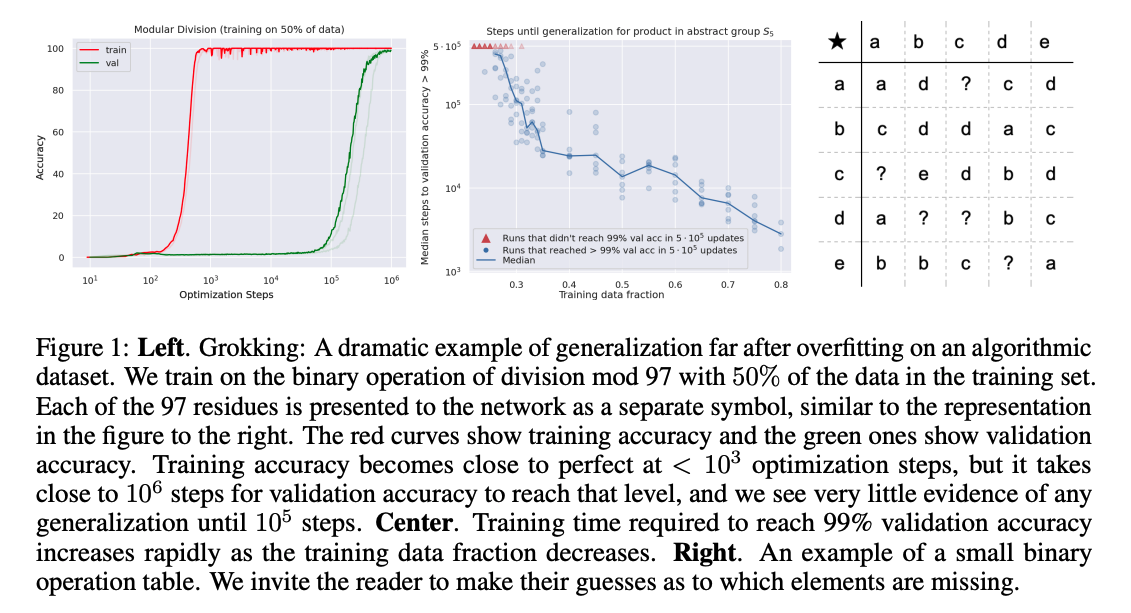

#NeuralNetwork #MachineLearning #ICLR #Workshop #One-Line Notes Issue Date: 2023-04-25 GPT Summary- 小規模データセットにおけるニューラルネットワークの一般化を探求。データ効率、記憶、一般化、学習速度に関する問題を分析し、学習過程の「グロッキング」を通じて一般化性能の改善を示す。特に、小さなデータセットではより多くの最適化が必要であることが明らかにされ、過剰パラメータ化されたネットワークの一般化メカニズムを理解するための重要な知見を提供。 Comment

学習後すぐに学習データをmemorizeして、汎化能力が無くなったと思いきや、10^3ステップ後に突然汎化するという現象(Grokking)を報告

学習データが小さければ小さいほど汎化能力を獲得するのに時間がかかる模様