Zero/FewShotPrompting

#ComputerVision

#Pocket

#NLP

#Dataset

#LanguageModel

#MulltiModal

#In-ContextLearning

Issue Date: 2025-07-01 [Paper Note] SMMILE: An Expert-Driven Benchmark for Multimodal Medical In-Context Learning, Melanie Rieff+, arXiv'25 Summaryマルチモーダルインコンテキスト学習(ICL)は医療分野での可能性があるが、十分に探求されていない。SMMILEという医療タスク向けの初のマルチモーダルICLベンチマークを導入し、111の問題を含む。15のMLLMの評価で、医療タスクにおけるICL能力が中程度から低いことが示された。ICLはSMMILEで平均8%、SMMILE++で9.4%の改善をもたらし、無関係な例がパフォーマンスを最大9.5%低下させることも確認。例の順序による最近性バイアスがパフォーマンス向上に寄与することも明らかになった。 Comment元ポスト:https://x.com/michael_d_moor/status/1939664155813839114?s=46&t=Y6UuIHB0Lv0IpmFAjlc2-Q #Pocket #NLP #QuestionAnswering #Chain-of-Thought #RAG(RetrievalAugmentedGeneration) #Reasoning

Issue Date: 2025-01-03 AutoReason: Automatic Few-Shot Reasoning Decomposition, Arda Sevinc+, arXiv'24 SummaryChain of Thought(CoT)を用いて、暗黙のクエリを明示的な質問に分解することで、LLMの推論能力を向上させる自動生成システムを提案。StrategyQAとHotpotQAデータセットで精度向上を確認し、特にStrategyQAで顕著な成果を得た。ソースコードはGitHubで公開。 Comment元ポスト:https://x.com/dair_ai/status/1868299926897074309?s=46&t=Y6UuIHB0Lv0IpmFAjlc2-Q #ComputerVision #Pocket #LanguageModel #Self-SupervisedLearning

Issue Date: 2024-10-07 SINC: Self-Supervised In-Context Learning for Vision-Language Tasks, Yi-Syuan Chen+, N_A, ICCV'23 Summary自己教師あり文脈内学習(SINC)フレームワークを提案し、大規模言語モデルに依存せずに文脈内学習を実現。特別に調整されたデモンストレーションを用いたメタモデルが、視覚と言語のタスクで少数ショット設定において勾配ベースの手法を上回る性能を示す。SINCは文脈内学習の利点を探求し、重要な要素を明らかにする。

Issue Date: 2025-07-01 [Paper Note] SMMILE: An Expert-Driven Benchmark for Multimodal Medical In-Context Learning, Melanie Rieff+, arXiv'25 Summaryマルチモーダルインコンテキスト学習(ICL)は医療分野での可能性があるが、十分に探求されていない。SMMILEという医療タスク向けの初のマルチモーダルICLベンチマークを導入し、111の問題を含む。15のMLLMの評価で、医療タスクにおけるICL能力が中程度から低いことが示された。ICLはSMMILEで平均8%、SMMILE++で9.4%の改善をもたらし、無関係な例がパフォーマンスを最大9.5%低下させることも確認。例の順序による最近性バイアスがパフォーマンス向上に寄与することも明らかになった。 Comment元ポスト:https://x.com/michael_d_moor/status/1939664155813839114?s=46&t=Y6UuIHB0Lv0IpmFAjlc2-Q #Pocket #NLP #QuestionAnswering #Chain-of-Thought #RAG(RetrievalAugmentedGeneration) #Reasoning

Issue Date: 2025-01-03 AutoReason: Automatic Few-Shot Reasoning Decomposition, Arda Sevinc+, arXiv'24 SummaryChain of Thought(CoT)を用いて、暗黙のクエリを明示的な質問に分解することで、LLMの推論能力を向上させる自動生成システムを提案。StrategyQAとHotpotQAデータセットで精度向上を確認し、特にStrategyQAで顕著な成果を得た。ソースコードはGitHubで公開。 Comment元ポスト:https://x.com/dair_ai/status/1868299926897074309?s=46&t=Y6UuIHB0Lv0IpmFAjlc2-Q #ComputerVision #Pocket #LanguageModel #Self-SupervisedLearning

Issue Date: 2024-10-07 SINC: Self-Supervised In-Context Learning for Vision-Language Tasks, Yi-Syuan Chen+, N_A, ICCV'23 Summary自己教師あり文脈内学習(SINC)フレームワークを提案し、大規模言語モデルに依存せずに文脈内学習を実現。特別に調整されたデモンストレーションを用いたメタモデルが、視覚と言語のタスクで少数ショット設定において勾配ベースの手法を上回る性能を示す。SINCは文脈内学習の利点を探求し、重要な要素を明らかにする。

#Pocket

#LanguageModel

#MultitaskLearning

#Supervised-FineTuning (SFT)

#CrossLingual

#ACL

#Generalization

Issue Date: 2023-08-16

Crosslingual Generalization through Multitask Finetuning, Niklas Muennighoff+, N_A, ACL'23

Summaryマルチタスクプロンプトフィネチューニング(MTF)は、大規模な言語モデルが新しいタスクに汎化するのに役立つことが示されています。この研究では、マルチリンガルBLOOMとmT5モデルを使用してMTFを実施し、英語のプロンプトを使用して英語および非英語のタスクにフィネチューニングすることで、タスクの汎化が可能であることを示しました。さらに、機械翻訳されたプロンプトを使用してマルチリンガルなタスクにフィネチューニングすることも調査し、モデルのゼロショットの汎化能力を示しました。また、46言語の教師ありデータセットのコンポジットであるxP3も紹介されています。

Comment英語タスクを英語でpromptingしてLLMをFinetuningすると、他の言語(ただし、事前学習で利用したコーパスに出現する言語に限る)で汎化し性能が向上することを示した模様。

#EfficiencyImprovement #MachineLearning #NLP #In-ContextLearning Issue Date: 2023-07-13 FiD-ICL: A Fusion-in-Decoder Approach for Efficient In-Context Learning, ACL'23 Summary大規模な事前学習モデルを使用したfew-shot in-context learning(ICL)において、fusion-in-decoder(FiD)モデルを適用することで効率とパフォーマンスを向上させることができることを検証する。FiD-ICLは他のフュージョン手法と比較して優れたパフォーマンスを示し、推論時間も10倍速くなる。また、FiD-ICLは大規模なメタトレーニングモデルのスケーリングも可能にする。 #Pocket #NLP #LanguageModel #Chain-of-Thought #ACL Issue Date: 2023-05-04 Challenging BIG-Bench Tasks and Whether Chain-of-Thought Can Solve Them, Mirac Suzgun+, N_A, ACL'23 SummaryBIG-Bench Hard (BBH) is a suite of 23 challenging tasks that current language models have not been able to surpass human performance on. This study focuses on applying chain-of-thought prompting to BBH tasks and found that PaLM and Codex were able to surpass human performance on 10 and 17 tasks, respectively. The study also found that CoT prompting is necessary for tasks that require multi-step reasoning and that CoT and model scale interact to enable new task performance on some BBH tasks. Comment単なるfewshotではなく、CoT付きのfewshotをすると大幅にBIG-Bench-hardの性能が向上するので、CoTを使わないanswer onlyの設定はモデルの能力の過小評価につながるよ、という話らしい

#RecommenderSystems

#LanguageModel

#InstructionTuning

Issue Date: 2023-11-12

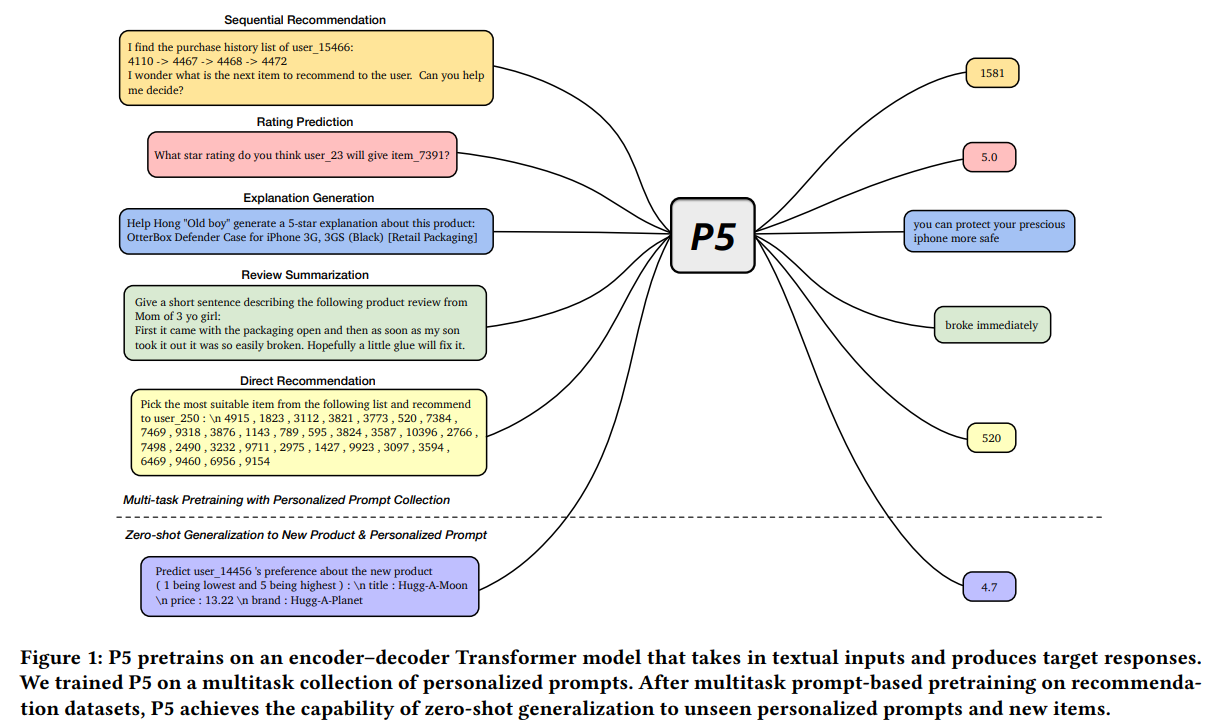

Recommendation as Language Processing (RLP): A Unified Pretrain, Personalized Prompt & Predict Paradigm (P5), Shijie Geng+, N_A, RecSys'22

Summary我々は「Pretrain, Personalized Prompt, and Predict Paradigm」(P5)と呼ばれる柔軟で統一されたテキストからテキストへのパラダイムを提案します。P5は、共有フレームワーク内でさまざまな推薦タスクを統一し、個別化と推薦のための深い意味を捉えることができます。P5は、異なるタスクを学習するための同じ言語モデリング目標を持つ事前学習を行います。P5は、浅いモデルから深いモデルへと進化し、広範な微調整の必要性を減らすことができます。P5の効果を実証するために、いくつかの推薦ベンチマークで実験を行いました。

Comment概要

#RecommenderSystems

#LanguageModel

#InstructionTuning

Issue Date: 2023-11-12

Recommendation as Language Processing (RLP): A Unified Pretrain, Personalized Prompt & Predict Paradigm (P5), Shijie Geng+, N_A, RecSys'22

Summary我々は「Pretrain, Personalized Prompt, and Predict Paradigm」(P5)と呼ばれる柔軟で統一されたテキストからテキストへのパラダイムを提案します。P5は、共有フレームワーク内でさまざまな推薦タスクを統一し、個別化と推薦のための深い意味を捉えることができます。P5は、異なるタスクを学習するための同じ言語モデリング目標を持つ事前学習を行います。P5は、浅いモデルから深いモデルへと進化し、広範な微調整の必要性を減らすことができます。P5の効果を実証するために、いくつかの推薦ベンチマークで実験を行いました。

Comment概要

T5 のように、様々な推薦タスクを、「Prompt + Prediction」のpipelineとして定義して解けるようにした研究。

P5ではencoder-decoder frameworkを採用しており、encoder側ではbidirectionalなモデルでpromptのrepresentationを生成し、auto-regressiveな言語モデルで生成を行う。

推薦で利用したいデータセットから、input-target pairsを生成し上記アーキテクチャに対して事前学習することで、推薦を実現できる。

RatingPredictionでは、MatrixFactorizationに勝てていない(が、Rating Predictionについては魔法の壁問題などもあると思うのでなんともいえない。)

Sequential RecommendationではBERT4Recとかにも勝てている模様。

Prompt例

・Rating Predictionの例

・Sequential Recommendationの例

・Explanationを生成する例

・Zero-shotの例(Cold-Start)

#NeuralNetwork

#NLP

#Chain-of-Thought

#Prompting

#NeurIPS

Issue Date: 2023-04-27

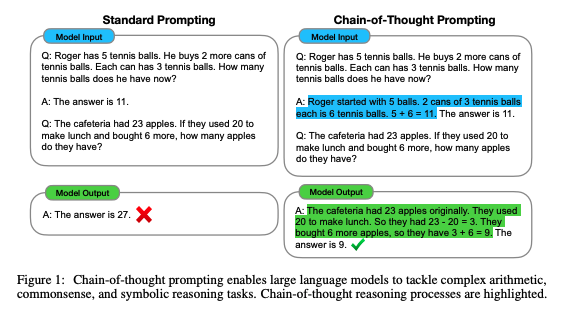

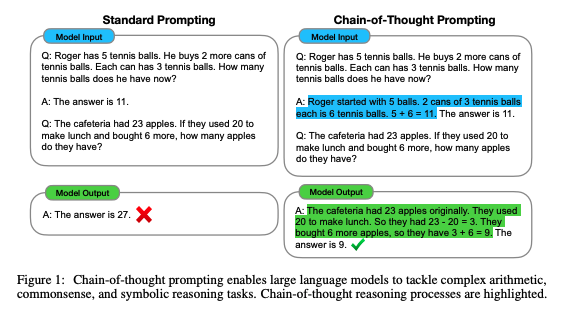

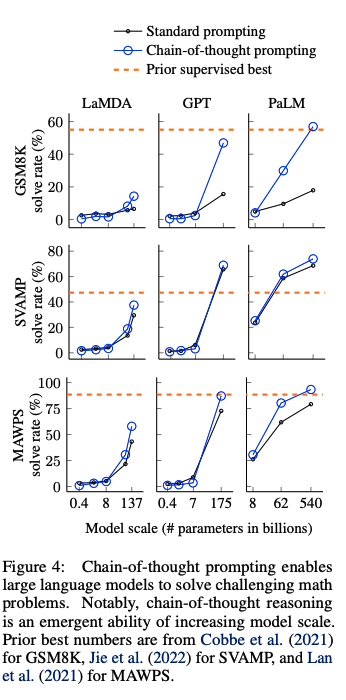

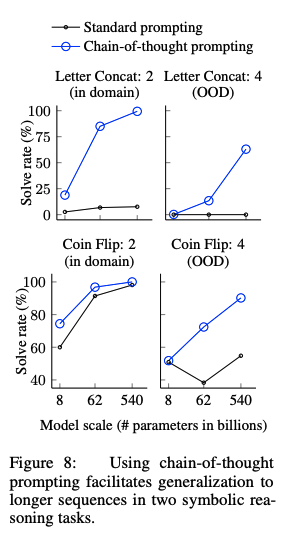

Chain of thought prompting elicits reasoning in large language models, Wei+, Google Research, NeurIPS'22

CommentChain-of-Thoughtを提案した論文。CoTをする上でパラメータ数が100B未満のモデルではあまり効果が発揮されないということは念頭に置いた方が良さそう。

#NeuralNetwork

#NLP

#Chain-of-Thought

#Prompting

#NeurIPS

Issue Date: 2023-04-27

Chain of thought prompting elicits reasoning in large language models, Wei+, Google Research, NeurIPS'22

CommentChain-of-Thoughtを提案した論文。CoTをする上でパラメータ数が100B未満のモデルではあまり効果が発揮されないということは念頭に置いた方が良さそう。

先行研究では、reasoningが必要なタスクの性能が低い問題をintermediate stepを明示的に作成し、pre-trainedモデルをfinetuningすることで解決していた。しかしこの方法では、finetuning用の高品質なrationaleが記述された大規模データを準備するのに多大なコストがかかるという問題があった。

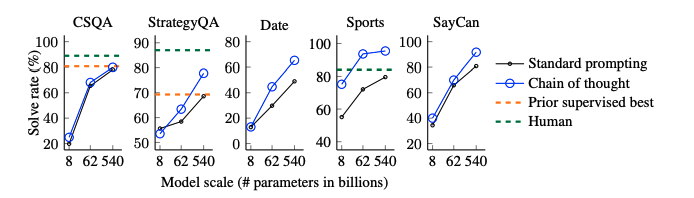

このため、few-shot promptingによってこの問題を解決することが考えられるが、reasoning能力が必要なタスクでは性能が悪いという問題あがった。そこで、両者の強みを組み合わせた手法として、chain-of-thought promptingは提案された。CoTによる実験結果

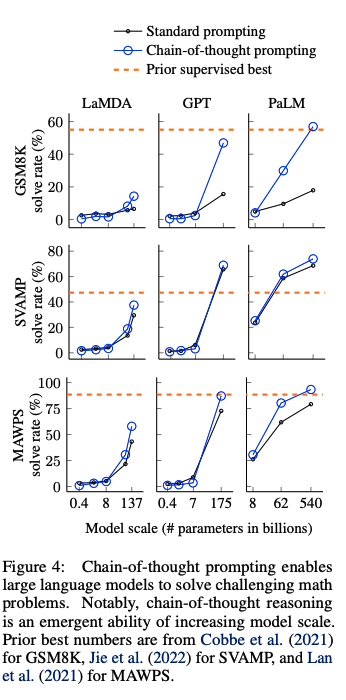

以下のベンチマークを利用

・math word problem: GSM8K, SVAMP, ASDiv, AQuA, MAWPS

・commonsense reasoning: CSQA, StrategyQA, Big-bench Effort (Date, Sports), SayCan

・Symbolic Reasoning: Last Letter concatenation, Coin Flip

・Last Letter concatnation: 名前の単語のlast wordをconcatするタスク("Amy Brown" -> "yn")

・Coin Flip: コインをひっくり返す、 あるいはひっくり返さない動作の記述の後に、コインが表向きであるかどうかをモデルに回答するよう求めるタスク

math word problem benchmark

・モデルのサイズが大きくなるにつれ性能が大きく向上(emergent ability)することがあることがわかる

・言い換えるとCoTは<100Bのモデルではパフォーマンスに対してインパクトを与えない

・モデルサイズが小さいと、誤ったCoTを生成してしまうため

・複雑な問題になればなるほど、CoTによる恩恵が大きい

・ベースラインの性能が最も低かったGSM8Kでは、パフォーマンスの2倍向上しており、1 stepのreasoningで解決できるSingleOpやMAWPSでは、性能の向上幅が小さい

・Task specificなモデルをfinetuningした以前のSoTAと比較してcomparable, あるいはoutperformしている

・

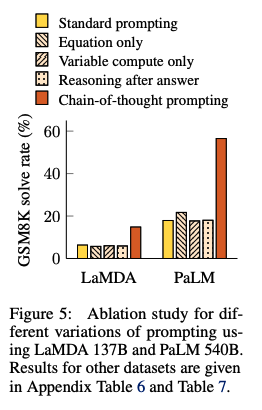

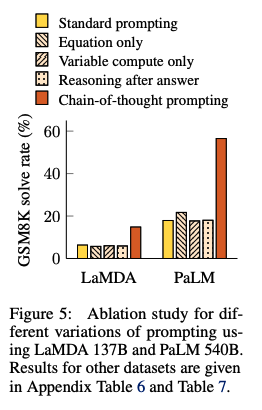

Ablation Study

CoTではなく、他のタイプのpromptingでも同じような効果が得られるのではないか?という疑問に回答するために、3つのpromptingを実施し、CoTと性能比較した:

・Equation Only: 回答するまえに数式を記載するようなprompt

・promptの中に数式が書かれているから性能改善されているのでは?という疑問に対する検証

・=> GSM8Kによる結果を見ると、equation onlyでは性能が低かった。これは、これは数式だけでreasoning stepsを表現できないことに起因している

・Variable compute only: dotのsequence (...) のみのprompt

・CoTは難しい問題に対してより多くの計算(intermediate token)をすることができているからでは?という疑問に対する検証

・variable computationとCoTの影響を分離するために、dotのsequence (...) のみでpromptingする方法を検証

・=> 結果はbaselineと性能変わらず。このことから、variableの計算自体が性能向上に寄与しているわけではないことがわかる。

・Chain of Thought after answer: 回答の後にCoTを出力するようなprompting

・単にpretrainingの際のrelevantな知識にアクセスしやすくなっているだけなのでは?という疑問を検証

・=> baselineと性能は変わらず、単に知識を活性化させるだけでは性能が向上しないことがわかる。

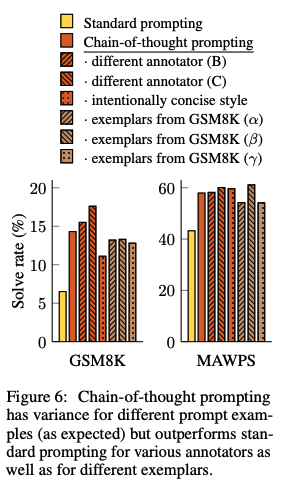

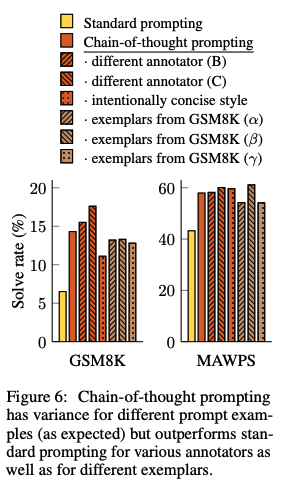

CoTのロバスト性

人間のAnnotatorにCoTを作成させ、それらを利用したCoTpromptingとexamplarベースな手法によって性能がどれだけ変わるかを検証。standard promptingを全ての場合で上回る性能を獲得した。このことから、linguisticなstyleにCoTは影響を受けていないことがわかる。

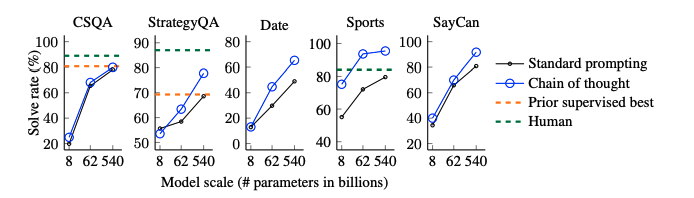

commonsense reasoning

全てのデータセットにおいて、CoTがstandard promptingをoutperformした。

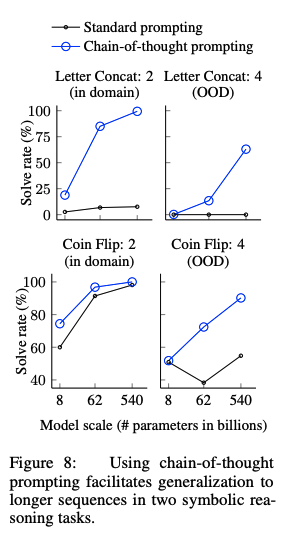

Symbolic Reasoning

in-domain test setとout-of-domain test setの2種類を用意した。前者は必要なreasoning stepがfew-shot examplarと同一のもの、後者は必要なreasoning stepがfew-shot examplarよりも多いものである。

CoTがStandard proimptingを上回っている。特に、standard promptingではOOV test setではモデルをスケールさせても性能が向上しなかったのに対し、CoTではより大きなgainを得ている。このことから、CoTにはreasoning stepのlengthに対しても汎化能力があることがわかる。

#NeuralNetwork #Pocket #NLP #LanguageModel #In-ContextLearning #NeurIPS #Admin'sPick Issue Date: 2023-04-27 Language Models are Few-Shot Learners, Tom B. Brown+, NeurIPS'20 SummaryGPT-3は1750億パラメータを持つ自己回帰型言語モデルで、少数ショット設定においてファインチューニングなしで多くのNLPタスクで強力な性能を示す。翻訳や質問応答などで優れた結果を出し、即時推論やドメイン適応が必要なタスクでも良好な性能を発揮する一方、依然として苦手なデータセットや訓練に関する問題も存在する。また、GPT-3は人間が書いた記事と区別が難しいニュース記事を生成できることが確認され、社会的影響についても議論される。 CommentIn-Context Learningを提案した論文論文に記載されているIn-Context Learningの定義は、しっかり押さえておいた方が良い。

下図はmeta-learningの観点から見たときの、in-contextの位置付け。事前学習時にSGDでパラメータをupdateするのをouter loopとし、そこで広いスキルとパターン認識の能力を身につける。一方で、in-context learningは、Inference時に事前学習時に得たそれらのスキルを用いて、求めるタスクを認識、あるいは適応するInner loopのことを指す。

この上で、論文中では In-Context Learningについて:

> Recent work [RWC+19] attempts to do this via what we call “in-context learning”, using the text input of a pretrained language model as a form of task specification: the model is conditioned on a natural language instruction and/or a few demonstrations of the task and is then expected to complete further instances of the task simply by predicting what comes next.

と定義している。 #Article #MachineTranslation #NLP #Dataset Issue Date: 2024-11-20 Datasets: hpprc_honyaku, hpprc, 2024.11 Comment元ポスト: https://x.com/hpp_ricecake/status/1859118112672780401?s=46&t=Y6UuIHB0Lv0IpmFAjlc2-Q英語Wikipediaを冒頭数文を抽出し日本語に人手で翻訳(Apache2.0ライセンスであるCalmやQwenの出力を参考に、cc-by-sa-4.0ライセンスにて公開している。

テクニカルタームが日本語で存在する場合は翻訳結果に含まれるようにしたり、翻訳された日本語テキストが単体で意味が成り立つように翻訳しているとのことで、1件あたり15分もの時間をかけて翻訳したとのこと。データ量は33件。many-shotやfew-shotに利用できそう。

日英対訳コーパスはライセンスが厳しいものが多いとのことなので、非常に有用だと思う。

#EfficiencyImprovement #MachineLearning #NLP #In-ContextLearning Issue Date: 2023-07-13 FiD-ICL: A Fusion-in-Decoder Approach for Efficient In-Context Learning, ACL'23 Summary大規模な事前学習モデルを使用したfew-shot in-context learning(ICL)において、fusion-in-decoder(FiD)モデルを適用することで効率とパフォーマンスを向上させることができることを検証する。FiD-ICLは他のフュージョン手法と比較して優れたパフォーマンスを示し、推論時間も10倍速くなる。また、FiD-ICLは大規模なメタトレーニングモデルのスケーリングも可能にする。 #Pocket #NLP #LanguageModel #Chain-of-Thought #ACL Issue Date: 2023-05-04 Challenging BIG-Bench Tasks and Whether Chain-of-Thought Can Solve Them, Mirac Suzgun+, N_A, ACL'23 SummaryBIG-Bench Hard (BBH) is a suite of 23 challenging tasks that current language models have not been able to surpass human performance on. This study focuses on applying chain-of-thought prompting to BBH tasks and found that PaLM and Codex were able to surpass human performance on 10 and 17 tasks, respectively. The study also found that CoT prompting is necessary for tasks that require multi-step reasoning and that CoT and model scale interact to enable new task performance on some BBH tasks. Comment単なるfewshotではなく、CoT付きのfewshotをすると大幅にBIG-Bench-hardの性能が向上するので、CoTを使わないanswer onlyの設定はモデルの能力の過小評価につながるよ、という話らしい

T5 のように、様々な推薦タスクを、「Prompt + Prediction」のpipelineとして定義して解けるようにした研究。

P5ではencoder-decoder frameworkを採用しており、encoder側ではbidirectionalなモデルでpromptのrepresentationを生成し、auto-regressiveな言語モデルで生成を行う。

推薦で利用したいデータセットから、input-target pairsを生成し上記アーキテクチャに対して事前学習することで、推薦を実現できる。

RatingPredictionでは、MatrixFactorizationに勝てていない(が、Rating Predictionについては魔法の壁問題などもあると思うのでなんともいえない。)

Sequential RecommendationではBERT4Recとかにも勝てている模様。

Prompt例

・Rating Predictionの例

・Sequential Recommendationの例

・Explanationを生成する例

・Zero-shotの例(Cold-Start)

先行研究では、reasoningが必要なタスクの性能が低い問題をintermediate stepを明示的に作成し、pre-trainedモデルをfinetuningすることで解決していた。しかしこの方法では、finetuning用の高品質なrationaleが記述された大規模データを準備するのに多大なコストがかかるという問題があった。

このため、few-shot promptingによってこの問題を解決することが考えられるが、reasoning能力が必要なタスクでは性能が悪いという問題あがった。そこで、両者の強みを組み合わせた手法として、chain-of-thought promptingは提案された。CoTによる実験結果

以下のベンチマークを利用

・math word problem: GSM8K, SVAMP, ASDiv, AQuA, MAWPS

・commonsense reasoning: CSQA, StrategyQA, Big-bench Effort (Date, Sports), SayCan

・Symbolic Reasoning: Last Letter concatenation, Coin Flip

・Last Letter concatnation: 名前の単語のlast wordをconcatするタスク("Amy Brown" -> "yn")

・Coin Flip: コインをひっくり返す、 あるいはひっくり返さない動作の記述の後に、コインが表向きであるかどうかをモデルに回答するよう求めるタスク

math word problem benchmark

・モデルのサイズが大きくなるにつれ性能が大きく向上(emergent ability)することがあることがわかる

・言い換えるとCoTは<100Bのモデルではパフォーマンスに対してインパクトを与えない

・モデルサイズが小さいと、誤ったCoTを生成してしまうため

・複雑な問題になればなるほど、CoTによる恩恵が大きい

・ベースラインの性能が最も低かったGSM8Kでは、パフォーマンスの2倍向上しており、1 stepのreasoningで解決できるSingleOpやMAWPSでは、性能の向上幅が小さい

・Task specificなモデルをfinetuningした以前のSoTAと比較してcomparable, あるいはoutperformしている

・

Ablation Study

CoTではなく、他のタイプのpromptingでも同じような効果が得られるのではないか?という疑問に回答するために、3つのpromptingを実施し、CoTと性能比較した:

・Equation Only: 回答するまえに数式を記載するようなprompt

・promptの中に数式が書かれているから性能改善されているのでは?という疑問に対する検証

・=> GSM8Kによる結果を見ると、equation onlyでは性能が低かった。これは、これは数式だけでreasoning stepsを表現できないことに起因している

・Variable compute only: dotのsequence (...) のみのprompt

・CoTは難しい問題に対してより多くの計算(intermediate token)をすることができているからでは?という疑問に対する検証

・variable computationとCoTの影響を分離するために、dotのsequence (...) のみでpromptingする方法を検証

・=> 結果はbaselineと性能変わらず。このことから、variableの計算自体が性能向上に寄与しているわけではないことがわかる。

・Chain of Thought after answer: 回答の後にCoTを出力するようなprompting

・単にpretrainingの際のrelevantな知識にアクセスしやすくなっているだけなのでは?という疑問を検証

・=> baselineと性能は変わらず、単に知識を活性化させるだけでは性能が向上しないことがわかる。

CoTのロバスト性

人間のAnnotatorにCoTを作成させ、それらを利用したCoTpromptingとexamplarベースな手法によって性能がどれだけ変わるかを検証。standard promptingを全ての場合で上回る性能を獲得した。このことから、linguisticなstyleにCoTは影響を受けていないことがわかる。

commonsense reasoning

全てのデータセットにおいて、CoTがstandard promptingをoutperformした。

Symbolic Reasoning

in-domain test setとout-of-domain test setの2種類を用意した。前者は必要なreasoning stepがfew-shot examplarと同一のもの、後者は必要なreasoning stepがfew-shot examplarよりも多いものである。

CoTがStandard proimptingを上回っている。特に、standard promptingではOOV test setではモデルをスケールさせても性能が向上しなかったのに対し、CoTではより大きなgainを得ている。このことから、CoTにはreasoning stepのlengthに対しても汎化能力があることがわかる。

#NeuralNetwork #Pocket #NLP #LanguageModel #In-ContextLearning #NeurIPS #Admin'sPick Issue Date: 2023-04-27 Language Models are Few-Shot Learners, Tom B. Brown+, NeurIPS'20 SummaryGPT-3は1750億パラメータを持つ自己回帰型言語モデルで、少数ショット設定においてファインチューニングなしで多くのNLPタスクで強力な性能を示す。翻訳や質問応答などで優れた結果を出し、即時推論やドメイン適応が必要なタスクでも良好な性能を発揮する一方、依然として苦手なデータセットや訓練に関する問題も存在する。また、GPT-3は人間が書いた記事と区別が難しいニュース記事を生成できることが確認され、社会的影響についても議論される。 CommentIn-Context Learningを提案した論文論文に記載されているIn-Context Learningの定義は、しっかり押さえておいた方が良い。

下図はmeta-learningの観点から見たときの、in-contextの位置付け。事前学習時にSGDでパラメータをupdateするのをouter loopとし、そこで広いスキルとパターン認識の能力を身につける。一方で、in-context learningは、Inference時に事前学習時に得たそれらのスキルを用いて、求めるタスクを認識、あるいは適応するInner loopのことを指す。

この上で、論文中では In-Context Learningについて:

> Recent work [RWC+19] attempts to do this via what we call “in-context learning”, using the text input of a pretrained language model as a form of task specification: the model is conditioned on a natural language instruction and/or a few demonstrations of the task and is then expected to complete further instances of the task simply by predicting what comes next.

と定義している。 #Article #MachineTranslation #NLP #Dataset Issue Date: 2024-11-20 Datasets: hpprc_honyaku, hpprc, 2024.11 Comment元ポスト: https://x.com/hpp_ricecake/status/1859118112672780401?s=46&t=Y6UuIHB0Lv0IpmFAjlc2-Q英語Wikipediaを冒頭数文を抽出し日本語に人手で翻訳(Apache2.0ライセンスであるCalmやQwenの出力を参考に、cc-by-sa-4.0ライセンスにて公開している。

テクニカルタームが日本語で存在する場合は翻訳結果に含まれるようにしたり、翻訳された日本語テキストが単体で意味が成り立つように翻訳しているとのことで、1件あたり15分もの時間をかけて翻訳したとのこと。データ量は33件。many-shotやfew-shotに利用できそう。

日英対訳コーパスはライセンスが厳しいものが多いとのことなので、非常に有用だと思う。