ResidualStream

[Paper Note] Deep Delta Learning, Yifan Zhang+, arXiv'26, 2026.01

Paper/Blog Link My Issue

#NeuralNetwork #MachineLearning #Pocket #NLP #InductiveBias #KeyPoint Notes Issue Date: 2026-01-03 GPT Summary- Deep Delta Learning(DDL)を提案し、学習可能な恒等ショートカット接続を用いて残差接続を一般化。デルタ演算子を導入し、動的に補間可能なゲートを用いて情報の消去と新しい特徴の書き込みを制御。これにより、複雑な状態遷移をモデル化しつつ、安定したトレーニング特性を維持。 Comment

元ポスト:

解説:

residual connectionは残差を加算するがこれがinducive biasとなり複雑な状態遷移を表現する上ての妨げになっていたが、residual connectionを学習可能なdelta operator(rank1の対称行列によって実現される幾何変換)とやらで一般化することで、表現力を向上させる、といった話な模様。この行列によって実現される幾何変換は3種類によって構成され、βの値によって性質が変わる。たとえばβ=0に近づくほど恒等写像(何もしない)に近づき、β=1に近づくほど射影(特定方向の成分を捨てる)、β=2に近づくほど反射(特定方向の成分を反転させる)といった変換になるらしい。

概念が示されたのみで実験結果はまだ無さそうに見える。

[Paper Note] Hyper-Connections, Defa Zhu+, ICLR'25, 2024.09

Paper/Blog Link My Issue

#MachineLearning #Pocket #NLP #LanguageModel #Transformer #Architecture #ICLR Issue Date: 2026-01-02 GPT Summary- ハイパーコネクションは、残差接続の代替手法であり、勾配消失や表現崩壊の問題に対処します。異なる深さの特徴間の接続を調整し、層を動的に再配置することが可能です。実験により、ハイパーコネクションが残差接続に対して性能向上を示し、視覚タスクでも改善が確認されました。この手法は幅広いAI問題に適用可能と期待されています。 Comment

openreview: https://openreview.net/forum?id=9FqARW7dwB

[Paper Note] mHC: Manifold-Constrained Hyper-Connections, Zhenda Xie+, arXiv'25, 2025.12

Paper/Blog Link My Issue

#MachineLearning #Pocket #NLP #Transformer #Architecture #read-later #Selected Papers/Blogs #Stability #KeyPoint Notes #Reference Collection Issue Date: 2026-01-02 GPT Summary- Manifold-Constrained Hyper-Connections(mHC)を提案し、残差接続の多様化による訓練の不安定性やメモリアクセスのオーバーヘッドに対処。mHCは残差接続空間を特定の多様体に射影し、恒等写像特性を回復しつつ効率を確保。実証実験により、大規模訓練での性能向上とスケーラビリティを示し、トポロジーアーキテクチャ設計の理解を深めることを期待。 Comment

元ポスト:

所見:

先行研究:

- [Paper Note] Hyper-Connections, Defa Zhu+, ICLR'25, 2024.09

- [Paper Note] Deep Residual Learning for Image Recognition, Kaiming He+, CVPR'16, 2015.12

所見:

ポイント解説:

解説:

従来のHCがResidual Streamに対してH_resを乗じて幾何的変換を実施する際に、H_resに制約がないため、Layerを重ねるごとにResidual Streamの大きさが指数的に発散、あるいは収縮していき学習が不安的になる課題を、二重確率行列(行と列の成分の合計が1.0となるような正規化をする)を用いた変換を用いることで、Residual Streamのノルムが変化しないようにし安定化させた、といった感じの話に見える。

[Paper Note] Deep Residual Learning for Image Recognition, Kaiming He+, CVPR'16, 2015.12

Paper/Blog Link My Issue

#NeuralNetwork #ComputerVision #Pocket #CVPR #Selected Papers/Blogs #Backbone Issue Date: 2021-11-04 GPT Summary- 残差学習フレームワークを提案し、深いニューラルネットワークのトレーニングを容易にする。参照層の入力に基づいて残差関数を学習することで、最適化が容易になり、精度が向上。152層の残差ネットはImageNetで低い複雑性を保ちながら高い性能を示し、ILSVRC 2015で1位を獲得。COCOデータセットでも28%の改善を達成。 Comment

ResNet論文

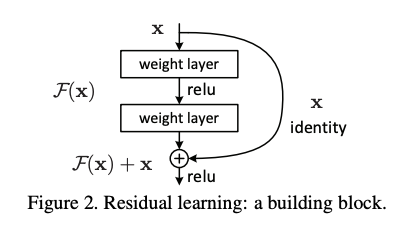

ResNetでは、レイヤーの計算する関数を、残差F(x)と恒等関数xの和として定義する。これにより、レイヤーが入力との差分だけを学習すれば良くなり、モデルを深くしても最適化がしやすくなる効果ぎある。数レイヤーごとにResidual Connectionを導入し、恒等関数によるショートカットができるようにしている。

ResNetが提案される以前、モデルを深くすれば表現力が上がるはずなのに、実際には精度が下がってしまうことから、理論上レイヤーが恒等関数となるように初期化すれば、深いモデルでも浅いモデルと同等の表現が獲得できる、と言う考え方を発展させた。

(ステートオブAIガイドに基づく)

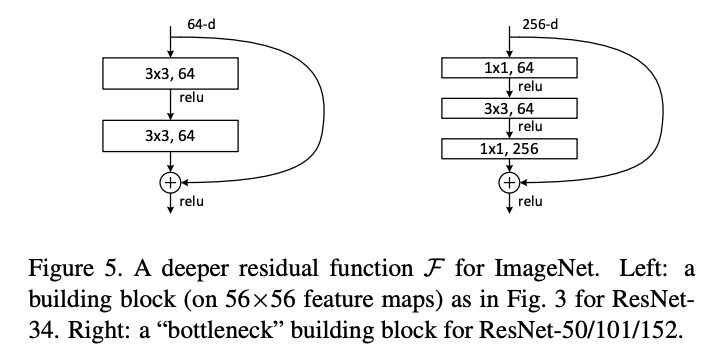

同じパラメータ数でより層を深くできる(Plainな構造と比べると層が1つ増える)Bottleneckアーキテクチャも提案している。

今や当たり前のように使われているResidual Connectionは、層の深いネットワークを学習するために必須の技術なのだと再認識。

10,924x: The Instability Bomb at 1.7B Scale, TayKolasinski, 2026.01

Paper/Blog Link My Issue

#Article #Tutorial #MachineLearning #NLP #LanguageModel #Blog #Selected Papers/Blogs #Reproducibility Issue Date: 2026-01-19 Comment

元ポスト:

関連:

- [Paper Note] mHC: Manifold-Constrained Hyper-Connections, Zhenda Xie+, arXiv'25, 2025.12

- [Paper Note] Hyper-Connections, Defa Zhu+, ICLR'25, 2024.09

part1:

https://taylorkolasinski.com/notes/mhc-reproduction/

HC, mHCの説明が美しい図解と数式で説明されている。分かりやすい!

HCの課題とmHCがどのように解決したかを数式的、直感的に理解でき非常に有用