MachineLearning

[Paper Note] Digital Red Queen: Adversarial Program Evolution in Core War with LLMs, Akarsh Kumar+, arXiv'26, 2026.01

Paper/Blog Link My Issue

#Multi #Pocket #NLP #LanguageModel #AIAgents #Generalization #EvolutionaryAlgorithm #AdversarialTraining Issue Date: 2026-01-12 GPT Summary- 大規模言語モデル(LLMs)を用いた自己対戦アルゴリズム「デジタルレッドクイーン(DRQ)」を提案。DRQは、コアウォーというゲームでアセンブリプログラムを進化させ、動的な目的に適応することで「レッドクイーン」ダイナミクスを取り入れる。多くのラウンドを経て、戦士は人間の戦士に対して一般的な行動戦略に収束する傾向を示し、静的な目的から動的な目的へのシフトの価値を強調。DRQは、サイバーセキュリティや薬剤耐性などの実用的な多エージェント敵対的ドメインでも有用である可能性を示唆。 Comment

元ポスト:

[Paper Note] From Entropy to Epiplexity: Rethinking Information for Computationally Bounded Intelligence, Marc Finzi+, arXiv'26, 2026.01

Paper/Blog Link My Issue

#Analysis #Metrics #Pocket #Dataset #read-later #Selected Papers/Blogs #OOD #Generalization Issue Date: 2026-01-09 GPT Summary- 本研究では、データから新たな情報を生成する可能性や、情報の評価方法について探求する。シャノン情報やコルモゴロフの複雑性が無力である理由を示し、情報理論における三つの矛盾する現象を特定する。新たに導入した「エピプレキシティ」は、計算制約のある観察者がデータから学べる情報を捉え、データの構造的内容を評価する手法である。これにより、情報生成のメカニズムやデータの順序依存性を明らかにし、エピプレキシティを用いたデータ選択の理論的基盤を提供する。 Comment

元ポスト:

解説:

ポイント解説:

[Paper Note] How to Set the Batch Size for Large-Scale Pre-training?, Yunhua Zhou+, arXiv'26, 2026.01

Paper/Blog Link My Issue

#Pretraining #Pocket #NLP #LanguageModel #read-later #Batch #Scheduler #CriticalBatchSize Issue Date: 2026-01-09 GPT Summary- WSD学習率スケジューラに特化した改訂版E(S)関係を導出し、事前学習中のトレーニングデータ消費とステップのトレードオフを分析。最小バッチサイズと最適バッチサイズを特定し、動的バッチサイズスケジューラを提案。実験により、提案したスケジューリング戦略がトレーニング効率とモデル品質を向上させることを示した。 Comment

元ポスト:

Critical batch sizeが提案された研究:

- An Empirical Model of Large-Batch Training, Sam McCandlish+, arXiv'18

[Paper Note] Deep Delta Learning, Yifan Zhang+, arXiv'26, 2026.01

Paper/Blog Link My Issue

#NeuralNetwork #Pocket #NLP #InductiveBias #KeyPoint Notes #ResidualStream Issue Date: 2026-01-03 GPT Summary- Deep Delta Learning(DDL)を提案し、学習可能な恒等ショートカット接続を用いて残差接続を一般化。デルタ演算子を導入し、動的に補間可能なゲートを用いて情報の消去と新しい特徴の書き込みを制御。これにより、複雑な状態遷移をモデル化しつつ、安定したトレーニング特性を維持。 Comment

元ポスト:

解説:

residual connectionは残差を加算するがこれがinducive biasとなり複雑な状態遷移を表現する上ての妨げになっていたが、residual connectionを学習可能なdelta operator(rank1の対称行列によって実現される幾何変換)とやらで一般化することで、表現力を向上させる、といった話な模様。この行列によって実現される幾何変換は3種類によって構成され、βの値によって性質が変わる。たとえばβ=0に近づくほど恒等写像(何もしない)に近づき、β=1に近づくほど射影(特定方向の成分を捨てる)、β=2に近づくほど反射(特定方向の成分を反転させる)といった変換になるらしい。

概念が示されたのみで実験結果はまだ無さそうに見える。

[Paper Note] The Missing Layer of AGI: From Pattern Alchemy to Coordination Physics, Edward Y. Chang, arXiv'25, 2025.12

Paper/Blog Link My Issue

#Pocket #NLP #LanguageModel Issue Date: 2026-01-05 GPT Summary- 大規模言語モデル(LLMs)はAGIにおいて行き止まりとされるが、これは誤ったボトルネックの特定であると主張。パターンマッチングは必要だが、推論を行うための調整層が欠けている。UCCTを通じてこの層を形式化し、推論を支える理論を提案。無根拠な生成は基盤の最大尤度事前分布の取得に過ぎず、推論は目標指向の制約に向けた事後分布のシフトによって生じる。UCCTをアーキテクチャに変換し、調整スタックMACIを実装することで、AGIへの道はLLMsを通じて進むべきであると結論づける。 Comment

元ポスト:

[Paper Note] Deep sequence models tend to memorize geometrically; it is unclear why, Shahriar Noroozizadeh+, arXiv'25, 2025.10

Paper/Blog Link My Issue

#Analysis #Pocket #Transformer #Memorization #FactualKnowledge #Geometric Issue Date: 2026-01-05 GPT Summary- 深層系列モデルは、エンティティ間の新しいグローバルな関係を幾何学的記憶として保存することを提案。これにより、難しい推論タスクが簡単なナビゲーションタスクに変換されることを示す。ブルートフォース検索よりも複雑な幾何学が学習されることを主張し、Node2Vecとの関連を分析して、自然に生じるスペクトルバイアスからこの幾何学が生まれることを示す。Transformerメモリの幾何学的強化の可能性を指摘し、知識獲得や忘却に関する直感を再考することを促す。 Comment

元ポスト:

[Paper Note] Why Low-Precision Transformer Training Fails: An Analysis on Flash Attention, Haiquan Qiu+, arXiv'25, 2025.10

Paper/Blog Link My Issue

#Analysis #Pocket #NLP #Transformer #read-later #Selected Papers/Blogs #Stability Issue Date: 2026-01-03 GPT Summary- 低精度フォーマットのトランスフォーマーモデルのトレーニングにおける不安定性の原因を分析し、フラッシュアテンションが損失の爆発を引き起こすメカニズムを明らかにした。具体的には、低ランク表現の出現と丸め誤差の累積がエラーの悪循環を生むことを示した。これを受けて、丸め誤差を軽減する修正を加えることでトレーニングの安定性を向上させ、実用的な解決策を提供した。 Comment

元ポスト:

[Paper Note] Hyper-Connections, Defa Zhu+, ICLR'25, 2024.09

Paper/Blog Link My Issue

#Pocket #NLP #LanguageModel #Transformer #Architecture #ICLR #ResidualStream Issue Date: 2026-01-02 GPT Summary- ハイパーコネクションは、残差接続の代替手法であり、勾配消失や表現崩壊の問題に対処します。異なる深さの特徴間の接続を調整し、層を動的に再配置することが可能です。実験により、ハイパーコネクションが残差接続に対して性能向上を示し、視覚タスクでも改善が確認されました。この手法は幅広いAI問題に適用可能と期待されています。 Comment

openreview: https://openreview.net/forum?id=9FqARW7dwB

[Paper Note] mHC: Manifold-Constrained Hyper-Connections, Zhenda Xie+, arXiv'25, 2025.12

Paper/Blog Link My Issue

#Pocket #NLP #Transformer #Architecture #read-later #Selected Papers/Blogs #Stability #KeyPoint Notes #Reference Collection #ResidualStream Issue Date: 2026-01-02 GPT Summary- Manifold-Constrained Hyper-Connections(mHC)を提案し、残差接続の多様化による訓練の不安定性やメモリアクセスのオーバーヘッドに対処。mHCは残差接続空間を特定の多様体に射影し、恒等写像特性を回復しつつ効率を確保。実証実験により、大規模訓練での性能向上とスケーラビリティを示し、トポロジーアーキテクチャ設計の理解を深めることを期待。 Comment

元ポスト:

所見:

先行研究:

- [Paper Note] Hyper-Connections, Defa Zhu+, ICLR'25, 2024.09

- [Paper Note] Deep Residual Learning for Image Recognition, Kaiming He+, CVPR'16, 2015.12

所見:

ポイント解説:

解説:

従来のHCがResidual Streamに対してH_resを乗じて幾何的変換を実施する際に、H_resに制約がないため、Layerを重ねるごとにResidual Streamの大きさが指数的に発散、あるいは収縮していき学習が不安的になる課題を、二重確率行列(行と列の成分の合計が1.0となるような正規化をする)を用いた変換を用いることで、Residual Streamのノルムが変化しないようにし安定化させた、といった感じの話に見える。

[Paper Note] Stronger Normalization-Free Transformers, Mingzhi Chen+, arXiv'25, 2025.12

Paper/Blog Link My Issue

#Pocket #Transformer #Architecture Issue Date: 2025-12-22 GPT Summary- 本研究では、Dynamic Tanh(DyT)を超える新たな正規化関数として$\mathrm{Derf}(x) = \mathrm{erf}(αx + s)$を提案。Derfは、画像認識、音声表現、DNA配列モデリングなどの分野でLayerNorm、RMSNorm、DyTを上回る性能を示し、その優れた一般化能力がパフォーマンス向上の要因であることを明らかにした。Derfはシンプルで強力なため、正規化なしのTransformerアーキテクチャにおける実用的な選択肢となる。 Comment

元ポスト:

先行研究:

- [Paper Note] Transformers without Normalization, Jiachen Zhu+, CVPR'25

[Paper Note] Transcoders Beat Sparse Autoencoders for Interpretability, Gonçalo Paulo+, arXiv'25, 2025.01

Paper/Blog Link My Issue

#NeuralNetwork #Pocket #Transcoders #CircuitAnalysis #Interpretability Issue Date: 2025-12-21 GPT Summary- スパースオートエンコーダー(SAE)とトランスコーダーの特徴を比較した結果、トランスコーダーの方が解釈可能性が高いことが判明。さらに、アフィン・スキップ接続を追加したスキップトランスコーダーを提案し、解釈可能性を維持しつつ再構築損失を低下させることを示した。

[Paper Note] Learning Multi-Level Features with Matryoshka Sparse Autoencoders, Bart Bussmann+, ICLR'25, 2025.03

Paper/Blog Link My Issue

#NeuralNetwork #Pocket #NLP #LanguageModel #ICLR #SparseAutoEncoder #Interpretability Issue Date: 2025-12-21 GPT Summary- Matryoshka SAEという新しいスパースオートエンコーダーのバリアントを提案し、複数のネストされた辞書を同時に訓練することで、特徴を階層的に整理。小さな辞書は一般的な概念を、大きな辞書は特定の概念を学び、高次の特徴の吸収を防ぐ。Gemma-2-2BおよびTinyStoriesでの実験により、優れたパフォーマンスと分離された概念表現を確認。再構成性能にはトレードオフがあるが、実用的なタスクにおいて優れた代替手段と考えられる。 Comment

openreview: https://openreview.net/forum?id=m25T5rAy43

[Paper Note] Scaling Laws and Symmetry, Evidence from Neural Force Fields, Khang Ngo+, arXiv'25, 2025.10

Paper/Blog Link My Issue

#NeuralNetwork #Pretraining #Pocket #InductiveBias #Scaling Laws #One-Line Notes Issue Date: 2025-12-19 GPT Summary- 原子間ポテンシャルを学習する幾何学的タスクに関する実証研究を行い、等変性が大規模スケールで重要であることを示した。等変アーキテクチャは非等変モデルよりも優れたスケーリングを示し、高次の表現がより良いスケーリング指数に寄与することが分かった。データとモデルのサイズはアーキテクチャに関係なく連動してスケールすべきであり、対称性などの基本的な帰納的バイアスをモデルに発見させるべきではないと結論付けた。 Comment

元ポスト:

openreview: https://openreview.net/forum?id=qyjaVda7t2

Inducive Bias(対称性vs.非対称性)によってスケーリング則の係数が変わることを原子間ポテンシャルを予測するタスクにおいて示した、という話っぽい?openreviewだとweaknessが多く指摘されている(この性質が一定の一般性を持つ話として記述されているが実験が限定的だからスコープを狭めるべきみたいな話やNLPから多くの手法を引っ張ってきているが原子間ポテンシャル予測は根本的に性質が異なるみたいな指摘など)ように見えるが果たして。

[Paper Note] Escaping the Verifier: Learning to Reason via Demonstrations, Locke Cai+, arXiv'25, 2025.11

Paper/Blog Link My Issue

#Pocket #NLP #LanguageModel #Reasoning #read-later #Selected Papers/Blogs #AdversarialTraining Issue Date: 2025-12-12 GPT Summary- RARO(Relativistic Adversarial Reasoning Optimization)は、専門家のデモンストレーションから逆強化学習を通じて推論能力を学習する手法。ポリシーは専門家の回答を模倣し、批評者は専門家を特定する敵対的なゲームを設定。実験では、RAROが検証者なしのベースラインを大幅に上回り、堅牢な推論学習を実現することを示した。 Comment

元ポスト:

重要研究に見える

has any code?

@duzhiyu11 Thank you for the comment. As stated in this post, they appear to be preparing to release the code. It would be best to wait for an official announcement from the authors regarding the code release.

[Paper Note] Do Language Models Use Their Depth Efficiently?, Róbert Csordás+, arXiv'25, 2025.05

Paper/Blog Link My Issue

#Analysis #Pocket #NLP #Transformer #Architecture #NeurIPS #Depth Issue Date: 2025-12-04 GPT Summary- 大規模言語モデル(LLM)の深さと性能の関係を分析した結果、後半の層は前半の層に比べて貢献度が低く、後半の層をスキップしても影響は小さいことが分かった。また、深いモデルは新しい計算を行っているのではなく、同じ計算を多くの層に分散させていることが示唆された。このことは、深さの増加がリターンの減少をもたらす理由を説明するかもしれない。 Comment

元ポスト:

RLとネットワークの深さの関係性を分析した研究もある:

- [Paper Note] 1000 Layer Networks for Self-Supervised RL: Scaling Depth Can Enable New Goal-Reaching Capabilities, Wang+, NeurIPS'25 Best Paper Awards

[Paper Note] What Makes a Reward Model a Good Teacher? An Optimization Perspective, Noam Razin+, NeurIPS'25 Spotlight, 2025.03

Paper/Blog Link My Issue

#Analysis #Pocket #NLP #LanguageModel #Alignment #ReinforcementLearning #NeurIPS #read-later #Selected Papers/Blogs #RewardModel #KeyPoint Notes Issue Date: 2025-12-03 GPT Summary- 報酬モデルの質はRLHFの成功に重要であり、精度だけでは不十分であることを示す。低い報酬の分散は平坦な最適化ランドスケープを引き起こし、完全に正確なモデルでも遅い最適化を招く可能性がある。異なる言語モデルに対する報酬モデルの効果も異なり、精度に基づく評価の限界を明らかにする。実験により、報酬の分散と精度の相互作用が確認され、効率的な最適化には十分な分散が必要であることが強調される。 Comment

元ポスト:

RLHFにおいてReward Modelが良い教師となれるかどうかは、Accuracy[^1]という単一次元で決まるのではなく、報酬の分散の大きさ[^2]も重要だよという話らしく、分散がほとんどない完璧なRMで学習すると学習が進まず、より不正確で報酬の分散が大きいRMの方が性能が良い。報酬の分散の大きさはベースモデルによるのでRM単体で良さを測ることにはげんかいがあるよ、といあ話らしい。

理想的な報酬の形状は山の頂上がなるべくズレておらず(=Accuracyが高い)かつ、山が平坦すぎない(=報酬の分散が高い)ようなものであり、

Accuracyが低いとReward Hackingが起きやすくなり、報酬の分散が低いと平坦になり学習効率が悪くなる(Figure1)。

[^1]: 応答Aが応答Bよりも優れているかという観点

[^2]: 学習対象のLLMがとりそうな出力に対して、RMがどれだけ明確に差をつけて報酬を与えられるかという観点(良い応答と悪い応答の弁別)

[Paper Note] 1000 Layer Networks for Self-Supervised RL: Scaling Depth Can Enable New Goal-Reaching Capabilities, Wang+, NeurIPS'25 Best Paper Awards

Paper/Blog Link My Issue

#NeuralNetwork #ComputerVision #ReinforcementLearning #Self-SupervisedLearning #NeurIPS #read-later #Selected Papers/Blogs #Robotics #Locomotion #ContrastiveReinforcementLearning #Manipulation #EmergentAbilities #Depth Issue Date: 2025-12-01 GPT Summary- 自己教師ありRLのスケーラビリティを改善するため、ネットワークの深さを1024層に増加させることで性能向上を実証。無監督の目標条件設定でエージェントが探索し、目標達成を学ぶ実験を行い、自己教師ありコントラストRLアルゴリズムの性能を向上させた。深さの増加は成功率を高め、行動の質的変化ももたらす。 Comment

元ポスト:

[Paper Note] Why Diffusion Models Don't Memorize: The Role of Implicit Dynamical Regularization in Training, Tony Bonnaire+, NeurIPS'25 Best Paper Awards, 2025.05

Paper/Blog Link My Issue

#Analysis #Pocket #DiffusionModel #NeurIPS #Memorization #Generalization Issue Date: 2025-11-29 GPT Summary- 拡散モデルのトレーニングダイナミクスを調査し、一般化から記憶への移行における2つの時間スケール($τ_\mathrm{gen}$と$τ_\mathrm{mem}$)を特定。$τ_\mathrm{mem}$はトレーニングセットのサイズに線形に増加し、一般化が可能なトレーニング時間のウィンドウが拡大することを示す。これにより、過学習が消失する閾値が存在し、記憶を回避できることが明らかに。実験と理論分析により結果が支持される。 Comment

元ポスト:

openreview: https://openreview.net/forum?id=BSZqpqgqM0

日本語解説: https://www.docswell.com/s/DeepLearning2023/59MQLY-2025-11-11-132245

ポイント解説:

[Paper Note] Nested Learning: The Illusion of Deep Learning Architectures, Behrouz, NeurIPS'25, 2025.10

Paper/Blog Link My Issue

#NeurIPS Issue Date: 2025-11-26 GPT Summary- 新しい学習パラダイム「ネストされた学習(NL)」を提案し、深層学習における文脈内学習のメカニズムを解明。NLに基づく深層最適化器、自己修正型モデル、連続記憶システムを開発し、言語モデリングや継続的学習での有望な結果を示す学習モジュール「Hope」を提案。 Comment

元ポスト:

[Paper Note] What Does It Take to Be a Good AI Research Agent? Studying the Role of Ideation Diversity, Alexis Audran-Reiss+, arXiv'25, 2025.11

Paper/Blog Link My Issue

#Pocket #NLP #LanguageModel #AIAgents #Reasoning #ScientificDiscovery #Diversity #One-Line Notes Issue Date: 2025-11-21 GPT Summary- AI研究エージェントのパフォーマンスにおけるアイデアの多様性の役割を検討。MLE-benchでの分析により、パフォーマンスの高いエージェントはアイデアの多様性が増加する傾向があることが明らかに。制御実験でアイデアの多様性が高いほどパフォーマンスが向上することを示し、追加の評価指標でも発見が有効であることを確認。 Comment

元ポスト:

ideation時点における多様性を向上させる話らしい

[Paper Note] TabArena: A Living Benchmark for Machine Learning on Tabular Data, Nick Erickson+, NeurIPS'25 Spotlight, 2025.06

Paper/Blog Link My Issue

#Pocket #NLP #Dataset #TabularData #Evaluation #Selected Papers/Blogs #Live #One-Line Notes Issue Date: 2025-11-14 GPT Summary- TabArenaは、表形式データのための初の生きたベンチマークシステムであり、継続的に更新されることを目的としています。手動でキュレーションされたデータセットとモデルを用いて、公開リーダーボードを初期化しました。結果は、モデルのベンチマークにおける検証方法やハイパーパラメータ設定の影響を示し、勾配ブースティング木が依然として強力である一方、深層学習手法もアンサンブルを用いることで追いついてきていることを観察しました。また、基盤モデルは小規模データセットで優れた性能を発揮し、モデル間のアンサンブルが表形式機械学習の進展に寄与することを示しました。TabArenaは、再現可能なコードとメンテナンスプロトコルを提供し、https://tabarena.ai で利用可能です。 Comment

pj page:

https://github.com/autogluon/tabarena

leaderboard:

https://huggingface.co/spaces/TabArena/leaderboard

liveデータに基づくベンチマークで、手動で収集された51のtabularデータセットが活用されているとのこと。またあるモデルに対して数百にも登るハイパーパラメータ設定での実験をしアンサンブルをすることで単一モデルが到達しうるピーク性能を見ることに主眼を置いている、またいな感じらしい。そしてやはり勾配ブースティング木が強い。tunedは単体モデルの最も性能が良い設定での性能で、ensembleは複数の設定での同一モデルのアンサンブルによる結果だと思われる。

> TabArena currently consists of:

> 51 manually curated tabular datasets representing real-world tabular data tasks.

> 9 to 30 evaluated splits per dataset.

> 16 tabular machine learning methods, including 3 tabular foundation models.

> 25,000,000 trained models across the benchmark, with all validation and test predictions cached to enable tuning and post-hoc ensembling analysis.

> A live TabArena leaderboard showcasing the results.

openreview: https://openreview.net/forum?id=jZqCqpCLdU

[Paper Note] TabPFN-2.5: Advancing the State of the Art in Tabular Foundation Models, Léo Grinsztajn+, arXiv'25, 2025.11

Paper/Blog Link My Issue

#NeuralNetwork #Pocket #NLP #TabularData #FoundationModel Issue Date: 2025-11-14 GPT Summary- 次世代の表形式基盤モデルTabPFN-2.5は、最大50,000のデータポイントと2,000の特徴量を持つデータセット向けに設計され、TabPFNv2と比較してデータセルが20倍増加。業界標準のTabArenaで主要な手法となり、以前のモデルを上回る精度を達成。小規模から中規模のデータセットに対して100%の勝率を持ち、大規模データセットでも高い勝率を誇る。商用ユース向けに新しい蒸留エンジンを導入し、低レイテンシーでの展開を実現。これにより、TabPFNエコシステムに基づくアプリケーションのパフォーマンスが向上する。 Comment

TabArenaの2025.11時点でのSoTA

- [Paper Note] TabArena: A Living Benchmark for Machine Learning on Tabular Data, Nick Erickson+, NeurIPS'25 Spotlight, 2025.06

元ポスト:

[Paper Note] Wasserstein-Cramér-Rao Theory of Unbiased Estimation, Nicolás García Trillos+, arXiv'25, 2025.11

Paper/Blog Link My Issue

#Pocket #Theory Issue Date: 2025-11-14 GPT Summary- 本論文では、無偏推定量の不安定性を「感度」と定義し、Wasserstein幾何学に基づく理論を提案。これにより、Wasserstein-Cramér-Rao下限や無偏推定量の特性を明らかにし、既存の推定量の最適性や新しい推定量の発見に寄与する結果を示す。 Comment

元ポスト:

む、むずかしい...!!

[Paper Note] Belief Dynamics Reveal the Dual Nature of In-Context Learning and Activation Steering, Eric Bigelow+, arXiv'25, 2025.11

Paper/Blog Link My Issue

#Analysis #Pocket #NLP #LanguageModel #In-ContextLearning #ActivationSteering/ITI Issue Date: 2025-11-12 GPT Summary- 大規模言語モデル(LLMs)の制御手法をベイズ的視点から統一的に説明。文脈に基づく介入と活性化に基づく介入がモデルの信念を変え、挙動に影響を与えることを示す。新たなベイズモデルにより、介入の効果を高精度で予測し、行動の急激な変化を引き起こす特異なフェーズを明らかにする。プロンプトと活性化の制御手法の統一的な理解を提供。 Comment

元ポスト:

[Paper Note] On a few pitfalls in KL divergence gradient estimation for RL, Yunhao Tang+, arXiv'25, 2025.06

Paper/Blog Link My Issue

#Analysis #Pocket #NLP #LanguageModel #ReinforcementLearning #Reasoning #One-Line Notes Issue Date: 2025-11-12 GPT Summary- LLMのRLトレーニングにおけるKLダイバージェンスの勾配推定に関する落とし穴を指摘。特に、KL推定を通じて微分する実装が不正確であることや、逐次的な性質を無視した実装が部分的な勾配しか生成しないことを示す。表形式の実験とLLM実験を通じて、正しいKL勾配の実装方法を提案。 Comment

元ポスト:

RLにおけるKL Divergenceによるポリシー正則化の正しい実装方法

[Paper Note] On the Design of KL-Regularized Policy Gradient Algorithms for LLM Reasoning, Yifan Zhang+, arXiv'25, 2025.05

Paper/Blog Link My Issue

#Analysis #Pocket #NLP #LanguageModel #ReinforcementLearning #read-later #Selected Papers/Blogs #On-Policy Issue Date: 2025-11-12 GPT Summary- ポリシー勾配アルゴリズムを用いてLLMの推論能力を向上させるため、正則化ポリシー勾配(RPG)を提案。RPGは、正規化されたKLと非正規化されたKLを統一し、REINFORCEスタイルの損失の微分可能性を特定。オフポリシー設定での重要度重み付けの不一致を修正し、RPGスタイルクリップを導入することで安定したトレーニングを実現。数学的推論ベンチマークで最大6%の精度向上を達成。 Comment

元ポスト:

pj page: https://complex-reasoning.github.io/RPG/

続報:

[Paper Note] Iterative Amortized Inference: Unifying In-Context Learning and Learned Optimizers, Sarthak Mittal+, arXiv'25, 2025.10

Paper/Blog Link My Issue

#Pocket #NLP #LanguageModel #In-ContextLearning #meta-learning Issue Date: 2025-11-03 GPT Summary- アモータイズド学習に基づく統一的フレームワークを提案し、タスク適応の方法をパラメトリック、暗黙的、明示的に分類。推論時のタスクデータ処理能力の制限を指摘し、反復アモータイズド推論を導入。これにより、最適化ベースのメタ学習とLLMのアプローチを結びつけ、汎用タスク適応のためのスケーラブルな基盤を提供。 Comment

元ポスト:

[Paper Note] SeeDNorm: Self-Rescaled Dynamic Normalization, Wenrui Cai+, arXiv'25, 2025.10

Paper/Blog Link My Issue

#ComputerVision #Pocket #NLP #LanguageModel #Transformer #Architecture #Normalization Issue Date: 2025-10-28 GPT Summary- SeeDNormは、入力に基づいて動的にスケーリング係数を調整する新しい正規化層であり、RMSNormの限界を克服します。これにより、入力のノルム情報を保持し、データ依存の自己再スケーリングを実現。大規模言語モデルやコンピュータビジョンタスクでの有効性を検証し、従来の正規化手法と比較して優れた性能を示しました。

[Paper Note] Robust Layerwise Scaling Rules by Proper Weight Decay Tuning, Zhiyuan Fan+, arXiv'25, 2025.10

Paper/Blog Link My Issue

#NeuralNetwork #Pocket #Optimizer Issue Date: 2025-10-28 GPT Summary- 経験的スケーリング法則と最大更新パラメータ化($\mu$P)を考慮し、幅にわたるサブレイヤーのゲインを保持するための重み減衰スケーリングルールを提案。特異値スペクトルのスケーリング観察に基づき、サブレイヤーゲインを幅不変に保つルールを導出し、プロキシからターゲット幅への学習率と重み減衰のゼロショット転送を実現。LLaMAスタイルのトランスフォーマーで検証し、オプティマイザによるスケール制御が$\mu$Pの拡張に寄与することを示す。 Comment

元ポスト:

[Paper Note] Weight Decay may matter more than muP for Learning Rate Transfer in Practice, Atli Kosson+, arXiv'25, 2025.10

Paper/Blog Link My Issue

#NeuralNetwork #Analysis #Pocket #Optimizer #ZeroshotHyperparameterTransfer #LearningRate Issue Date: 2025-10-28 GPT Summary- 学習率の転送は、ニューラルネットワークの効率的なトレーニングを可能にする。Maximal Update Parameterization(muP)は、内部表現の更新を安定させる学習率スケーリングを提案するが、その仮定は実際のトレーニングでは短期間しか維持されないことが示された。トレーニングの後半では、重み減衰が内部表現の安定に寄与し、学習率の転送を促進する。これにより、muPは主に学習率のウォームアップとして機能し、修正されたウォームアップスケジュールで置き換え可能であることが示唆される。これらの結果は、学習率の転送に関する従来の考え方に挑戦し、muPの成功には独立した重み減衰が必要であることを示す。 Comment

元ポスト:

[Paper Note] A Theoretical Study on Bridging Internal Probability and Self-Consistency for LLM Reasoning, Zhi Zhou+, NeurIPS'25, 2025.10

Paper/Blog Link My Issue

#Analysis #Pocket #NLP #LanguageModel #NeurIPS #Test-Time Scaling Issue Date: 2025-10-27 GPT Summary- テスト時スケーリングにおけるサンプリング手法の理論的枠組みを提供し、自己一貫性と困惑度の制限を明らかに。新たに提案したRPC手法は、困惑度一貫性と推論剪定を活用し、推論誤差の収束を改善。7つのベンチマークでの実証結果により、RPCは自己一貫性に匹敵する性能を達成し、サンプリングコストを50%削減することが示された。 Comment

元ポスト:

元ポスト:

pj page: https://zhouz.dev/RPC/

[Paper Note] Optimization Benchmark for Diffusion Models on Dynamical Systems, Fabian Schaipp, arXiv'25, 2025.10

Paper/Blog Link My Issue

#Analysis #Pocket #DiffusionModel #Optimizer Issue Date: 2025-10-26 GPT Summary- 拡散モデルのトレーニングにおける最適化手法を評価し、MuonとSOAPがAdamWに対して効率的な代替手段であることを示し、最終損失が18%低下することを観察。さらに、学習率スケジュールやAdamとSGDのパフォーマンスギャップなど、トレーニングダイナミクスに関連する現象を再考。 Comment

元ポスト:

[Paper Note] Algorithmic Primitives and Compositional Geometry of Reasoning in Language Models, Samuel Lippl+, arXiv'25, 2025.10

Paper/Blog Link My Issue

#Analysis #Pocket #NLP #LanguageModel #Reasoning Issue Date: 2025-10-25 GPT Summary- 本研究では、大規模言語モデル(LLMs)が多段階の推論を解決するためのアルゴリズム的原則を追跡し、操作するフレームワークを提案。推論のトレースを内部の活性化パターンにリンクさせ、原則を残差ストリームに注入することで、推論ステップやタスクのパフォーマンスへの影響を評価。旅行セールスマン問題や3SATなどのベンチマークを用いて、原則ベクトルの導出と幾何学的論理の明示化を行い、ファインチューニングによる一般化の強調を示した。これにより、LLMsの推論がアルゴリズム的原則の構成的幾何学に支えられている可能性が示唆され、原則の転送とドメイン間の一般化が強化されることが明らかになった。 Comment

元ポスト:

[Paper Note] Physics-Informed Diffusion Models, Jan-Hendrik Bastek+, ICLR'25, 2024.03

Paper/Blog Link My Issue

#Pocket #DiffusionModel #ICLR #PhysicalConstraints Issue Date: 2025-10-24 GPT Summary- 生成モデルと偏微分方程式を統一するフレームワークを提案し、生成サンプルが物理的制約を満たすように損失項を導入。流体の流れに関するケーススタディで残差誤差を最大2桁削減し、構造トポロジー最適化においても優れた性能を示す。過学習に対する正則化効果も確認。実装が簡単で、多様な制約に適用可能。 Comment

openreview: https://openreview.net/forum?id=tpYeermigp&utm_source=chatgpt.com

[Paper Note] The Free Transformer, François Fleuret, arXiv'25, 2025.10

Paper/Blog Link My Issue

#Pocket #Transformer #VariationalAutoEncoder #Architecture #Decoder Issue Date: 2025-10-22 GPT Summary- 無監督で学習された潜在変数に条件付けるデコーダーTransformerの拡張を提案し、下流タスクでの性能が大幅に向上することを実験で示した。 Comment

元ポスト:

ポイント解説:

[Paper Note] Emergent Coordination in Multi-Agent Language Models, Christoph Riedl, arXiv'25, 2025.10

Paper/Blog Link My Issue

#Multi #Analysis #Pocket #NLP #AIAgents #TheoryOfMind #read-later #Selected Papers/Blogs #Personality Issue Date: 2025-10-21 GPT Summary- 本研究では、マルチエージェントLLMシステムが高次の構造を持つかどうかを情報理論的フレームワークを用いて検証。実験では、エージェント間のコミュニケーションがない状況で、時間的相乗効果が観察される一方、調整された整合性は見られなかった。ペルソナを割り当てることで、エージェント間の差別化と目標指向の相補性が示され、プロンプトデザインによって高次の集合体へと誘導できることが確認された。結果は、効果的なパフォーマンスには整合性と相補的な貢献が必要であることを示唆している。 Comment

元ポスト:

非常にシンプルな設定でマルチエージェントによるシナジーが生じるか否か、そのための条件を検証している模様。小規模モデルだとシナジーは生じず、ペルソナ付与とTheory of Mindを指示すると効果が大きい模様

[Paper Note] End-to-End Multi-Modal Diffusion Mamba, Chunhao Lu+, arXiv'25, 2025.10

Paper/Blog Link My Issue

#ComputerVision #Pocket #NLP #MultiModal #DiffusionModel #SSM (StateSpaceModel) #UMM Issue Date: 2025-10-21 GPT Summary- MDM(Multi-modal Diffusion Mamba)という新しいアーキテクチャを提案し、エンドツーエンドのマルチモーダル処理を統一。Mambaベースの選択拡散モデルを用いて、エンコーディングとデコーディングでモダリティ特有の情報を段階的に生成。高解像度画像とテキストを同時に生成し、既存モデルを大幅に上回る性能を示す。計算効率を保ちながらマルチモーダルプロセスを統一する新たな方向性を確立。 Comment

元ポスト:

[Paper Note] Cautious Weight Decay, Lizhang Chen+, arXiv'25, 2025.10

Paper/Blog Link My Issue

#NeuralNetwork #Pocket #NLP #LanguageModel #Transformer #Optimizer Issue Date: 2025-10-16 GPT Summary- Cautious Weight Decay(CWD)は、オプティマイザに依存しない修正で、更新と符号が一致するパラメータにのみウェイト減衰を適用します。これにより、元の損失を保持しつつ、局所的なパレート最適点を探索可能にします。CWDは、既存のオプティマイザに簡単に適用でき、新たなハイパーパラメータを必要とせず、言語モデルの事前学習やImageNet分類で損失と精度を向上させます。 Comment

元ポスト:

[Paper Note] How Reinforcement Learning After Next-Token Prediction Facilitates Learning, Nikolaos Tsilivis+, arXiv'25, 2025.10

Paper/Blog Link My Issue

#Analysis #Pocket #NLP #Transformer #ReinforcementLearning #Reasoning #PostTraining #read-later Issue Date: 2025-10-14 GPT Summary- 大規模言語モデルの次のトークン予測を強化学習で最適化するフレームワークを提案。特に、短いおよび長い「思考の連鎖」シーケンスからの学習を通じて、強化学習が次のトークン予測を改善することを理論的に示す。長いシーケンスが稀な場合、強化学習により自己回帰型トランスフォーマーが一般化できることを確認。さらに、長い応答が計算を増加させるメカニズムを説明し、自己回帰型線形モデルが効率的に$d$ビットの偶奇を予測できる条件を理論的に証明。Llamaシリーズモデルのポストトレーニングによる実証も行う。 Comment

元ポスト:

[Paper Note] ArcMemo: Abstract Reasoning Composition with Lifelong LLM Memory, Matthew Ho+, arXiv'25, 2025.09

Paper/Blog Link My Issue

#Pocket #NLP #Abstractive #LanguageModel #Reasoning #Generalization #memory #One-Line Notes #Test-time Learning Issue Date: 2025-10-13 GPT Summary- LLMは推論時に外部メモリを活用し、概念レベルのメモリを導入することで、再利用可能でスケーラブルな知識の保存を実現。これにより、関連する概念を選択的に取得し、テスト時の継続的学習を可能にする。評価はARC-AGIベンチマークで行い、メモリなしのベースラインに対して7.5%の性能向上を達成。動的なメモリ更新が自己改善を促進することを示唆。 Comment

元ポスト:

ARC-AGIでしか評価されていないように見える。

[Paper Note] Dual Goal Representations, Seohong Park+, arXiv'25, 2025.10

Paper/Blog Link My Issue

#Pocket #ReinforcementLearning Issue Date: 2025-10-11 GPT Summary- 本研究では、目標条件付き強化学習のために二重目標表現を提案し、状態を時間的距離の集合として特徴付ける。この表現は環境の内的ダイナミクスに依存し、外部ノイズをフィルタリングしつつ最適なポリシーを回復するのに十分な情報を提供する。実験により、二重目標表現がOGBenchタスクスイートにおいてオフラインの目標到達性能を向上させることを示した。 Comment

pj page: https://seohong.me/blog/dual-representations/

元ポスト:

ゴールを明示的に与えるRLにおいて(Goal conditioned RLと呼ぶらしい, pi(a|s,g)、つまりアクションが状態とゴールから決まる設定)、ゴールgを表現する際に有用なrepresentation方法の提案(ある状態sを定義する際に状態sそのものの情報を使うのではなく、他のとりうる状態からのtemporal distance(何ステップで到達できるか)のベクトルで表現する)らしい。

たとえば、gはロボットであれば到達したい特定の座標であり、sは現在の座標、のようなイメージだろうか。

解説:

[Paper Note] Better Together: Leveraging Unpaired Multimodal Data for Stronger Unimodal Models, Sharut Gupta+, arXiv'25, 2025.10

Paper/Blog Link My Issue

#Pretraining #Pocket #MultiModal #UMM #One-Line Notes Issue Date: 2025-10-10 GPT Summary- UML(Unpaired Multimodal Learner)を提案し、非ペアのマルチモーダルデータを活用して表現学習を強化する新しいトレーニングパラダイムを示す。異なるモダリティからの入力を交互に処理し、明示的なペアを必要とせずにクロスモーダル構造から利益を得る。実験により、テキスト、音声、画像などの非ペアデータを用いることで、単一モダルターゲットのパフォーマンスが向上することを確認。 Comment

pj page: https://unpaired-multimodal.github.io

モダリティ間で(モダリティごとのエンコーダとデコーダ以外の)パラメータを共有し(UMMs)、通常はpair-dataで学習するが、unpaired data(+self-supervised / 分類ヘッドを用いた(ここはしっかり読めてないので自信ない)supervised learning)で学習する。これによりダウンストリームタスクでの性能が向上する。

unpaired dataで学習するという点が革新的に見える。unpaired dataで学習する枠組みにより大量のデータを活用し表現を学習できる。また、ペアデータで学習することによりパラメータに埋め込める知識やスキルが(おそらく)限られていたが、より広範な知識やスキルを埋め込めるのでは、という印象がある。

元ポスト:

著者ポスト:

[Paper Note] DiffusionNFT: Online Diffusion Reinforcement with Forward Process, Kaiwen Zheng+, arXiv'25, 2025.09

Paper/Blog Link My Issue

#ComputerVision #Pocket #ReinforcementLearning #DiffusionModel #FlowMatching Issue Date: 2025-10-10 GPT Summary- Diffusion Negative-aware FineTuning(DiffusionNFT)は、オンライン強化学習を用いて拡散モデルを最適化する新しい手法で、ポジティブとネガティブな生成を対比させることで強化信号を組み込みます。このアプローチにより、尤度推定が不要になり、クリーンな画像のみでポリシー最適化が可能になります。DiffusionNFTは、FlowGRPOよりも最大25倍効率的で、GenEvalスコアを短期間で大幅に改善し、複数の報酬モデルを活用することでSD3.5-Mediumのパフォーマンスを向上させます。 Comment

元ポスト:

ベースライン:

- Introducing Stable Diffusion 3.5, StabilityAI, 2024.10

- [Paper Note] Flow-GRPO: Training Flow Matching Models via Online RL, Jie Liu+, NeurIPS'25, 2025.05

- [Paper Note] Classifier-Free Diffusion Guidance, Jonathan Ho+, arXiv'22, 2022.07

[Paper Note] Provable Scaling Laws of Feature Emergence from Learning Dynamics of Grokking, Yuandong Tian, arXiv'25, 2025.09

Paper/Blog Link My Issue

#NeuralNetwork #Analysis #Pocket #Grokking #Optimizer Issue Date: 2025-10-10 GPT Summary- grokkingの現象を理解するために、2層の非線形ネットワークにおける新しい枠組み$\mathbf{Li_2}$を提案。これには、怠惰な学習、独立した特徴学習、相互作用する特徴学習の3段階が含まれる。怠惰な学習では、モデルが隠れ表現に過剰適合し、独立した特徴が学習される。後半段階では、隠れノードが相互作用を始め、学習すべき特徴に焦点を当てることが示される。本研究は、grokkingにおけるハイパーパラメータの役割を明らかにし、特徴の出現と一般化に関するスケーリング法則を導出する。 Comment

元ポスト:

[Paper Note] Attention Sinks and Compression Valleys in LLMs are Two Sides of the Same Coin, Enrique Queipo-de-Llano+, arXiv'25, 2025.10

Paper/Blog Link My Issue

#Analysis #Pocket #NLP #Transformer #Attention #AttentionSinks #CompressionValleys Issue Date: 2025-10-10 GPT Summary- 注意の沈降と圧縮の谷の関連性を示し、大規模な活性化が表現の圧縮とエントロピーの減少を引き起こすことを理論的に証明。実験により、シーケンスの開始トークンが中間層で極端な活性化を生むと、圧縮の谷と注意の沈降が同時に現れることを確認。TransformerベースのLLMがトークンを三つのフェーズで処理する「Mix-Compress-Refine」理論を提案し、タスク依存の表現の違いを説明。 Comment

元ポスト:

[Paper Note] Gaussian Embeddings: How JEPAs Secretly Learn Your Data Density, Randall Balestriero+, arXiv'25, 2025.10

Paper/Blog Link My Issue

#ComputerVision #Embeddings #Pocket #read-later Issue Date: 2025-10-09 GPT Summary- JEPAは、潜在空間予測と反収束を組み合わせたアーキテクチャで、データ密度を推定する能力を持つ。成功裏に訓練されたJEPAは、データキュレーションや外れ値検出に利用可能で、サンプルの確率を効率的に計算できる。JEPA-SCOREと呼ばれる手法を用いて、さまざまなデータセットや自己教師あり学習手法でその効果が実証されている。 Comment

元ポスト:

ポイント解説:

[Paper Note] Muon Outperforms Adam in Tail-End Associative Memory Learning, Shuche Wang+, arXiv'25, 2025.09

Paper/Blog Link My Issue

#Analysis #Pocket #NLP #LanguageModel #Optimizer Issue Date: 2025-10-08 GPT Summary- Muonオプティマイザーは、LLMsのトレーニングにおいてAdamよりも高速であり、そのメカニズムを連想記憶の観点から解明。VOアテンションウェイトとFFNがMuonの優位性の要因であり、重い尾を持つデータにおいて尾クラスを効果的に最適化する。Muonは一貫したバランスの取れた学習を実現し、Adamは不均衡を引き起こす可能性がある。これにより、Muonの更新ルールが重い尾を持つ分布における効果的な学習を可能にすることが示された。 Comment

元ポスト:

[Paper Note] Evolution Strategies at Scale: LLM Fine-Tuning Beyond Reinforcement Learning, Xin Qiu+, arXiv'25, 2025.09

Paper/Blog Link My Issue

#Pocket #NLP #LanguageModel #Finetuning #EvolutionaryAlgorithm Issue Date: 2025-10-07 GPT Summary- 進化戦略(ES)を用いて、事前学習済みの大規模言語モデル(LLMs)の全パラメータをファインチューニングする初の成功事例を報告。ESは数十億のパラメータに対して効率的に探索でき、サンプル効率やロバスト性、パフォーマンスの安定性において既存の強化学習(RL)手法を上回ることを示す。これにより、LLMファインチューニングの新たな方向性が開かれる。 Comment

元ポスト:

続報:

[Paper Note] Visual Instruction Bottleneck Tuning, Changdae Oh+, NeurIPS'25, 2025.05

Paper/Blog Link My Issue

#ComputerVision #Pocket #NLP #LanguageModel #MultiModal #NeurIPS #PostTraining #OOD #Generalization Issue Date: 2025-10-05 GPT Summary- MLLMは未知のクエリに対して性能が低下するが、既存の改善策は多くのデータや計算コストを要する。本研究では、情報ボトルネック原理に基づき、MLLMの堅牢性を向上させるためのVittleを提案。45のデータセットでの実証実験により、VittleがMLLMの堅牢性を一貫して改善することを示した。 Comment

元ポスト:

[Paper Note] How Diffusion Models Memorize, Juyeop Kim+, arXiv'25, 2025.09

Paper/Blog Link My Issue

#Analysis #Pocket #DiffusionModel #Memorization Issue Date: 2025-10-04 GPT Summary- 拡散モデルは画像生成に成功しているが、トレーニングデータの記憶によるプライバシーや著作権の懸念がある。本研究では、拡散およびデノイジングプロセスを再考し、記憶のメカニズムを探る。記憶は初期のデノイジング中にトレーニングサンプルの過大評価によって引き起こされ、多様性が減少し、記憶された画像への収束が加速されることを示す。具体的には、過学習だけでなく、分類器フリーのガイダンスが記憶を増幅し、トレーニング損失が増加すること、記憶されたプロンプトがノイズ予測に影響を与えること、初期のランダム性が抑制される様子が明らかになる。これにより、過大評価が記憶の中心的なメカニズムであることが特定される。 Comment

関連:

- [Paper Note] Selective Underfitting in Diffusion Models, Kiwhan Song+, arXiv'25, 2025.10

[Paper Note] Selective Underfitting in Diffusion Models, Kiwhan Song+, arXiv'25, 2025.10

Paper/Blog Link My Issue

#Analysis #Pocket #DiffusionModel #Memorization #Generalization Issue Date: 2025-10-04 GPT Summary- 拡散モデルは生成モデルの主要なパラダイムとして注目されているが、どのスコアを学習しているかが未解決の疑問である。本研究では、選択的過少適合の概念を導入し、拡散モデルが特定の領域でスコアを正確に近似し、他の領域では過少適合することを示す。これにより、拡散モデルの一般化能力と生成性能に関する新たな洞察を提供する。 Comment

元ポスト:

ポイント解説:

著者ポスト:

[Paper Note] Continuous Thought Machines, Luke Darlow+, NeurIPS'25 Spotlight, 2025.05

Paper/Blog Link My Issue

#NeuralNetwork #Pocket #Architecture #NeurIPS #read-later Issue Date: 2025-09-28 GPT Summary- 本論文では、神経細胞のタイミングと相互作用を重視した「Continuous Thought Machine(CTM)」を提案し、神経ダイナミクスをコア表現として活用することで深層学習の限界に挑戦します。CTMは、神経レベルの時間的処理と神経同期を取り入れ、計算効率と生物学的リアリズムのバランスを図ります。さまざまなタスクにおいて強力なパフォーマンスを示し、適応的な計算を活用することで、タスクの難易度に応じた効率的な処理が可能です。CTMは、より生物学的に妥当な人工知能システムの開発に向けた重要なステップと位置付けられています。 Comment

元ポスト:

NeurIPS'25 Spotlight:

https://www.linkedin.com/posts/sakana-ai_neurips2025-neurips2025-activity-7380889531815923712-94pk?utm_source=share&utm_medium=member_ios&rcm=ACoAACzQvjwB2FeLVE3yukDiUYtr5J4k-6nlNG4

[Paper Note] Angles Don't Lie: Unlocking Training-Efficient RL Through the Model's Own Signals, Qinsi Wang+, NeurIPS'25 Spotlight, 2025.06

Paper/Blog Link My Issue

#EfficiencyImprovement #Pocket #NLP #ReinforcementLearning #NeurIPS #PostTraining #On-Policy Issue Date: 2025-09-27 GPT Summary- 大規模言語モデル(LLMs)の強化学習微調整(RFT)におけるサンプル効率の低下を改善するため、モデル固有の信号「角度集中」を特定。これに基づき、勾配駆動型角度情報ナビゲート強化学習フレームワーク(GAIN-RL)を提案し、トレーニングデータを動的に選択することで効率を向上。実証評価では、GAIN-RLがトレーニング効率を2.5倍以上向上させ、元のデータの半分でより良いパフォーマンスを達成したことが示された。 Comment

元ポスト:

ヒューリスティックや特定の難易度に基づくラベルからRLのサンプルをサンプリングするのではなく、モデル自身の現在の学習の状態に基づいて動的に選択し学習効率を向上させるアプローチな模様。

[Paper Note] STAR: Synthesis of Tailored Architectures, Armin W. Thomas+, ICLR'25, 2024.11

Paper/Blog Link My Issue

#NeuralNetwork #Pocket #NLP #NeuralArchitectureSearch #ICLR Issue Date: 2025-09-27 GPT Summary- 新しいアプローチ(STAR)を提案し、特化したアーキテクチャの合成を行う。線形入力変動システムに基づく探索空間を用い、アーキテクチャのゲノムを階層的にエンコード。進化的アルゴリズムでモデルの品質と効率を最適化し、自己回帰型言語モデリングにおいて従来のモデルを上回る性能を達成。 Comment

openreview: https://openreview.net/forum?id=HsHxSN23rM

[Paper Note] Massive Values in Self-Attention Modules are the Key to Contextual Knowledge Understanding, Mingyu Jin+, ICML'25, 2025.02

Paper/Blog Link My Issue

#Analysis #Pocket #NLP #Transformer #Attention #ICML #ContextEngineering Issue Date: 2025-09-26 GPT Summary- 大規模言語モデル(LLMs)は文脈的知識の理解に成功しており、特に注意クエリ(Q)とキー(K)において集中した大規模な値が一貫して現れることを示す。これらの値は、モデルのパラメータに保存された知識ではなく、現在の文脈から得られる知識の解釈に重要である。量子化戦略の調査により、これらの値を無視すると性能が低下することが明らかになり、集中した大規模な値の出現がロタリーポジショナルエンコーディング(RoPE)によって引き起こされることを発見した。これらの結果は、LLMの設計と最適化に関する新たな洞察を提供する。 Comment

openreview: https://openreview.net/forum?id=1SMcxxQiSL¬eId=7BAXSETAwU

[Paper Note] Searching Latent Program Spaces, Matthew V Macfarlane+, NeurIPS'25, 2024.11

Paper/Blog Link My Issue

#NeuralNetwork #Pocket #Search #Coding #NeurIPS #Encoder-Decoder Issue Date: 2025-09-21 GPT Summary- 新しいスキルを効率的に習得し、一般化するためのLatent Program Network(LPN)を提案。LPNは、入力を出力にマッピングする潜在空間を学習し、テスト時に勾配を用いて探索。シンボリックアプローチの適応性とニューラル手法のスケーラビリティを兼ね備え、事前定義されたDSLを不要にする。ARC-AGIベンチマークでの実験により、LPNは分布外タスクでの性能を2倍に向上させることが示された。 Comment

元ポスト:

[Paper Note] The Illusion of Thinking: Understanding the Strengths and Limitations of Reasoning Models via the Lens of Problem Complexity, Parshin Shojaee+, arXiv'25

Paper/Blog Link My Issue

#Analysis #Pocket #NLP #LanguageModel #Reasoning #NeurIPS #read-later Issue Date: 2025-09-19 GPT Summary- LRMsは思考プロセスを生成するが、その能力や限界は未解明。評価は主に最終回答の正確性に焦点を当てており、推論の痕跡を提供しない。本研究では制御可能なパズル環境を用いて、LRMsの推論過程を分析。実験により、LRMsは特定の複雑さを超えると正確性が崩壊し、スケーリングの限界が明らかに。低複雑性では標準モデルが優位、中複雑性ではLRMsが優位、高複雑性では両者が崩壊することを示した。推論の痕跡を調査し、LRMsの強みと限界を明らかに。 Comment

元ポスト:

出た当初相当話題になったIllusion of thinkingがNeurIPSにacceptされた模様。Appendix A.1に当時のcriticismに対するレスポンスが記述されている。

[Paper Note] BREAD: Branched Rollouts from Expert Anchors Bridge SFT & RL for Reasoning, Xuechen Zhang+, NeurIPS'25

Paper/Blog Link My Issue

#Analysis #EfficiencyImprovement #Pocket #NLP #LanguageModel #Supervised-FineTuning (SFT) #ReinforcementLearning #SmallModel #NeurIPS #PostTraining #On-Policy Issue Date: 2025-09-19 GPT Summary- 小型言語モデル(SLMs)は、トレースが不足している場合に複雑な推論を学ぶのが難しい。本研究では、SFT + RLの限界を調査し、BREADという新しい手法を提案。BREADは、専門家のガイダンスを用いてSFTとRLを統合し、失敗したトレースに対して短いヒントを挿入することで成功を促進。これにより、トレーニングが約3倍速くなり、標準的なGRPOを上回る性能を示す。BREADは、SLMの推論能力を大幅に向上させることが確認された。 Comment

元ポスト:

[Paper Note] The Leaderboard Illusion, Shivalika Singh+, NeurIPS'25

Paper/Blog Link My Issue

#Analysis #Pocket #NLP #LanguageModel #Evaluation #NeurIPS #read-later #Selected Papers/Blogs Issue Date: 2025-09-19 GPT Summary- 進捗測定は科学の進展に不可欠であり、Chatbot ArenaはAIシステムのランキングにおいて重要な役割を果たしている。しかし、非公開のテスト慣行が存在し、特定のプロバイダーが有利になることで、スコアにバイアスが生じることが明らかになった。特に、MetaのLlama-4に関連するプライベートLLMバリアントが問題視され、データアクセスの非対称性が生じている。GoogleやOpenAIはArenaデータの大部分を占め、オープンウェイトモデルは少ないデータしか受け取っていない。これにより、Arena特有のダイナミクスへの過剰適合が発生している。研究は、Chatbot Arenaの評価フレームワークの改革と、公正で透明性のあるベンチマーキングの促進に向けた提言を行っている。 Comment

元ポスト:

要チェック

[Paper Note] Inpainting-Guided Policy Optimization for Diffusion Large Language Models, Siyan Zhao+, arXiv'25

Paper/Blog Link My Issue

#Pocket #NLP #LanguageModel #ReinforcementLearning #DiffusionModel #On-Policy #Inpainting Issue Date: 2025-09-19 GPT Summary- dLLMsはインペインティング能力を活用し、強化学習の探索課題を解決するIGPOフレームワークを提案。部分的な真実の推論トレースを挿入し、探索を有望な軌道に導く。これによりサンプル効率が向上し、GSM8K、Math500、AMCの数学ベンチマークで新たな最先端結果を達成。 Comment

元ポスト:

部分的にtraceの正解を与えると、正解の方向にバイアスがかかるので多様性が犠牲になる気もするが、その辺はどうなんだろうか。

[Paper Note] The Information Dynamics of Generative Diffusion, Luca Ambrogioni, arXiv'25

Paper/Blog Link My Issue

#Analysis #Pocket #DiffusionModel Issue Date: 2025-09-05 GPT Summary- 生成的拡散モデルの統一的な理論的理解を提供し、動的特性、情報理論的特性、熱力学的特性を結びつける。生成帯域幅はスコア関数の発散によって支配され、生成プロセスは対称性の破れによって駆動される。スコア関数はノイズの帯域幅を調整するフィルターとして機能する。 Comment

元ポスト:

[Paper Note] Compute-Optimal Scaling for Value-Based Deep RL, Preston Fu+, arXiv'25

Paper/Blog Link My Issue

#NeuralNetwork #Pocket #ReinforcementLearning #Scaling Laws #read-later #Batch Issue Date: 2025-09-04 GPT Summary- 強化学習における計算スケーリングを調査し、モデル容量とデータ更新比率のリソース配分がサンプル効率に与える影響を分析。特に、バッチサイズの増加が小さなモデルでQ関数の精度を悪化させる「TDオーバーフィッティング」を特定し、大きなモデルではこの影響が見られないことを示す。計算使用を最適化するためのガイドラインを提供し、深層RLのスケーリングに関する基盤を築く。 Comment

元ポスト:

[Paper Note] Training Dynamics of the Cooldown Stage in Warmup-Stable-Decay Learning Rate Scheduler, Aleksandr Dremov+, TMLR'25

Paper/Blog Link My Issue

#Analysis #Pocket #NLP #LanguageModel #Transformer #TMLR #Scheduler Issue Date: 2025-09-03 GPT Summary- WSD学習率スケジューラのクールダウンフェーズを分析し、異なる形状がモデルのバイアス-バリアンスのトレードオフに与える影響を明らかに。探索と活用のバランスが最適なパフォーマンスをもたらすことを示し、特に$\beta_2$の値が高いと改善が見られる。損失のランドスケープを視覚化し、クールダウンフェーズの最適化の重要性を強調。 Comment

元ポスト:

[Paper Note] Looped Transformers for Length Generalization, Ying Fan+, ICLR'25

Paper/Blog Link My Issue

#Pocket #Transformer #LongSequence #Architecture #ICLR #Generalization #RecurrentModels Issue Date: 2025-08-30 GPT Summary- ループトランスフォーマーを用いることで、未見の長さの入力に対する算術的およびアルゴリズム的タスクの長さ一般化が改善されることを示す。RASP-L操作を含む既知の反復解法に焦点を当て、提案する学習アルゴリズムで訓練した結果、さまざまなタスクに対して高い一般化能力を持つ解法を学習した。 Comment

openreview: https://openreview.net/forum?id=2edigk8yoU

[Paper Note] Pushing the Envelope of LLM Inference on AI-PC, Evangelos Georganas+, arXiv'25

Paper/Blog Link My Issue

#EfficiencyImprovement #Pocket #LanguageModel #Inference Issue Date: 2025-08-24 GPT Summary- 超低ビットLLMモデルの登場により、リソース制約のある環境でのLLM推論が可能に。1ビットおよび2ビットのマイクロカーネルを設計し、PyTorch-TPPに統合することで、推論効率を最大2.2倍向上。これにより、AI PCやエッジデバイスでの超低ビットLLMモデルの効率的な展開が期待される。 Comment

元ポスト:

[Paper Note] Optimas: Optimizing Compound AI Systems with Globally Aligned Local Rewards, Shirley Wu+, arXiv'25

Paper/Blog Link My Issue

#Pocket #LanguageModel #RewardModel #CompoundAISystemsOptimization Issue Date: 2025-08-15 GPT Summary- 複合AIシステムの最適化のために、統一フレームワークOptimasを提案。各コンポーネントにローカル報酬関数を維持し、グローバルパフォーマンスと整合性を保ちながら同時に最大化。これにより、異種構成の独立した更新が可能となり、平均11.92%の性能向上を実現。 Comment

元ポスト:

framework: https://github.com/snap-stanford/optimas

複数のコンポーネントのパイプラインによって構成されるシステムがあったときに、パイプライン全体のパフォーマンスを改善したい。このとき、パイプライン全体のパフォーマンスをユーザが定義したGlobal Reward Functionを最大化するように最適化したい。しかし、多くの場合このような異種のコンポーネントが複雑に連携したパイプラインでは、global rewardsは微分不可能なので、end-to-endで最適化することが難しい。また、個々の異種のコンポーネントのコンフィグ(e.g., textual, numerical, continuous vs. discrete)を同時に最適化することがそもそも難しい。全体のAIシステムを動作させて、global rewardを最適化するのは非常にコストがかかる。先行研究では、特定のコンポーネントを別々に最適化してきた(たとえば、promptをフィードバックに基づいて改善する Large Language Models as Optimizers, Chengrun Yang+, N/A, ICLR'24

, モデル選択をiterative searchで改善するなど)。が、個別のコンポーネントを最適化しても別のコンポーネントの最適化が不十分であれば全体の性能は向上せず、全てのコンポーネントを個別に最適化しても、相互作用が最適ではない場合はglobal rewardが最大化されない可能性がある。

このため、個々のコンポーネントにlocal reward function (LRFs)を定義する。local reward functionは、これらが改善することでglobal reward functionも改善することを保証するような形(local-global alignment properfy)で定義され、これらのlocal reward functionを異なるコンポーネントごとに異なる形で最適化しても、global reward functionが改善されるように学習する。個々のコンポーネントごとにLRFsを最適化することは、全体のシステムの実行回数を削減しながら高いglobal rewardを実現可能となる。加えて、他のコンポーネントのコンフィグが改善されたら、それらに適応してLRFsも改善されていく必要があるので lightweight adaptationと呼ばれる、システムからサンプリングされた最小のデータからLRFsをアップデートする手法も提案する、みたいな話な模様。

LRFsを定義するときは、共通のLLMをバックボーンとし、個々のコンポーネントに対して別々のヘッドを用意してrewardを出力するようなモデルを定義する。コンポーネントkのinput x, output y が与えられたときに、それらをconcatしてLLMに入力し[x_k, y_k]最終的にヘッドでスカラー値に写像する。また、LRF r_kが *aligned* の定義として、LRF r_kがある共通のinputに対してr_kが高くなるようなoutputをしたときに、downstreamのコンポーネント全体のglobal reward Rが同等以上の性能を達成する場合、alignedであると定義する。このような特性を実現するために、現行のシステムのコンフィグに基づいてそれぞれのコンポーネントを実行し、trajectoryを取得。特定のコンポーネントC_kに対する二つのoutputを(異なるコンフィグに基づいて)サンプリングしてパイプライン全体のmetricを予測し、metricが高い/低いサンプルをchosen/rejectedとし preference dataを用意する。このようなデータを用いて、個々のコンポーネントのLRFsを、chosenなサンプルの場合はrejectedよりもrewardが高くなるようにペアワイズのranking lossを用いて学習する。

(ここまでが4.1節の概要。4.2, 4.3節以後は必要に応じて参照する。4.2ではどのように他コンポーネントが更新された際にLRFsを更新するか、という話と、4.3節では個々のコンポーネントがtext, trainable models, continuous configurationなどの異なるコンポーネントの場合にどのような最適化手法を適用するか、といった話が書かれているように見える。)

評価では5つの実世界のタスクを実現するための複数コンポーネントで構成されるシステムの最適化を試みているようであり、

提案手法によって、パイプライン全体の性能がベースラインと比べて改善しシステム全体の実行回数もベースラインと比較して少ない試行回数で済むことが示されている模様。

[Paper Note] MLE-STAR: Machine Learning Engineering Agent via Search and Targeted Refinement, Jaehyun Nam+, arXiv'25

Paper/Blog Link My Issue

#Pocket #NLP #LanguageModel Issue Date: 2025-08-04 GPT Summary- MLE-STARは、LLMを用いてMLモデルを自動実装する新しいアプローチで、ウェブから効果的なモデルを取得し、特定のMLコンポーネントに焦点を当てた戦略を探索することで、コード生成の精度を向上させる。実験結果では、MLE-STARがKaggleコンペティションの64%でメダルを獲得し、他の手法を大きく上回る性能を示した。 Comment

元ポスト:

[Paper Note] What Matters in Learning from Large-Scale Datasets for Robot Manipulation, Vaibhav Saxena+, ICLR'25

Paper/Blog Link My Issue

#Analysis #Pocket #Dataset #ICLR #Robotics #EmbodiedAI Issue Date: 2025-07-19 GPT Summary- 本研究では、ロボティクスにおける大規模データセットの構成に関する体系的な理解を深めるため、データ生成フレームワークを開発し、多様性の重要な要素を特定。特に、カメラのポーズや空間的配置がデータ収集の多様性と整合性に影響を与えることを示した。シミュレーションからの洞察が実世界でも有効であり、提案した取得戦略は既存のトレーニング手法を最大70%上回る性能を発揮した。 Comment

元ポスト:

元ポストに著者による詳細な解説スレッドがあるので参照のこと。

[Paper Note] Learning distributed representations with efficient SoftMax normalization, Lorenzo Dall'Amico+, TMLR'25

Paper/Blog Link My Issue

#Embeddings #Pocket #RepresentationLearning Issue Date: 2025-07-16 GPT Summary- 埋め込みを学習するための損失関数として${\rm SoftMax}(XY^T)$を最適化する際の計算負荷を軽減するため、ノルム制限された埋め込みベクトルに対して線形時間のヒューリスティック近似を提案。提案手法は、事前学習されたデータセットで高い精度を示し、クロスエントロピーを最適化する効率的なアルゴリズムを設計。これにより、解釈可能でタスクに依存しない埋め込み学習が可能となり、類似の「2Vec」アルゴリズムと比較して優れた性能と低い計算時間を実現。 Comment

openreview: https://openreview.net/forum?id=9M4NKMZOPu

[Paper Note] In-context denoising with one-layer transformers: connections between attention and associative memory retrieval, Matthew Smart+, arXiv'25

Paper/Blog Link My Issue

#Analysis #Pocket #NLP #Transformer #In-ContextLearning Issue Date: 2025-07-16 GPT Summary- 「インコンテキストデノイジング」というタスクを通じて、注意ベースのアーキテクチャと密な連想記憶(DAM)ネットワークの関係を探求。ベイズ的フレームワークを用いて、単層トランスフォーマーが特定のデノイジング問題を最適に解決できることを示す。訓練された注意層は、コンテキストトークンを連想記憶として利用し、デノイジングプロンプトを一回の勾配降下更新で処理。これにより、DAMネットワークの新たな拡張例を提供し、連想記憶と注意メカニズムの関連性を強化する。 Comment

元ポスト:

[Paper Note] Learning-Order Autoregressive Models with Application to Molecular Graph Generation, Zhe Wang+, ICML'25

Paper/Blog Link My Issue

#NeuralNetwork #Pocket #ICML #GraphGeneration Issue Date: 2025-07-16 GPT Summary- 自己回帰モデル(ARMs)を用いて、データから逐次的に推測される確率的順序を利用し、高次元データを生成する新しい手法を提案。トレーニング可能なオーダーポリシーを組み込み、対数尤度の変分下限を用いて最適化。実験により、画像生成やグラフ生成で意味のある自己回帰順序を学習し、分子グラフ生成ではQM9およびZINC250kベンチマークで最先端の結果を達成。 Comment

元ポスト:

openreview: https://openreview.net/forum?id=EY6pXIDi3G

[Paper Note] Score Matching With Missing Data, Josh Givens+, ICML'25

Paper/Blog Link My Issue

#Pocket #ICML Issue Date: 2025-07-15 GPT Summary- スコアマッチングはデータ分布学習の重要な手法ですが、不完全データへの適用は未研究です。本研究では、部分的に欠損したデータに対するスコアマッチングの適応を目指し、重要度重み付け(IW)アプローチと変分アプローチの2つのバリエーションを提案します。IWアプローチは有限サンプル境界を示し、小さなサンプルでの強力な性能を確認。変分アプローチは高次元設定でのグラフィカルモデル推定において優れた性能を発揮します。 Comment

openreview: https://openreview.net/forum?id=mBstuGUaXo

ICML'25 outstanding papers

解説:

[Paper Note] Muon is Scalable for LLM Training, Jingyuan Liu+, arXiv'25

Paper/Blog Link My Issue

#Pocket #NLP #LanguageModel #Optimizer #read-later #Selected Papers/Blogs Issue Date: 2025-07-14 GPT Summary- Muonオプティマイザーを大規模モデルにスケールアップするために、ウェイトデケイとパラメータごとの更新スケール調整を導入。これにより、Muonは大規模トレーニングで即座に機能し、計算効率がAdamWの約2倍に向上。新たに提案するMoonlightモデルは、少ないトレーニングFLOPで優れたパフォーマンスを達成し、オープンソースの分散Muon実装や事前トレーニング済みモデルも公開。 Comment

解説ポスト:

こちらでも紹介されている:

- きみはNanoGPT speedrunを知っているか?, PredNext, 2025.07

解説:

[Paper Note] Nonlinear transformers can perform inference-time feature learning, Nishikawa+, ICML'25

Paper/Blog Link My Issue

#Analysis #NLP #Transformer #In-ContextLearning #ICML Issue Date: 2025-07-13 GPT Summary- 事前学習されたトランスフォーマーは、推論時に特徴を学習する能力を持ち、特に単一インデックスモデルにおける文脈内学習に焦点を当てています。勾配ベースの最適化により、異なるプロンプトからターゲット特徴を抽出し、非適応的アルゴリズムを上回る統計的効率を示します。また、推論時のサンプル複雑性が相関統計クエリの下限を超えることも確認されました。 Comment

元ポスト:

[Paper Note] Not All Explanations for Deep Learning Phenomena Are Equally Valuable, Alan Jeffares+, ICML'25

Paper/Blog Link My Issue

#NeuralNetwork #Pocket #ICML #LearningPhenomena Issue Date: 2025-07-11 GPT Summary- 深層学習の驚くべき現象(ダブルディセント、グロッキングなど)を孤立したケースとして説明することには限界があり、実世界のアプリケーションにはほとんど現れないと主張。これらの現象は、深層学習の一般的な原則を洗練するための研究価値があると提案し、研究コミュニティのアプローチを再考する必要性を示唆。最終的な実用的目標に整合するための推奨事項も提案。 Comment

元ポスト:

関連:

- [Paper Note] Deep Double Descent: Where Bigger Models and More Data Hurt, Preetum Nakkiran+, ICLR'20

- GROKKING: GENERALIZATION BEYOND OVERFIT- TING ON SMALL ALGORITHMIC DATASETS, Power+, ICLR'21 Workshop

- [Paper Note] The Lottery Ticket Hypothesis: Finding Sparse, Trainable Neural Networks, Jonathan Frankle+, ICLR'19

[Paper Note] Mixture of Experts Provably Detect and Learn the Latent Cluster Structure in Gradient-Based Learning, Ryotaro Kawata+, ICML'25

Paper/Blog Link My Issue

#NeuralNetwork #Analysis #Pocket #MoE(Mixture-of-Experts) #ICML Issue Date: 2025-07-11 GPT Summary- Mixture of Experts (MoE)は、入力を専門家に動的に分配するモデルのアンサンブルであり、機械学習で成功を収めているが、その理論的理解は遅れている。本研究では、MoEのサンプルおよび実行時間の複雑さを回帰タスクにおけるクラスタ構造を通じて理論的に分析し、バニラニューラルネットワークがこの構造を検出できない理由を示す。MoEは各専門家の能力を活用し、問題をより単純なサブ問題に分割することで、非線形回帰におけるSGDのダイナミクスを探求する初めての試みである。 Comment

元ポスト:

[Paper Note] Energy-Based Transformers are Scalable Learners and Thinkers, Alexi Gladstone+, arXiv'25

Paper/Blog Link My Issue

#ComputerVision #Pocket #NLP #LanguageModel #Transformer #MultiModal #Architecture #VideoGeneration/Understandings #VisionLanguageModel Issue Date: 2025-07-06 GPT Summary- エネルギーベースのトランスフォーマー(EBTs)を用いて、無監督学習から思考を学ぶモデルを提案。EBTsは、入力と候補予測の互換性を検証し、エネルギー最小化を通じて予測を行う。トレーニング中に従来のアプローチよりも高いスケーリング率を達成し、言語タスクでの性能を29%向上させ、画像のノイズ除去でも優れた結果を示す。EBTsは一般化能力が高く、モデルの学習能力と思考能力を向上させる新しいパラダイムである。 Comment

元ポスト:

Project Page: https://energy-based-transformers.github.io

First Authorの方による解説ポスト:

[Paper Note] Resa: Transparent Reasoning Models via SAEs, Shangshang Wang+, arXiv'25

Paper/Blog Link My Issue

#EfficiencyImprovement #Pocket #NLP #LanguageModel #Supervised-FineTuning (SFT) #PostTraining #read-later Issue Date: 2025-06-13 GPT Summary- Resaという1.5Bの推論モデル群を提案し、効率的なスパースオートエンコーダーチューニング(SAE-Tuning)手法を用いて訓練。これにより、97%以上の推論性能を保持しつつ、訓練コストを2000倍以上削減し、訓練時間を450倍以上短縮。軽いRL訓練を施したモデルで高い推論性能を実現し、抽出された推論能力は一般化可能かつモジュール化可能であることが示された。全ての成果物はオープンソース。 Comment

元ポスト:

著者ポスト:

論文中で利用されているSource Modelの一つ:

- [Paper Note] Tina: Tiny Reasoning Models via LoRA, Shangshang Wang+, arXiv'25

[Paper Note] Horizon Reduction Makes RL Scalable, Seohong Park+, arXiv'25

Paper/Blog Link My Issue

#Pocket #ReinforcementLearning Issue Date: 2025-06-10 GPT Summary- 本研究では、オフライン強化学習(RL)のスケーラビリティを検討し、既存のアルゴリズムが大規模データセットに対して期待通りの性能を発揮しないことを示しました。特に、長いホライズンがスケーリングの障壁であると仮定し、ホライズン削減技術がスケーラビリティを向上させることを実証しました。新たに提案した手法SHARSAは、ホライズンを削減しつつ優れたパフォーマンスを達成し、オフラインRLのスケーラビリティを向上させることを示しました。 Comment

元ポスト:

[Paper Note] Representation Shattering in Transformers: A Synthetic Study with Knowledge Editing, Kento Nishi+, ICML'25

Paper/Blog Link My Issue

#Pocket #NLP #LanguageModel #ICML #KnowledgeEditing Issue Date: 2025-06-10 GPT Summary- 知識編集(KE)アルゴリズムは、モデルの重みを変更して不正確な事実を更新するが、これがモデルの事実の想起精度や推論能力に悪影響を及ぼす可能性がある。新たに定義した合成タスクを通じて、KEがターゲットエンティティを超えて他のエンティティの表現に影響を与え、未見の知識の推論を歪める「表現の破壊」現象を示す。事前訓練されたモデルを用いた実験でもこの発見が確認され、KEがモデルの能力に悪影響を及ぼす理由を明らかにするメカニズム仮説を提供する。 Comment

元ポスト:

Model Merging in Pre-training of Large Language Models, Yunshui Li+, arXiv'25

Paper/Blog Link My Issue

#Pretraining #Pocket #NLP #LanguageModel #ModelMerge Issue Date: 2025-05-20 GPT Summary- モデルマージングは大規模言語モデルの強化に有望な技術であり、本論文ではその事前学習プロセスにおける包括的な調査を行う。実験により、一定の学習率で訓練されたチェックポイントをマージすることで性能向上とアニーリング挙動の予測が可能になることを示し、効率的なモデル開発と低コストのトレーニングに寄与する。マージ戦略やハイパーパラメータに関するアブレーション研究を通じて新たな洞察を提供し、実用的な事前学習ガイドラインをオープンソースコミュニティに提示する。 Comment

元ポスト:

解説ポスト:

Learning Dynamics of LLM Finetuning, Yi Ren+, ICLR'25

Paper/Blog Link My Issue

#Analysis #Pocket #NLP #LanguageModel #Alignment #Hallucination #ICLR #DPO #Repetition Issue Date: 2025-04-18 GPT Summary- 本研究では、大規模言語モデルのファインチューニング中の学習ダイナミクスを分析し、異なる応答間の影響の蓄積を段階的に解明します。指示調整と好み調整のアルゴリズムに関する観察を統一的に解釈し、ファインチューニング後の幻覚強化の理由を仮説的に説明します。また、オフポリシー直接好み最適化(DPO)における「圧縮効果」を強調し、望ましい出力の可能性が低下する現象を探ります。このフレームワークは、LLMのファインチューニング理解に新たな視点を提供し、アラインメント性能向上のためのシンプルな方法を示唆します。 Comment

元ポスト:

解説ポスト:

VAPO: Efficient and Reliable Reinforcement Learning for Advanced Reasoning Tasks, YuYue+, arXiv'25

Paper/Blog Link My Issue

#Pocket #LanguageModel #ReinforcementLearning #Reasoning #LongSequence Issue Date: 2025-04-08 GPT Summary- VAPO(Value-based Augmented Proximal Policy Optimization framework)を提案し、AIME 2024データセットで最先端のスコア60.4を達成。VAPOは他の手法を10ポイント以上上回り、5,000ステップで安定したパフォーマンスを示す。価値ベースの強化学習における3つの課題を特定し、VAPOがそれらを軽減する統合ソリューションを提供することで、長い思考過程の推論タスクの性能向上を実現。 Comment

同じくByteDanceの

- DAPO: An Open-Source LLM Reinforcement Learning System at Scale, Qiying Yu+, arXiv'25

を上回る性能

元ポスト:

[Paper Note] Understanding R1-Zero-Like Training: A Critical Perspective, Zichen Liu+, arXiv'25, 2025.03

Paper/Blog Link My Issue

#Pocket #NLP #LanguageModel #Reasoning #GRPO #read-later #KeyPoint Notes Issue Date: 2025-03-22 GPT Summary- DeepSeek-R1-Zeroは、RLを用いてLLMsの推論能力を向上させる手法を示した。本研究では、ベースモデルとRLの影響を分析し、DeepSeek-V3-Baseが「アハ体験」を示す一方で、Qwen2.5が強力な推論能力を持つことを発見。GRPOの最適化バイアスを特定し、Dr. GRPOを導入してトークン効率を改善。7BベースモデルでAIME 2024において43.3%の精度を達成するR1-Zeroレシピを提案。 Comment

関連研究:

- DAPO: An Open-Source LLM Reinforcement Learning System at Scale, Qiying Yu+, arXiv'25

解説ポスト:

解説ポスト(と論文中の当該部分)を読むと、

- オリジナルのGRPOの定式では2つのバイアスが生じる:

- response-level length bias: 1/|o_i| でAdvantageを除算しているが、これはAdvantageが負の場合(つまり、誤答が多い場合)「長い応答」のペナルティが小さくなるため、モデルが「長い応答」を好むバイアスが生じる。一方で、Advantageが正の場合(正答)は「短い応答」が好まれるようになる。

- question-level difficulty bias: グループ内の全ての応答に対するRewardのstdでAdvantageを除算しているが、stdが小さくなる問題(すなわち、簡単すぎるor難しすぎる問題)をより重視するような、問題に対する重みづけによるバイアスが生じる。

- aha moment(self-seflection)はRLによって初めて獲得されたものではなく、ベースモデルの時点で獲得されており、RLはその挙動を増長しているだけ(これはX上ですでにどこかで言及されていたなぁ)。

- これまではoutput lengthを増やすことが性能改善の鍵だと思われていたが、この論文では必ずしもそうではなく、self-reflection無しの方が有りの場合よりもAcc.が高い場合があることを示している(でもぱっと見グラフを見ると右肩上がりの傾向ではある)

といった知見がある模様

あとで読む

(参考)Dr.GRPOを実際にBig-MathとQwen-2.5-7Bに適用したら安定して収束したよというポスト:

DAPO: An Open-Source LLM Reinforcement Learning System at Scale, Qiying Yu+, arXiv'25

Paper/Blog Link My Issue

#Pocket #LanguageModel #ReinforcementLearning #Reasoning #LongSequence #GRPO #read-later #Selected Papers/Blogs #One-Line Notes #Reference Collection Issue Date: 2025-03-20 GPT Summary- 推論スケーリングによりLLMの推論能力が向上し、強化学習が複雑な推論を引き出す技術となる。しかし、最先端の技術詳細が隠されているため再現が難しい。そこで、$\textbf{DAPO}$アルゴリズムを提案し、Qwen2.5-32Bモデルを用いてAIME 2024で50ポイントを達成。成功のための4つの重要技術を公開し、トレーニングコードと処理済みデータセットをオープンソース化することで再現性を向上させ、今後の研究を支援する。 Comment

既存のreasoning modelのテクニカルレポートにおいて、スケーラブルなRLの学習で鍵となるレシピは隠されていると主張し、実際彼らのbaselineとしてGRPOを走らせたところ、DeepSeekから報告されているAIME2024での性能(47ポイント)よりもで 大幅に低い性能(30ポイント)しか到達できず、分析の結果3つの課題(entropy collapse, reward noise, training instability)を明らかにした(実際R1の結果を再現できない報告が多数報告されており、重要な訓練の詳細が隠されているとしている)。

その上で50%のtrainikg stepでDeepSeek-R1-Zero-Qwen-32Bと同等のAIME 2024での性能を達成できるDAPOを提案。そしてgapを埋めるためにオープンソース化するとのこと。

ちとこれはあとでしっかり読みたい。重要論文。

プロジェクトページ:

https://dapo-sia.github.io/

こちらにアルゴリズムの重要な部分の概要が説明されている。

解説ポスト:

コンパクトだが分かりやすくまとまっている。

下記ポストによると、Reward Scoreに多様性を持たせたい場合は3.2節参照とのこと。

すなわち、Dynamic Samplingの話で、Accが全ての生成で1.0あるいは0.0となるようなpromptを除外するといった方法の話だと思われる。

これは、あるpromptに対する全ての生成で正解/不正解になった場合、そのpromptに対するAdvantageが0となるため、ポリシーをupdateするためのgradientも0となる。そうすると、このサンプルはポリシーの更新に全く寄与しなくなるため、同バッチ内のノイズに対する頑健性が失われることになる。サンプル効率も低下する。特にAccが1.0になるようなpromptは学習が進むにつれて増加するため、バッチ内で学習に有効なpromptは減ることを意味し、gradientの分散の増加につながる、といったことらしい。

関連ポスト:

色々な研究で広く使われるのを見るようになった。

著者ポスト:

[Paper Note] Transformers without Normalization, Jiachen Zhu+, CVPR'25

Paper/Blog Link My Issue

#EfficiencyImprovement #Pocket #NLP #Transformer #Architecture #CVPR #Normalization Issue Date: 2025-03-14 GPT Summary- 本研究では、正規化層なしのトランスフォーマーがDynamic Tanh(DyT)を用いることで、同等またはそれ以上のパフォーマンスを達成できることを示します。DyTは、レイヤー正規化の代替として機能し、ハイパーパラメータの調整なしで効果を発揮します。多様な設定での実験により、正規化層の必要性に対する新たな洞察を提供します。 Comment

なん…だと…。LayerNormalizationを下記アルゴリズムのようなtanhを用いた超絶シンプルなレイヤー(parameterized thnh [Lecun氏ポスト](

同等以上の性能を維持しながらモデル全体のinference, trainingの時間を8%程度削減。

Native Sparse Attention: Hardware-Aligned and Natively Trainable Sparse Attention, Jingyang Yuan+, ACL'25

Paper/Blog Link My Issue

#EfficiencyImprovement #Pocket #NLP #LanguageModel #Attention #ACL #read-later Issue Date: 2025-03-02 GPT Summary- 長文コンテキストモデリングのために、計算効率を改善するスパースアテンションメカニズム「NSA」を提案。NSAは動的な階層スパース戦略を用い、トークン圧縮と選択を組み合わせてグローバルなコンテキスト認識とローカルな精度を両立。実装最適化によりスピードアップを実現し、エンドツーエンドのトレーニングを可能にすることで計算コストを削減。NSAはフルアテンションモデルと同等以上の性能を維持しつつ、長シーケンスに対して大幅なスピードアップを達成。 Comment

元ポスト:

ACL'25のBest Paperの一つ:

SFT Memorizes, RL Generalizes: A Comparative Study of Foundation Model Post-training, Tianzhe Chu+, ICML'25

Paper/Blog Link My Issue

#ComputerVision #Analysis #Pocket #NLP #LanguageModel #Supervised-FineTuning (SFT) #ReinforcementLearning #ICML #PostTraining #read-later #Selected Papers/Blogs Issue Date: 2025-01-30 GPT Summary- SFTとRLの一般化能力の違いを研究し、GeneralPointsとV-IRLを用いて評価。RLはルールベースのテキストと視覚変種に対して優れた一般化を示す一方、SFTは訓練データを記憶し分布外シナリオに苦労。RLは視覚認識能力を向上させるが、SFTはRL訓練に不可欠であり、出力形式を安定させることで性能向上を促進。これらの結果は、複雑なマルチモーダルタスクにおけるRLの一般化能力を示す。 Comment

元ポスト:

How Does Critical Batch Size Scale in Pre-training?, Hanlin Zhang+, ICLR'25

Paper/Blog Link My Issue

#NeuralNetwork #Pretraining #Pocket #NLP #LanguageModel #ICLR #Batch #One-Line Notes #CriticalBatchSize Issue Date: 2024-11-25 GPT Summary- 大規模モデルの訓練には、クリティカルバッチサイズ(CBS)を考慮した並列化戦略が重要である。CBSの測定法を提案し、C4データセットで自己回帰型言語モデルを訓練。バッチサイズや学習率などの要因を調整し、CBSがデータサイズに比例してスケールすることを示した。この結果は、ニューラルネットワークの理論的分析によって支持され、ハイパーパラメータ選択の重要性も強調されている。 Comment

Critical Batch Sizeはモデルサイズにはあまり依存せず、データサイズに応じてスケールする

Critical batch sizeが提案された研究:

- An Empirical Model of Large-Batch Training, Sam McCandlish+, arXiv'18

LBPE: Long-token-first Tokenization to Improve Large Language Models, Haoran Lian+, ICASSP'25, 2024.11

Paper/Blog Link My Issue

#Pretraining #Pocket #NLP #LanguageModel #Subword #Tokenizer #KeyPoint Notes Issue Date: 2024-11-12 GPT Summary- LBPEは、長いトークンを優先する新しいエンコーディング手法で、トークン化データセットにおける学習の不均衡を軽減します。実験により、LBPEは従来のBPEを一貫して上回る性能を示しました。 Comment

BPEとは異なりトークンの長さを優先してマージを実施することで、最終的なトークンを決定する手法で (Figure1),

BPEよりも高い性能を獲得し、

トークンの長さがBPEと比較して長くなり、かつ5Bトークン程度を既存のBPEで事前学習されたモデルに対して継続的事前学習するだけで性能を上回るようにでき (Table2)、同じVocabサイズでBPEよりも高い性能を獲得できる手法 (Table4)、らしい

[Paper Note] Transcoders Find Interpretable LLM Feature Circuits, Jacob Dunefsky+, arXiv'24, 2024.06

Paper/Blog Link My Issue

#NeuralNetwork #Pocket #NLP #LanguageModel #read-later #Selected Papers/Blogs #Transcoders #CircuitAnalysis #Interpretability Issue Date: 2025-12-21 GPT Summary- トランスコーダーを用いて、MLPサブレイヤーの回路分析を行い、スパースなMLPレイヤーでの忠実な近似を実現。これにより、入力依存項と入力不変項に因数分解された回路を得る。120Mから1.4Bパラメータの言語モデルで訓練し、SAEと同等の解釈可能性を確認。GPT2-smallの「greater-than circuit」に関する新たな洞察も得られた。トランスコーダーはMLPを含むモデル計算の解釈に効果的であることが示唆された。

[Paper Note] On-Policy Distillation of Language Models: Learning from Self-Generated Mistakes, Rishabh Agarwal+, ICLR'24, 2023.06

Paper/Blog Link My Issue

#NeuralNetwork #Pocket #NLP #Distillation #ICLR #Off-Policy #On-Policy #One-Line Notes Issue Date: 2025-10-30 GPT Summary- 一般化知識蒸留(GKD)は、教師モデルからのフィードバックを活用し、生徒モデルが自己生成した出力シーケンスで訓練する手法。これにより、出力シーケンスの分布不一致の問題を解決し、柔軟な損失関数の使用が可能になる。GKDは蒸留と強化学習の統合を促進し、要約、翻訳、算術推論タスクにおける自動回帰言語モデルの蒸留においてその有効性を示す。 Comment

openreview: https://openreview.net/forum?id=3zKtaqxLhW

- Unlocking On-Policy Distillation for Any Model Family, Patiño+, HuggingFace, 2025.10

での説明に基づくと、

オフポリシーの蒸留手法を使うと、教師モデルが生成した出力を用いて蒸留をするため、生徒モデルが実際に出力するcontextとは異なる出力に基づいて蒸留をするため、生徒モデルの推論時のcontextとのミスマッチが生じる課題があるが、オンポリシーデータを混ぜることでこの問題を緩和するような手法(つまり実際の生徒モデル運用時と似た状況で蒸留できる)。生徒モデルが賢くなるにつれて出力が高品質になるため、それらを学習データとして再利用することでpositiveなフィードバックループが形成されるという利点がある。また、強化学習と比較しても、SparseなReward Modelに依存せず、初期の性能が低いモデルに対しても適用できる利点があるとのこと(性能が低いと探索が進まない場合があるため)。

[Paper Note] WHEN DOES SECOND-ORDER OPTIMIZATION SPEED UP TRAINING?, Ishikawa+, ICLR'24 Tiny Paper

Paper/Blog Link My Issue

#NeuralNetwork #Analysis #Pocket #Optimizer Issue Date: 2025-10-28 GPT Summary- 二次最適化手法の使用が限られている理由を探り、特にバッチサイズとデータセットサイズに基づく条件を特定。実証的に、大きなバッチサイズと小さなデータセットサイズの組み合わせで二次最適化が一次最適化を上回ることを発見。 Comment

元ポスト:

[Paper Note] The Ultimate Guide to Fine-Tuning LLMs from Basics to Breakthroughs: An Exhaustive Review of Technologies, Research, Best Practices, Applied Research Challenges and Opportunities, Venkatesh Balavadhani Parthasarathy+, arXiv'24, 2024.08

Paper/Blog Link My Issue

#Tutorial #Pocket #NLP #LanguageModel #PostTraining Issue Date: 2025-10-17 GPT Summary- 本報告書では、大規模言語モデル(LLMs)のファインチューニングに関する理論と実践を統合的に検討し、歴史的な進化やファインチューニング手法の比較を行っています。7段階の構造化されたパイプラインを紹介し、不均衡データセットの管理やパラメータ効率の良い手法(LoRA、Half Fine-Tuning)に重点を置いています。また、PPOやDPOなどの新しいアプローチや、検証フレームワーク、デプロイ後のモニタリングについても議論し、マルチモーダルLLMsやプライバシー、説明責任に関する課題にも触れています。研究者や実務者に実用的な洞察を提供する内容です。 Comment

元ポスト:

[Paper Note] DoRA: Weight-Decomposed Low-Rank Adaptation, Shih-Yang Liu+, ICML'24, 2024.02

Paper/Blog Link My Issue

#Pocket #NLP #LanguageModel #PEFT(Adaptor/LoRA) #ICML #Selected Papers/Blogs #One-Line Notes Issue Date: 2025-10-10 GPT Summary- LoRAの精度ギャップを解消するために、Weight-Decomposed Low-Rank Adaptation(DoRA)を提案。DoRAは、ファインチューニングの重みを大きさと方向に分解し、方向性の更新にLoRAを使用することで、効率的にパラメータ数を最小化。これにより、LoRAの学習能力と安定性を向上させ、追加の推論コストを回避。さまざまな下流タスクでLoRAを上回る性能を示す。 Comment

日本語解説:

- LoRAの進化:基礎から最新のLoRA-Proまで , 松尾研究所テックブログ, 2025.09

- Tora: Torchtune-LoRA for RL, shangshang-wang, 2025.10

では、通常のLoRA, QLoRAだけでなく本手法でRLをする実装もサポートされている模様

[Paper Note] Looped Transformers are Better at Learning Learning Algorithms, Liu Yang+, ICLR'24

Paper/Blog Link My Issue

#Pocket #Transformer #Architecture #RecurrentModels Issue Date: 2025-08-30 GPT Summary- ループ型transformerアーキテクチャを提案し、従来のtransformerに反復的特性を組み込むことで、データフィッティング問題を解決。実験により、標準のtransformerと同等の性能を保ちながら、パラメータ数を10%未満に抑えることができることが示された。 Comment

openreview: https://openreview.net/forum?id=HHbRxoDTxE

[Paper Note] Beyond Human Data: Scaling Self-Training for Problem-Solving with Language Models, Avi Singh+, TMLR'24

Paper/Blog Link My Issue

#Pocket #ReinforcementLearning #TMLR Issue Date: 2025-06-14 GPT Summary- 言語モデルを人間データでファインチューニングする際の限界を超えるため、ReST$^{EM$という自己学習手法を提案。モデルから生成したサンプルをバイナリフィードバックでフィルタリングし、繰り返しファインチューニングを行う。PaLM-2モデルを用いた実験で、ReST$^{EM}$は人間データのみのファインチューニングを大幅に上回る性能を示し、フィードバックを用いた自己学習が人間生成データへの依存を減少させる可能性を示唆。 Comment

解説ポスト:

Reinforcement Learning: An Overview, Kevin Murphy, arXiv'24

Paper/Blog Link My Issue

#Tutorial #Pocket #ReinforcementLearning Issue Date: 2024-12-10 GPT Summary- この原稿は、深層強化学習と逐次的意思決定に関する最新の全体像を提供し、価値ベースのRL、ポリシー勾配法、モデルベース手法、RLとLLMsの統合について簡潔に議論しています。 Comment

あのMurphy本で有名なMurphy氏の強化学習の教科書…だと…

Online-LoRA: Task-free Online Continual Learning via Low Rank Adaptation, Xiwen Wei+, arXiv'24

Paper/Blog Link My Issue

#ComputerVision #Pocket #Supervised-FineTuning (SFT) #InstructionTuning #PEFT(Adaptor/LoRA) #Catastrophic Forgetting Issue Date: 2024-11-12 GPT Summary- 破滅的忘却に対処するため、タスクフリーのオンライン継続学習(OCL)フレームワークOnline-LoRAを提案。リハーサルバッファの制約を克服し、事前学習済みビジョントランスフォーマー(ViT)モデルをリアルタイムで微調整。新しいオンライン重み正則化戦略を用いて重要なモデルパラメータを特定し、データ分布の変化を自動認識。多様なベンチマークデータセットで優れた性能を示す。 Comment

LoRA vs Full Fine-tuning: An Illusion of Equivalence, Reece Shuttleworth+, arXiv'24

Paper/Blog Link My Issue

#Analysis #Pocket #NLP #LanguageModel #PEFT(Adaptor/LoRA) #read-later Issue Date: 2024-11-09 GPT Summary- ファインチューニング手法の違いが事前学習済みモデルに与える影響を、重み行列のスペクトル特性を通じて分析。LoRAと完全なファインチューニングは異なる構造の重み行列を生成し、LoRAモデルは新たな高ランクの特異ベクトル(侵入次元)を持つことが判明。侵入次元は一般化能力を低下させるが、同等の性能を達成することがある。これにより、異なるファインチューニング手法がパラメータ空間の異なる部分にアクセスしていることが示唆される。 Comment

元ポスト:

When Scaling Meets LLM Finetuning: The Effect of Data, Model and Finetuning Method, Biao Zhang+, N/A, ICLR'24

や Beyond Full Fine-tuning: Harnessing the Power of LoRA for Multi-Task Instruction Tuning, Xin+, LREC-COLING'24

、双方の知見も交えて、LoRAの挙動を考察する必要がある気がする。それぞれ異なるデータセットやモデルで、LoRAとFFTを比較している。時間がないが後でやりたい。

あと、昨今はそもそも実験設定における変数が多すぎて、とりうる実験設定が多すぎるため、個々の論文の知見を鵜呑みにして一般化するのはやめた方が良い気がしている。

# 実験設定の違い

## モデルのアーキテクチャ

- 本研究: RoBERTa-base(transformer-encoder)

- When Scaling Meets LLM Finetuning: The Effect of Data, Model and Finetuning Method, Biao Zhang+, N/A, ICLR'24

: transformer-decoder

- Beyond Full Fine-tuning: Harnessing the Power of LoRA for Multi-Task Instruction Tuning, Xin+, LREC-COLING'24

: transformer-decoder(LLaMA)

## パラメータサイズ

- 本研究:

- When Scaling Meets LLM Finetuning: The Effect of Data, Model and Finetuning Method, Biao Zhang+, N/A, ICLR'24

: 1B, 2B, 4B, 8B, 16B

- Beyond Full Fine-tuning: Harnessing the Power of LoRA for Multi-Task Instruction Tuning, Xin+, LREC-COLING'24

: 7B

時間がある時に続きをかきたい

## Finetuningデータセットのタスク数

## 1タスクあたりのデータ量

## trainableなパラメータ数

ADOPT: Modified Adam Can Converge with Any $β_2$ with the Optimal Rate, Shohei Taniguchi+, NeurIPS'24

Paper/Blog Link My Issue

#Pocket #Optimizer Issue Date: 2024-11-06 GPT Summary- ADOPTという新しい適応勾配法を提案し、任意のハイパーパラメータ$\beta_2$で最適な収束率を達成。勾配の二次モーメント推定からの除去と更新順序の変更により、Adamの非収束問題を解決。広範なタスクで優れた結果を示し、実装はGitHubで公開。 Comment

画像は元ツイートからの引用:

ライブラリがあるようで、1行変えるだけですぐ使えるとのこと。

元ツイート:

Adamでは収束しなかった場合(バッチサイズが小さい場合)でも収束するようになっている模様

Stuffed Mamba: State Collapse and State Capacity of RNN-Based Long-Context Modeling, Yingfa Chen+, arXiv'24

Paper/Blog Link My Issue

#Pocket #NLP #LongSequence #SSM (StateSpaceModel) Issue Date: 2024-11-05 GPT Summary- RNNの長いコンテキスト処理の課題を研究し、状態崩壊(SC)とメモリ容量の制限に対処。Mamba-2モデルを用いて、SC緩和手法を提案し、1Mトークン以上の処理を実現。256Kコンテキスト長で高精度のパスキー取得を達成し、RNNの長コンテキストモデリングの可能性を示唆。

NEFTune: Noisy Embeddings Improve Instruction Finetuning, Neel Jain+, N_A, ICLR'24

Paper/Blog Link My Issue

#Pocket #Supervised-FineTuning (SFT) Issue Date: 2024-10-27 GPT Summary- NEFTuneは、埋め込みベクトルにノイズを加えることで言語モデルのファインチューニングを改善する手法です。LLaMA-2-7Bを用いた標準的なファインチューニングでは29.79%の精度でしたが、ノイジーな埋め込みを使用することで64.69%に向上しました。NEFTuneは、Evol-Instruct、ShareGPT、OpenPlatypusなどの指示データセットでも改善をもたらし、RLHFで強化されたLLaMA-2-Chatにも効果があります。 Comment

ランダムノイズをembeddingに加えて学習するシンプルな手法。モデルがロバストになる。

Unsupervised SimCSEと思想が似ている。実質DataAugmentationともみなせる。

KTO: Model Alignment as Prospect Theoretic Optimization, Kawin Ethayarajh+, N_A, ICML'24

Paper/Blog Link My Issue

#Pocket #NLP #LanguageModel #Alignment #ICML #PostTraining Issue Date: 2024-10-27 GPT Summary- プロスペクト理論に基づき、LLMの人間フィードバック調整におけるバイアスの影響を示す。新たに提案する「人間認識損失」(HALOs)を用いたアプローチKTOは、生成物の効用を最大化し、好みベースの方法と同等またはそれ以上の性能を発揮。研究は、最適な損失関数が特定の設定に依存することを示唆。 Comment

binaryフィードバックデータからLLMのアライメントをとるKahneman-Tversky Optimization (KTO)論文

The Illusion of State in State-Space Models, William Merrill+, N_A, ICML'24

Paper/Blog Link My Issue

#Analysis #Pocket #NLP #SSM (StateSpaceModel) #ICML Issue Date: 2024-08-27 GPT Summary- SSM(状態空間モデル)は、トランスフォーマーよりも優れた状態追跡の表現力を持つと期待されていましたが、実際にはその表現力は制限されており、トランスフォーマーと類似しています。SSMは複雑性クラス$\mathsf{TC}^0$の外での計算を表現できず、単純な状態追跡問題を解決することができません。このため、SSMは実世界の状態追跡問題を解決する能力に制限がある可能性があります。 Comment

>しかし、SSMが状態追跡の表現力で本当に(トランスフォーマーよりも)優位性を持っているのでしょうか?驚くべきことに、その答えは「いいえ」です。私たちの分析によると、SSMの表現力は、トランスフォーマーと非常に類似して制限されています:SSMは複雑性クラス$\mathsf{TC}^0$の外での計算を表現することができません。特に、これは、置換合成のような単純な状態追跡問題を解決することができないことを意味します。これにより、SSMは、特定の表記法でチェスの手を正確に追跡したり、コードを評価したり、長い物語の中のエンティティを追跡することが証明上できないことが明らかになります。

なん…だと…

Knowledge Fusion of Large Language Models, Fanqi Wan+, N_A, ICLR'24

Paper/Blog Link My Issue

#Pocket #NLP #LanguageModel #ICLR #read-later #ModelMerge Issue Date: 2024-01-23 GPT Summary- 本研究では、既存の事前訓練済みの大規模言語モデル(LLMs)を統合することで、1つの強力なモデルを作成する方法を提案しています。異なるアーキテクチャを持つ3つの人気のあるLLMsを使用して、ベンチマークとタスクのパフォーマンスを向上させることを実証しました。提案手法のコード、モデルの重み、およびデータはGitHubで公開されています。

Transformers are Multi-State RNNs, Matanel Oren+, N_A, EMNLP'24

Paper/Blog Link My Issue

#NLP #Transformer #EMNLP Issue Date: 2024-01-16 GPT Summary- 本研究では、トランスフォーマーのデコーダーは無限マルチステートRNNとして概念化できることを示し、有限のマルチステートRNNに変換することも可能であることを示します。さらに、新しいキャッシュ圧縮ポリシーであるTOVAを導入し、他のポリシーよりも優れた性能を示すことを実験結果で示しました。TOVAは元のキャッシュサイズの1/8しか使用せず、トランスフォーマーデコーダーLLMが実際にはRNNとして振る舞うことが多いことを示しています。 Comment

TransformerはRNNとは異なる概念、特に全てのトークンの情報に直接アクセスできるということで区別されてきたが、よくよく考えてみると、Transformer Decoderは、RNNのhidden_states h を(hは1つのstateをベクトルで表している)、multi-stateを表す matrix H (t個のstateを表すmatrix; tは現在の着目しているトークンまでのsequenceの長さ)で置き換えたもの Multi-State-RNN (MSRNN) と解釈できる、という話。

また、window attentionなどのattentionの計算で考慮するKV cacheのスパンを(メモリを節約するために)制限する圧縮手法は、先ほどのMSRNNは全トークンのstate (KV Cache)にアクセスできる(= Unbounded)と考えると、アクセスできるトークンのstateが k (

実際に式で表すと以下のようにRNNとTransformerは対応づけられる。

このことを考慮して、本研究ではTOVAと呼ばれる新しいKV Cacheの圧縮手法を提案している。非常にシンプルな手法で、KV Cacheがメモリの上限に到達したときに、その際にattention scoreが最も小さいトークンのKV Cacheを捨てる、という手法である。

TOVAをwindow attentionなどのベースラインとオラクルとしてfull attentionと比較。タスクは Language Modeling(PG-19データにおけるPerplexity)、Language Understanding (long contextからrelevantな情報を拾う必要があるQA)、Story Generation(長文のストーリーを書かせてGPT4によってpair-wiseで生成されたストーリーの品質をLLM-as-a-Judgeさせる)を利用。既存のKV Cache圧縮手法よりも効率的にKV Cacheを圧縮でき、4096 context windowの場合は、512程度でfull attentionと近い性能を示すことが示された。これにより、高いメモリ効率とスループットを実現できる。ここで、グラフのx軸のmultistateはTOVAにおいてはmatrix Hで保持するstate数に相当し、window attentionでは、window sizeに相当する。

Detecting Pretraining Data from Large Language Models, Weijia Shi+, N_A, ICLR'24

Paper/Blog Link My Issue

#Pretraining #NLP #LanguageModel #ICLR Issue Date: 2023-10-26 GPT Summary- 本研究では、大規模言語モデル(LLMs)を訓練するためのデータの検出問題を研究し、新しい検出方法であるMin-K% Probを提案します。Min-K% Probは、LLMの下で低い確率を持つアウトライアーワードを検出することに基づいています。実験の結果、Min-K% Probは従来の方法に比べて7.4%の改善を達成し、著作権のある書籍の検出や汚染された下流の例の検出など、実世界のシナリオにおいて効果的な解決策であることが示されました。 Comment

実験結果を見るにAUCは0.73-0.76程度であり、まだあまり高くない印象。また、テキストのlengthはそれぞれ32,64,128,256程度。

openreview: https://openreview.net/forum?id=zWqr3MQuNs

Large Language Models as Optimizers, Chengrun Yang+, N_A, ICLR'24

Paper/Blog Link My Issue

#Pocket #NLP #LanguageModel #AutomaticPromptEngineering #ICLR Issue Date: 2023-09-09 GPT Summary- 本研究では、最適化タスクを自然言語で記述し、大規模言語モデル(LLMs)を使用して最適化を行う手法「Optimization by PROmpting(OPRO)」を提案しています。この手法では、LLMが以前の解とその値を含むプロンプトから新しい解を生成し、評価して次の最適化ステップのためのプロンプトに追加します。実験結果では、OPROによって最適化された最良のプロンプトが、人間が設計したプロンプトよりも優れていることが示されました。 Comment

`Take a deep breath and work on this problem step-by-step. `論文

# 概要

LLMを利用して最適化問題を解くためのフレームワークを提案したという話。論文中では、linear regressionや巡回セールスマン問題に適用している。また、応用例としてPrompt Engineeringに利用している。

これにより、Prompt Engineeringが最適か問題に落とし込まれ、自動的なprompt engineeringによって、`Let's think step by step.` よりも良いプロンプトが見つかりましたという話。

# 手法概要

全体としての枠組み。meta-promptをinputとし、LLMがobjective functionに対するsolutionを生成する。生成されたsolutionとスコアがmeta-promptに代入され、次のoptimizationが走る。これを繰り返す。

Meta promptの例

openreview: https://openreview.net/forum?id=Bb4VGOWELI

CausalLM is not optimal for in-context learning, Nan Ding+, N_A, ICLR'24

Paper/Blog Link My Issue

#Analysis #Pocket #NLP #LanguageModel #In-ContextLearning #ICLR Issue Date: 2023-09-01 GPT Summary- 最近の研究では、トランスフォーマーベースのインコンテキスト学習において、プレフィックス言語モデル(prefixLM)が因果言語モデル(causalLM)よりも優れたパフォーマンスを示すことがわかっています。本研究では、理論的なアプローチを用いて、prefixLMとcausalLMの収束挙動を分析しました。その結果、prefixLMは線形回帰の最適解に収束する一方、causalLMの収束ダイナミクスはオンライン勾配降下アルゴリズムに従い、最適であるとは限らないことがわかりました。さらに、合成実験と実際のタスクにおいても、causalLMがprefixLMよりも性能が劣ることが確認されました。 Comment

参考:

CausalLMでICLをした場合は、ICL中のdemonstrationでオンライン学習することに相当し、最適解に収束しているとは限らない……?が、hillbigさんの感想に基づくと、結果的には実は最適解に収束しているのでは?という話も出ているし、よく分からない。

LoraHub: Efficient Cross-Task Generalization via Dynamic LoRA Composition, Chengsong Huang+, N_A, COLM'24

Paper/Blog Link My Issue

#NLP #LanguageModel #Supervised-FineTuning (SFT) #PEFT(Adaptor/LoRA) #COLM #PostTraining Issue Date: 2023-08-08 GPT Summary- 本研究では、大規模言語モデル(LLMs)を新しいタスクに適応させるための低ランク適応(LoRA)を検討し、LoraHubというフレームワークを提案します。LoraHubを使用すると、少数の例から複数のLoRAモジュールを組み合わせて柔軟に適応性のあるパフォーマンスを実現できます。また、追加のモデルパラメータや勾配は必要ありません。実験結果から、LoraHubが少数の例でのインコンテキスト学習のパフォーマンスを効果的に模倣できることが示されています。さらに、LoRAコミュニティの育成と共有リソースの提供にも貢献しています。 Comment

学習されたLoRAのパラメータをモジュールとして捉え、新たなタスクのinputが与えられた時に、LoRA Hub上の適切なモジュールをLLMに組み合わせることで、ICL無しで汎化を実現するというアイデア。few shotのexampleを人間が設計する必要なく、同等の性能を達成。

複数のLoRAモジュールは組み合わられるか?element wiseの線型結合で今回はやっているが、その疑問にこたえたのがcontribution

OpenReview: https://openreview.net/forum?id=TrloAXEJ2B

Lost in the Middle: How Language Models Use Long Contexts, Nelson F. Liu+, N_A, TACL'24

Paper/Blog Link My Issue

#Analysis #NLP #LanguageModel #Prompting #In-ContextLearning #TACL #ContextEngineering Issue Date: 2023-07-11 GPT Summary- 最近の言語モデルは、長い文脈を入力として受け取ることができますが、その長い文脈をどれだけうまく利用しているかについてはまだよくわかっていません。この研究では、マルチドキュメントの質問応答とキー・バリューの検索という2つのタスクにおいて、言語モデルのパフォーマンスを分析しました。その結果、関連情報が入力文脈の始まりや終わりにある場合、パフォーマンスが最も高くなることがわかりましたが、長い文脈の中で関連情報にアクセスする必要がある場合、パフォーマンスが著しく低下します。さらに、入力文脈が長くなるにつれて、明示的に長い文脈を扱うモデルでもパフォーマンスが大幅に低下します。この分析は、言語モデルが入力文脈をどのように利用しているかをより良く理解するためのものであり、将来の長い文脈モデルのための新しい評価プロトコルを提供します。 Comment

元ツイート

非常に重要な知見がまとめられている

1. モデルはコンテキストのはじめと最後の情報をうまく活用でき、真ん中の情報をうまく活用できない

2. 長いコンテキストのモデルを使っても、コンテキストをより短いコンテキストのモデルよりもうまく考慮できるわけではない

3. モデルのパフォーマンスは、コンテキストが長くなればなるほど悪化する

SNLP'24での解説スライド:

https://speakerdeck.com/kichi/snlp2024

[Paper Note] DetectGPT: Zero-Shot Machine-Generated Text Detection using Probability Curvature, Eric Mitchell+, ICML'23, 2023.01

Paper/Blog Link My Issue

#Pocket #NLP #LanguageModel #ICML #Selected Papers/Blogs #text #AI Detector Issue Date: 2025-11-17 GPT Summary- LLM生成テキストの検出の必要性を背景に、対数確率関数の負の曲率を利用した新しい検出手法「DetectGPT」を提案。これにより、別の分類器やデータセットを必要とせず、特定のLLMから生成されたテキストを高精度で識別可能。特に、GPT-NeoXによるフェイクニュース記事の検出で、従来の手法を大幅に上回る性能を示した。

[Paper Note] Prodigy: An Expeditiously Adaptive Parameter-Free Learner, Konstantin Mishchenko+, arXiv'23, 2023.06

Paper/Blog Link My Issue

#Pocket #Optimizer #learning-rate-free Issue Date: 2025-10-26 GPT Summary- 学習率の推定問題に対処するため、Prodigyというアルゴリズムを提案。これはD-Adaptation手法を修正し、収束率を改善。12のベンチマークデータセットでテストした結果、ProdigyはD-Adaptationを上回り、手動調整されたAdamに近い精度を達成。 Comment

openreview: https://openreview.net/forum?id=WpQbM1kBuy

[Paper Note] Scaling laws for single-agent reinforcement learning, Jacob Hilton+, arXiv'23, 2023.01

Paper/Blog Link My Issue

#Single #Pocket #ReinforcementLearning #Scaling Laws Issue Date: 2025-10-13 GPT Summary- 生成モデルにおけるクロスエントロピー損失の改善がモデルサイズと計算量に依存することが示され、これを強化学習に拡張する際の課題として、平均エピソードリターンの変化が滑らかでないことが挙げられる。これを解決するために、内因的パフォーマンスを導入し、モデルサイズに応じた最小計算量を定義。さまざまな環境で内因的パフォーマンスが冪法則に従ってスケールすることを確認し、最適なモデルサイズも同様にスケールすることを示した。特に、MNISTベースの環境でタスクのホライズン長がこの関係に与える影響を調査した。 Comment

日本語解説: https://www.slideshare.net/slideshow/dlscaling-laws-for-singleagent-reinforcement-learning/255893696

[Paper Note] Flow Straight and Fast: Learning to Generate and Transfer Data with Rectified Flow, Xingchao Liu+, ICLR'23, 2022.09

Paper/Blog Link My Issue

#ComputerVision #Pocket #ICLR #Selected Papers/Blogs #RectifiedFlow Issue Date: 2025-10-10 GPT Summary- rectified flowという新しいアプローチを提案し、2つの分布間での輸送を学習するODEモデルを用いる。これは、直線的な経路を学習することで計算効率を高め、生成モデルやドメイン転送において統一的な解決策を提供する。rectificationを通じて、非増加の凸輸送コストを持つ新しい結合を生成し、再帰的に適用することで直線的なフローを得る。実証研究では、画像生成や翻訳において優れた性能を示し、高品質な結果を得ることが確認された。 Comment

openreview: https://openreview.net/forum?id=XVjTT1nw5z

日本語解説(fmuuly, zenn):

- Rectified Flow 1:

https://zenn.dev/fmuuly/articles/37cc3a2f17138e

- Rectified Flow 2:

https://zenn.dev/fmuuly/articles/a062fcd340207f

- Rectified Flow 3:

https://zenn.dev/fmuuly/articles/0f262fc003e202

Inference-Time Intervention: Eliciting Truthful Answers from a Language Model, Kenneth Li+, NeurIPS'23

Paper/Blog Link My Issue

#Pocket #NLP #LanguageModel #Hallucination #NeurIPS #read-later #ActivationSteering/ITI #Probing #Trustfulness #Selected Papers/Blogs Issue Date: 2025-05-09 GPT Summary- Inference-Time Intervention (ITI)を提案し、LLMsの真実性を向上させる技術を紹介。ITIは推論中にモデルの活性化を調整し、LLaMAモデルの性能をTruthfulQAベンチマークで大幅に改善。Alpacaモデルでは真実性が32.5%から65.1%に向上。真実性と有用性のトレードオフを特定し、介入の強度を調整する方法を示す。ITIは低コストでデータ効率が高く、数百の例で真実の方向性を特定可能。LLMsが虚偽を生成しつつも真実の内部表現を持つ可能性を示唆。 Comment

Inference Time Interventionを提案した研究。Attention Headに対して線形プロービング[^1]を実施し、真実性に関連するであろうHeadをtopKで特定できるようにし、headの出力に対し真実性を高める方向性のベクトルvを推論時に加算することで(=intervention)、モデルの真実性を高める。vは線形プロービングによって学習された重みを使う手法と、正答と誤答の活性化の平均ベクトルを計算しその差分をvとする方法の二種類がある。後者の方が性能が良い。topKを求める際には、線形プロービングをしたモデルのvalidation setでの性能から決める。Kとαはハイパーパラメータである。

[^1]: headのrepresentationを入力として受け取り、線形モデルを学習し、線形モデルの2値分類性能を見ることでheadがどの程度、プロービングの学習に使ったデータに関する情報を保持しているかを測定する手法

日本語解説スライド:

https://www.docswell.com/s/DeepLearning2023/Z38P8D-2024-06-20-131813#p1

これは相当汎用的に使えそうな話だから役に立ちそう

Dataset Distillation: A Comprehensive Review, Ruonan Yu+, arXiv'23

Paper/Blog Link My Issue

#Survey #Pocket #Dataset #Distillation Issue Date: 2025-03-25 GPT Summary- データセット蒸留(DD)は、深層学習における膨大なデータのストレージやプライバシーの問題を軽減する手法であり、合成サンプルを含む小さなデータセットを生成することで、元のデータセットと同等の性能を持つモデルをトレーニング可能にする。本論文では、DDの進展と応用をレビューし、全体的なアルゴリズムフレームワークを提案、既存手法の分類と理論的相互関係を議論し、DDの課題と今後の研究方向を展望する。 Comment

訓練データセット中の知識を蒸留し、オリジナルデータよりも少量のデータで同等の学習効果を得るDataset Distillationに関するSurvey。

Scaling Data-Constrained Language Models, Niklas Muennighoff+, NeurIPS'23

Paper/Blog Link My Issue

#Pocket #NLP #LanguageModel #NeurIPS #Scaling Laws #read-later #Selected Papers/Blogs #KeyPoint Notes Issue Date: 2025-03-23 GPT Summary- 言語モデルのスケーリングにおいて、データ制約下でのトレーニングを調査。9000億トークンと90億パラメータのモデルを用いた実験で、繰り返しデータを使用しても損失に大きな変化は見られず、繰り返しの価値が減少することを確認。計算最適性のスケーリング法則を提案し、データ不足を軽減するアプローチも実験。得られたモデルとデータセットは公開。 Comment

OpenReview: https://openreview.net/forum?id=j5BuTrEj35

チンチラ則のようなScaling Lawsはパラメータとデータ量の両方をスケールさせた場合の前提に立っており、かつデータは全てuniqueである前提だったが、データの枯渇が懸念される昨今の状況に合わせて、データ量が制限された状況で、同じデータを繰り返し利用する(=複数エポック学習する)ことが一般的になってきた。このため、データのrepetitionに関して性能を事前学習による性能の違いを調査して、repetitionとパラメータ数に関するスケーリング則を提案($3.1)しているようである。

Takeawayとしては、データが制限された環境下では、repetitionは上限4回までが効果的(コスパが良い)であり(左図)、小さいモデルを複数エポック訓練する方が固定されたBudgetの中で低いlossを達成できる右図)。

学習データの半分をコードにしても性能の劣化はなく、様々なタスクの性能が向上しパフォーマンスの分散も小さくなる、といったことが挙げられるようだ。

Zero Bubble Pipeline Parallelism, Penghui Qi+, arXiv'23

Paper/Blog Link My Issue

#Pocket Issue Date: 2024-12-16 GPT Summary- 本研究では、パイプライン並列性の効率を向上させるために、ゼロパイプラインバブルを達成する新しいスケジューリング戦略を提案。逆伝播計算を二つに分割し、手作業で設計した新しいパイプラインスケジュールは、ベースライン手法を大幅に上回る性能を示した。さらに、最適なスケジュールを自動的に見つけるアルゴリズムと、オプティマイザステップ中の同期を回避する技術を導入。実験結果では、スループットが最大23%向上し、メモリ制約が緩和されると31%まで改善。実装はオープンソースで提供。

Sparse Upcycling: Training Mixture-of-Experts from Dense Checkpoints, Aran Komatsuzaki+, ICLR'23

Paper/Blog Link My Issue

#Pretraining #Pocket #NLP #LanguageModel #Supervised-FineTuning (SFT) #MoE(Mixture-of-Experts) #PostTraining Issue Date: 2024-11-25 GPT Summary- スパース活性化モデルは、計算コストを抑えつつ密なモデルの代替として注目されているが、依然として多くのデータを必要とし、ゼロからのトレーニングは高コストである。本研究では、密なチェックポイントからスパース活性化Mixture-of-Expertsモデルを初期化する「スパースアップサイクリング」を提案。これにより、初期の密な事前トレーニングのコストを約50%再利用し、SuperGLUEやImageNetで密なモデルを大幅に上回る性能を示した。また、アップサイクリングされたモデルは、ゼロからトレーニングされたスパースモデルよりも優れた結果を得た。 Comment

斜め読みしかできていないが、Mixture-of-Expertsを用いたモデルをSFT/Pretrainingする際に、既存のcheckpointの重みを活用することでより効率的かつ性能向上する方法を提案。MoE LayerのMLPを全て既存のcheckpointにおけるMLPの重みをコピーして初期化する。Routerはスクラッチから学習する。

継続事前学習においては、同じ学習時間の中でDense Layerを用いるベースラインと比較してでより高い性能を獲得。

Figure2で継続事前学習したモデルに対して、フルパラメータのFinetuningをした場合でもUpcyclingは効果がある(Figure3)。

特にPretrainingではUpcyclingを用いたモデルの性能に、通常のMoEをスクラッチから学習したモデルが追いつくのに時間がかかるとのこと。特に図右側の言語タスクでは、120%の学習時間が追いつくために必要だった。

Sparse Upcycingと、Dense tilingによる手法(warm start; 元のモデルに既存の層を複製して新しい層を追加する方法)、元のモデルをそれぞれ継続事前学習すると、最も高い性能を獲得している。

(すごい斜め読みなのでちょっも自信なし、、、)

VeRA: Vector-based Random Matrix Adaptation, Dawid J. Kopiczko+, N_A, arXiv'23

Paper/Blog Link My Issue

#EfficiencyImprovement #Supervised-FineTuning (SFT) #PEFT(Adaptor/LoRA) Issue Date: 2024-01-17 GPT Summary- 本研究では、大規模な言語モデルのfine-tuningにおいて、訓練可能なパラメータの数を削減するための新しい手法であるベクトルベースのランダム行列適応(VeRA)を提案する。VeRAは、共有される低ランク行列と小さなスケーリングベクトルを使用することで、同じ性能を維持しながらパラメータ数を削減する。GLUEやE2Eのベンチマーク、画像分類タスクでの効果を示し、言語モデルのインストラクションチューニングにも応用できることを示す。

NEFTune: Noisy Embeddings Improve Instruction Finetuning, Neel Jain+, N_A, arXiv'23

Paper/Blog Link My Issue

#NLP #LanguageModel #Supervised-FineTuning (SFT) Issue Date: 2023-10-26 GPT Summary- 私たちは、言語モデルのファインチューニングを改善するために、ノイズを加えた埋め込みベクトルを使用する手法を提案します。この手法は、AlpacaEvalやEvol-Instructなどのデータセットで強力なベースラインを上回る性能を示しました。また、RLHFでトレーニングされたモデルにも適用可能です。 Comment

Alpacaデータでの性能向上が著しい。かなり重要論文な予感。後で読む。

HuggingFaceのTRLでサポートされている

https://huggingface.co/docs/trl/sft_trainer

Eliminating Reasoning via Inferring with Planning: A New Framework to Guide LLMs' Non-linear Thinking, Yongqi Tong+, N_A, arXiv'23

Paper/Blog Link My Issue

#Pocket #NLP #LanguageModel #Chain-of-Thought #Prompting Issue Date: 2023-10-24 GPT Summary- 本研究では、大規模言語モデル(LLMs)に非線形の思考を促すために、新しいプロンプティング方法であるInferential Exclusion Prompting(IEP)を提案する。IEPは、計画を立てて可能な解を推論し、逆推論を行うことで広い視点を得ることができる。IEPは他の手法と比較して複雑な人間の思考プロセスをシミュレートできることを実証し、LLMsのパフォーマンス向上にも貢献することを示した。さらに、Mental-Ability Reasoning Benchmark(MARB)を導入し、LLMsの論理と言語推論能力を評価するための新しいベンチマークを提案した。IEPとMARBはLLMsの研究において有望な方向性であり、今後の進展が期待される。 Comment

元論文は読んでいないのだが、CoTが線形的だという主張がよくわからない。

CoTはAutoregressiveな言語モデルに対して、コンテキストを自己生成したテキストで利用者の意図した方向性にバイアスをかけて補完させ、

利用者が意図した通りのアウトプットを最終的に得るためのテクニック、だと思っていて、

線形的だろうが非線形的だろうがどっちにしろCoTなのでは。

Why Do We Need Weight Decay in Modern Deep Learning?, Maksym Andriushchenko+, N_A, arXiv'23

Paper/Blog Link My Issue

#Pocket #Regularization Issue Date: 2023-10-11 GPT Summary- ウェイト減衰は、大規模な言語モデルのトレーニングに使用されるが、その役割はまだ理解されていない。本研究では、ウェイト減衰が古典的な正則化とは異なる役割を果たしていることを明らかにし、過パラメータ化されたディープネットワークでの最適化ダイナミクスの変化やSGDの暗黙の正則化の強化方法を示す。また、ウェイト減衰が確率的最適化におけるバイアス-分散トレードオフのバランスを取り、トレーニング損失を低下させる方法も説明する。さらに、ウェイト減衰はbfloat16混合精度トレーニングにおける損失の発散を防ぐ役割も果たす。全体として、ウェイト減衰は明示的な正則化ではなく、トレーニングダイナミクスを変えるものであることが示される。 Comment

参考:

WeightDecayは目的関数に普通にL2正則化項を加えることによって実現されるが、深掘りするとこんな効果があるのね

openreview: https://openreview.net/forum?id=RKh7DI23tz

Benchmarking Large Language Models As AI Research Agents, Qian Huang+, N_A, arXiv'23

Paper/Blog Link My Issue

#Pocket #NLP #Dataset #LanguageModel #AIAgents #Evaluation #AutoML Issue Date: 2023-10-09 GPT Summary- 本研究では、AI研究エージェントを構築し、科学的な実験のタスクを実行するためのベンチマークとしてMLAgentBenchを提案する。エージェントはファイルの読み書きやコードの実行などのアクションを実行し、実験を実行し、結果を分析し、機械学習パイプラインのコードを変更することができる。GPT-4ベースの研究エージェントは多くのタスクで高性能なモデルを実現できるが、成功率は異なる。また、LLMベースの研究エージェントにはいくつかの課題がある。 Comment

GPT4がMLモデルをどれだけ自動的に構築できるかを調べた模様。また、ベンチマークデータを作成した模様。結果としては、既存の有名なデータセットでの成功率は90%程度であり、未知のタスク(新たなKaggle Challenge等)では30%程度とのこと。

Boolformer: Symbolic Regression of Logic Functions with Transformers, Stéphane d'Ascoli+, N_A, arXiv'23

Paper/Blog Link My Issue

#Pocket #Transformer Issue Date: 2023-10-09 GPT Summary- この研究では、BoolformerというTransformerアーキテクチャを使用して、ブール関数のシンボリック回帰を実行する方法を紹介します。Boolformerは、クリーンな真理値表やノイズのある観測など、さまざまなデータに対して効果的な式を予測することができます。さらに、実世界のデータセットや遺伝子制御ネットワークのモデリングにおいて、Boolformerは解釈可能な代替手法として優れた性能を発揮します。この研究の成果は、公開されています。 Comment

ブール関数をend-to-endで学習できるtransformeiアーキテクチャを提案した模様

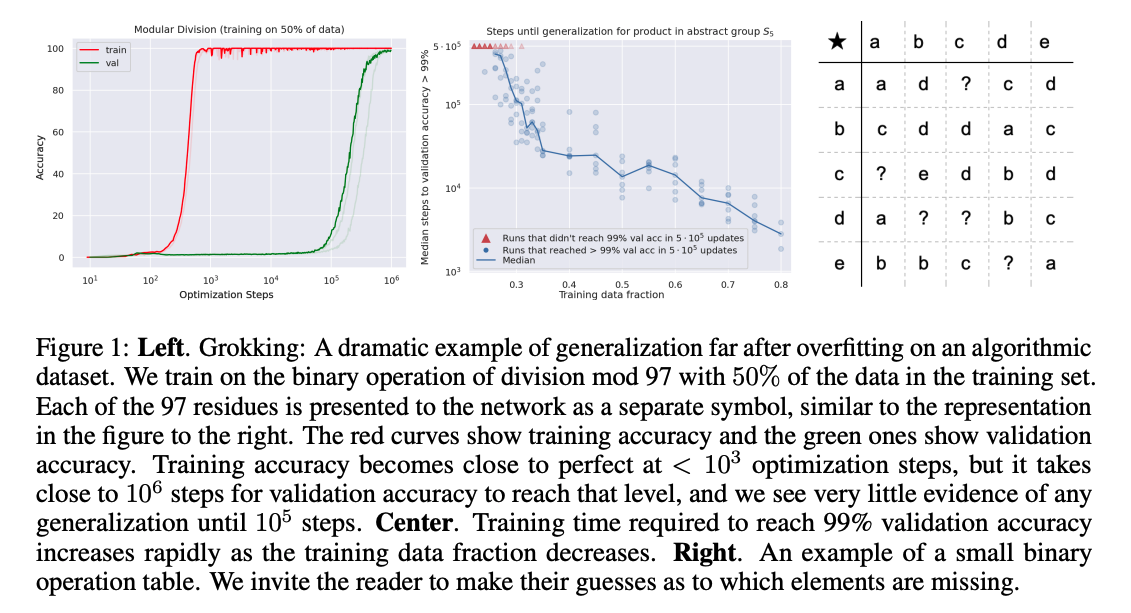

Explaining grokking through circuit efficiency, Vikrant Varma+, N_A, arXiv'23

Paper/Blog Link My Issue

#NeuralNetwork #Pocket #Grokking Issue Date: 2023-09-30 GPT Summary- グロッキングとは、完璧なトレーニング精度を持つネットワークでも一般化が悪い現象のことである。この現象は、タスクが一般化する解と記憶する解の両方を許容する場合に起こると考えられている。一般化する解は学習が遅く、効率的であり、同じパラメータノルムでより大きなロジットを生成する。一方、記憶回路はトレーニングデータセットが大きくなるにつれて非効率になるが、一般化回路はそうではないと仮説が立てられている。これは、記憶と一般化が同じくらい効率的な臨界データセットサイズが存在することを示唆している。さらに、グロッキングに関して4つの新しい予測が立てられ、それらが確認され、説明が支持される重要な証拠が提供されている。また、グロッキング以外の2つの新しい現象も示されており、それはアングロッキングとセミグロッキングである。アングロッキングは完璧なテスト精度から低いテスト精度に逆戻りする現象であり、セミグロッキングは完璧なテスト精度ではなく部分的なテスト精度への遅れた一般化を示す現象である。 Comment

Grokkingがいつ、なぜ発生するかを説明する理論を示した研究。

理由としては、最初はmemorizationを学習していくのだが、ある時点から一般化回路であるGenに切り替わる。これが切り替わる理由としては、memorizationよりも、genの方がlossが小さくなるから、とのこと。これはより大規模なデータセットで顕著。

Grokkingが最初に報告された研究は GROKKING: GENERALIZATION BEYOND OVERFIT- TING ON SMALL ALGORITHMIC DATASETS, Power+, ICLR'21 Workshop

LongLoRA: Efficient Fine-tuning of Long-Context Large Language Models, Yukang Chen+, N_A, arXiv'23

Paper/Blog Link My Issue